Правильный robots.txt для MODX Revo

MODX Revo

MODX RevoАвтор Алексей На чтение 2 мин. Опубликовано

Последнее изменение поста: 24 октября 2018 в 0:49

Сегодня мы составим правильный robots.txt для MODX Revo. Данный файл в первую очередь создается для того что бы закрыть дубли страниц от индексации в поисковых системах.

Как создать robots.txt для MODX Revo

Перед тем как начать вы должны включить ЧПУ MODX в настройках сайта.

robots.txt можно создать 2-мя способами:

Первый — прямо на компьютере при помощи блокнота создать текстовый документ с именем robots и расширением txt.

Второй — непосредственно в самом modx (создать документ — и в настройках выбрать тип содержимого txt)

Выбирайте любой способ, который больше нравится. Ну а теперь самое главное.

Правильный robots.txt для MODX Revo

User-agent: * Disallow: /cgi-bin Disallow: /manager/ Disallow: /assets/components/ Disallow: /core/ Disallow: /connectors/ Disallow: /index.php Disallow: *? Allow: /core/cache/phpthumb/*.jpeg Allow: /core/cache/phpthumb/*.png Allow: /core/cache/phpthumb/*.svg Host: сайт.ru Sitemap: http://сайт.ru/sitemap.xml

Краткий разбор «роботс» для CMS MODX

Disallow — запрещает индексирование

Allow — разрешает индексирование

- cgi-bin — данная папка есть практически на каждом хостинге и в ней зачастую хранятся файлы конфигураций

- index.php — это дубль главной страницы сайта

- с помощью *? мы удаляем дубли для всех страниц

С остальным думаю понятно, если нет то спрашивайте в комментариях и если есть предложения по модернизации robots.txt тоже указывайте в комментариях.

Правильный Robots.txt для MODx (2020) — как сделать?

Сайты на системе администрирования MODx встречаются не так часто, информацию по правильной настройке SEO для этой системы найти сложнее. В этой статье рассмотрим один из наиболее важных вопросов оптимизации сайта — составление правильного файла robots.txt. С одной стороны, размещение текстового файла в корне сайта является одной из самых простых задач оптимизации. С другой стороны, малейшая ошибка в файле роботс может привести к нехорошим последствиям вплоть до закрытия всего сайта от индексации и, следовательно, исчезновения его из поиска.

Более подробно о составлении robots.txt и значении всех его директив я писал здесь. Я не буду подробно останавливаться на значении каждого правила. Ограничусь тем, что кратко прокомментирую что для чего необходимо. Ниже представлены коды Robots, которые являются базовыми, универсальными для любого сайта на соответствующей версии MODx. В то же время, нужно понимать, что у каждого сайта существуют свои особенности, разработчик мог внести изменения в архитектуру папок сайта для своего удобства таким образом, что файл будет важно скорректировать. Поэтому лучше всего, если файл robots проверит и скорректирует специалист по SEO конкретно для вашего сайта.

Правильный Robots.txt для MODx

Команды подходят как для MODx Revolution, так и для MODx Evolution. В некоторых статьях попадалась информация с файлами robots, отличающимися для Revo и Evo. Однако основная причина отличий в файлах — разные источники и непонимание автора, что данные команды обозначают.

User-agent: * # правила для всех роботов Disallow: /cgi-bin # папка на хостинге Disallow: /manager/ # авторизация Disallow: /assets/ # папка с системными файлами modx Disallow: /core/ # папка с системными файлами modx Disallow: /connectors/ # папка с системными файлами modx Disallow: /index.php # дубли страниц index.php Disallow: *?* # ссылки с параметрами Disallow: *utm*= # ссылки с utm-метками Disallow: *openstat= # ссылки с метками openstat Disallow: *from= # ссылки с метками from Allow: /assets/*.jpg # здесь и далее открываем для индексации изображения, файлы и скрипты Allow: /assets/*.jpeg Allow: /assets/*.gif Allow: /assets/*.png Allow: /assets/*.pdf Allow: /assets/*.doc Allow: /assets/*.docx Allow: /assets/*.xls Allow: /assets/*.xlsx Allow: /assets/*.ppt Allow: /assets/*.pptx Allow: /assets/*.js Allow: /assets/*.css Allow: *?page= # открываем для индексации страницы пагинации (и проверьте, чтобы для них был настроен canonical) # Укажите один или несколько файлов Sitemap Sitemap: http://site.ru/sitemap.xml Sitemap: http://site.ru/sitemap.xml.gz # Укажите главное зеркало сайта, как в примере ниже (с WWW / без WWW, если HTTPS # то пишем протокол, если нужно указать порт, указываем). Команда стала необязательной. Ранее Host понимал # Яндекс и Mail.RU. Теперь все основные поисковые системы команду Host не учитывают. Host: www.site.ru

В примере я не добавляю правило Crawl-Delay, т.к. в большинстве случаев эта директива не нужна. Однако если у вас крупный нагруженный ресурс, то использование этой директивы поможет снизить нагрузку на сайт со стороны роботов Яндекса, Mail.Ru, Bing, Yahoo и других (Google не учитывает). Подробнее про это читайте в статье Robots.txt.

Оцените статью

Загрузка…

Загрузка…Друзья, буду благодарен за ваши вопросы, дополнения и рекомендации по теме статьи. Пишите ниже в комментариях.

Буду благодарен, если поставите оценку статье.

Создание и настройка robots.txt для MODX Revolution

После создания файла sitemap.xml самое время сказать поисковым роботам, где нужно и где не нужно искать на нашем сервере (в том числе тот же sitemap.xml). Создание файла robots.txt для этих нужд при использовании MODX Revolution, в целом, не сильно отличается от прочих случаев. Однако, мы можем упростить поисковым роботам жизнь, если учтём в robots.txt каталоги этой CMS.

После создания файла sitemap.xml самое время сказать поисковым роботам, где нужно и где не нужно искать на нашем сервере (в том числе тот же sitemap.xml). Создание файла robots.txt для этих нужд при использовании MODX Revolution, в целом, не сильно отличается от прочих случаев. Однако, мы можем упростить поисковым роботам жизнь, если учтём в robots.txt каталоги этой CMS.Самый простой и универсальный способ создания файла robots.txt это создать его непосредственно на своём компьютере, а затем загрузить в корень сайта. Просто откройте текстовый редактор, создайте файл с именем robots и задайте ему расширение txt.

Другой способ создать robots.txt для MODX Revolution — создать его непосредственно из «админки». Сразу скажу, что «универсального» или «правильного» файла robots.txt не существует. Вы наполняете его в соответствии с вашими потребностями. Ниже я приведу пример такого файла и прокомментирую его содержимое.

User-agent: * Disallow: /cgi-bin/ Disallow: /manager/ Disallow: /assets/components/ Disallow: /core/ Disallow: /connectors/ Disallow: /index.php Disallow: *? Allow: /core/cache/phpthumb/*.jpeg Allow: /core/cache/phpthumb/*.png Allow: /core/cache/phpthumb/*.svg Host: [URL-сайта] Sitemap: [URL-сайта]/sitemap.xml

Первая строчка (User-agent: *) говорит нам о том, что настройки применяются ко всем поисковым роботам.

Строки, начинающиеся с Disallow, запрещают индексирование указанных каталогов. Какие каталоги мы закрыли?

cgi-bin — папка для CGI-скриптов, может содержать файлы конфигурации;

manager — каталог админ-панели MODX;

assets/components — каталог с дополнениями;

core — каталог ядра CMS;

connectors — каталог точек входа для AJAX-запросов;

index.php — дубль главной страницы сайта;

Ну а *? поможет избавиться от дублей страниц.

Отметим, что даже если вы не собираетесь ничего закрывать, оставьте в файле строку

Disallow:

Дело в том, что инструкция Disallow является обязательной в robots.txt, и без неё робот может «не понять» файл.

Строки, которые начинаются с Allow, открывают доступ к определенным частям сайта. На самом деле, поисковый робот сканирует всё, что не помечено Disallow, но что делать, если нужно открыть доступ к определенным файлам или подкаталогам в закрытом каталоге? Тогда и используется Allow. Так, хотя мы и закрыли доступ к папке core, но разрешаем сканирование изображений в /core/cache/phpthumb/.

Директива Host нужна для поискового робота Яндекса. Если вы используете протокол HTTPS, то URL сайта в этой строке нужно указать с ним. При использовании HTTP протокол указывать не нужно. Однако, в свете последних событий, использование директивы Host выглядит не обязательным.

Наконец, мы указываем поисковым работам точное расположение файла sitemap.xml.

После окончания редактирования положите файл robots.txt в корень сайта (обычно каталог public_html).

MODX Revolution. Создание файла robots.txt

Файл robots.txt запрещает (разрешает) индексирование и посещение поисковыми роботами файлов из указанных в нём директорий. Давайте создадим файл robots.txt для MODX Revo.

Войдите в панель администратора: ваш_домен/manager/

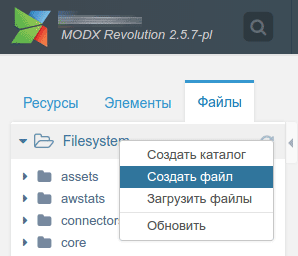

В левой части находим вкладку: Файлы → Filesystem. Правой кнопкой мыши нажимаем на Filesystem и выбираем Создать файл:

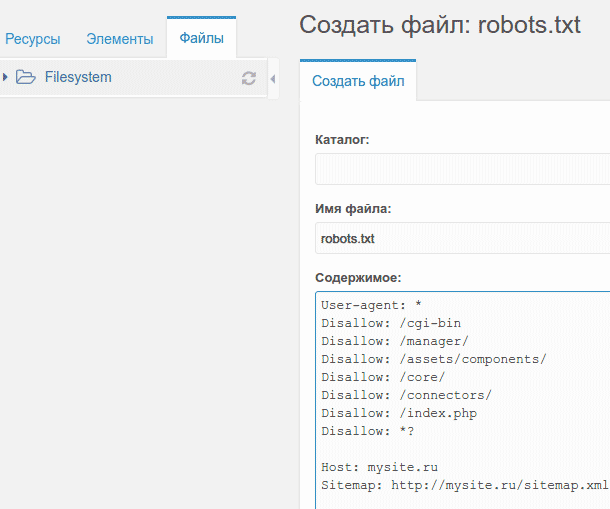

В открывшемся окне в поле Имя файла необходимо прописать robots.txt, в поле Содержимое:

User-agent: * Disallow: /cgi-bin Disallow: /manager/ Disallow: /assets/components/ Disallow: /core/ Disallow: /connectors/ Disallow: /index.php Disallow: *? Host: mysite.ru Sitemap: http://mysite.ru/sitemap.xml

Для понимания:

User-agent: * — для всех поисковых роботов;

Disallow: — закрыть для индексирования;

/cgi-bin — каталог, который содержит (или не содержит — пустой) серверные скрипты. Как правило, есть на всех хостингах;

/manager/, /assets/components/, /core/, /connectors/ — директории, которые поисковые роботы не будут индексировать;/index.php — это дубль главной страницы сайта;

*? — удаляем дубли для всех страниц;

mysite.ru — поменяйте на ваш домен.

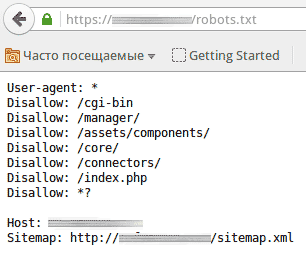

Сохраните файл и проверьте его по адресу: https://ваш_домен/robots.txt

СВами

MODX Revolution. Настройка ЧПУ

MODX Revolution. Настройка файла .htaccess, ЧПУ и SEO

Яндекс, файл robots.txt и поисковая индексация сайта

Настройка правильных файлов robots.txt и .htaccess для MODX Revolution

Для удачного SEO продвижения веб-сайта на Modx Revolution необходимо правильно настроить файл robots.txt

Файл robots.txt для Modx — текстовый файл в формате .txt, ограничивающий поисковым роботам доступ к содержимому на http-сервере.

Файл .htaccess — файл дополнительной конфигурации для веб-сервера Apache и ему подобных.

Настройка файлов:

Изначально необходимо сделать так, что бы все странички были без добавочных окончаний типа .html .php, а смотрелись к примеру вот так:

http://yotadom.com/index

http://yotadom.com/about

Контейнеры в свою очередь без слешей в конце, вот таким образом:

http://modx.cc/novosti

Для этого входим:

Система — Типы содержимого далее text/html и в text extensions стираем .html, сохраняем.

Далее:

Система→Настройки системы→Дружественные URL по фильтру и в Суффикс контейнера стираем слеш.

Настройка файла .htaccess для ModxRevo

В случае если движок расположен не в корневой директории, а в подпапке, то будет:

<IfModulemod_rewrite.c> Options +FollowSymlinks RewriteEngine On RewriteBase /subdirectory/

Веб-сайт обязан располагать лишь одним именем с www или без www, раскоментируйте необходимые строки в корневом файле .htaccess

К примеру, если без www, то:

RewriteCond %{HTTP_HOST} .

RewriteCond %{ HTTP_HOST } !^example-domain-please-change\.com [NC]

RewriteRule (.*) http://www.example-domain-please-change.com/$1 [R=301,L]

Добавляем строчки для переадресации со странички со слешем в конце, для того что бы не 404 открывалась:

# Remove trailing slash

RewriteRule^(manager)/*$ — [L] # exclude manager folder

RewriteCond %{REQUEST_URI} (.*)/

RewriteRule ^(.*)/$ http://example.com/$1 [R=301,L]

В случае если в начале и конце странички 404 появляются каки-то символы, необходимо добавить в файл .htaccess еще строки:

SetEnv force-no-vary SetEnv downgrade-1.0

В случае если есть сложности с кодировкой, то нужно добавить:

AddDefaultCharset utf8

ROBOTS.TXT

User-agent: * Disallow: /assets/ Disallow: /connectors/ Disallow: /core/ Disallow: /manager/ Disallow: /? Disallow: /*?id= Host: modx.cc

MODx robots txt

Файл robots.txt содержит инструкции для поисковых роботов, которые указывают на структуру сайта и помогают им определить, какой контент необходимо проиндексировать, а какой должен быть закрыт от индексации.

Рекомендуется закрывать от индексации весь мусор на сайте и весь дублирующий контент, или контент который не представляет для пользователя никакого интереса. К примеру, я закрываю результаты поиска на сайте, по скольку это дублирующая информация, а также все системыне файлы движка.

Далее я предлагаю ознакомиться с корректным содержимым файла robots.txt:

User-agent: Yandex

Disallow: /assets/cache/

Disallow: /assets/docs/

Disallow: /assets/export/

Disallow: /assets/import/

Disallow: /assets/modules/

Disallow: /assets/plugins/

Disallow: /assets/snippets/

Disallow: /assets/packages/

Disallow: /assets/tvs/

Disallow: /install/

Disallow: /manager/

User-agent: Google

Disallow: /assets/cache/

Disallow: /assets/docs/

Disallow: /assets/export/

Disallow: /assets/import/

Disallow: /assets/modules/

Disallow: /assets/plugins/

Disallow: /assets/snippets/

Disallow: /assets/packages/

Disallow: /assets/tvs/

Disallow: /install/

Disallow: /manager/

User-agent: Mail.ru

Disallow: /assets/cache/

Disallow: /assets/docs/

Disallow: /assets/export/

Disallow: /assets/import/

Disallow: /assets/modules/

Disallow: /assets/plugins/

Disallow: /assets/snippets/

Disallow: /assets/packages/

Disallow: /assets/tvs/

Disallow: /install/

Disallow: /manager/

User-agent: *

Disallow: /assets/cache/

Disallow: /assets/docs/

Disallow: /assets/export/

Disallow: /assets/import/

Disallow: /assets/modules/

Disallow: /assets/plugins/

Disallow: /assets/snippets/

Disallow: /assets/packages/

Disallow: /assets/tvs/

Disallow: /install/

Disallow: /manager/

Host: http://site.ru

Sitemap: http://site.ru/sitemap.xml

Я рекомендую указывать инструкции для каждого поисковика, который представляет для вас интерес по отдельности, а также для указать инструкцию для всех других поисковиков.

User-agent — указывает на поисковик, дял которого пишется инструкция.

Allow — разрешает индексацию.

Disallow — запрещает индексацию.

Host — указывает на основной хост.

Sitemap — указывает поисковику на xml карту сайта.

начальная seo оптимизация сайта: правильный robots, настройка htaccess, установка счетчика яндекс метрики и др.

Тематический трафик – альтернативный подход в продвижении бизнеса

Получи нашу книгу «Контент-маркетинг в социальных сетях: Как засесть в голову подписчиков и влюбить их в свой бренд».

Подпишись на рассылку и получи книгу в подарок!

CMS MODx имеет большую популярность среди разработчиков и как следствие SEO специалистам приходится с ней работать. Сложностей в продвижении сайтов на MODx нет, если при старте сделать правильную SEO оптимизацию проекта.

Первый этап

SEO оптимизация начинается с закрытия различных дублей на проекте

robots.txt для MODx evolution

ser-agent: * Disallow: /assets/cache/ Disallow: /assets/docs/ Disallow: /assets/export/ Disallow: /assets/import/ Disallow: /assets/modules/ Disallow: /assets/plugins/ Disallow: /assets/snippets/ Disallow: /install/ Disallow: /manager/ Disallow: /? Disallow: /*? Disallow: /index.php Host: endseo.ru Sitemap: http://endseo.ru/sitemap.xml

robots.txt для MODx revolution

User-agent: * Disallow: /manager/ Disallow: /assets/components/ Disallow: /core/ Disallow: /connectors/ Disallow: /index.php Disallow: *? Host: endseo.ru Sitemap: http://endseo.ru/sitemap.xml

Установка Яндекс Метрики или Google Analytics в MODX

Самый простой и легкий вариант — это просто установить счетчик. Код счетчика необходимо поставить в шаблон layout.tpl

Также для Яндекс Метрики существуют 2 плагина:

- Плагин для подключения Yandex.Metrika в MODx

- Модуль Яндекс.Метрика для CMS MODx Evolution

Настройка ЧПУ в MODx

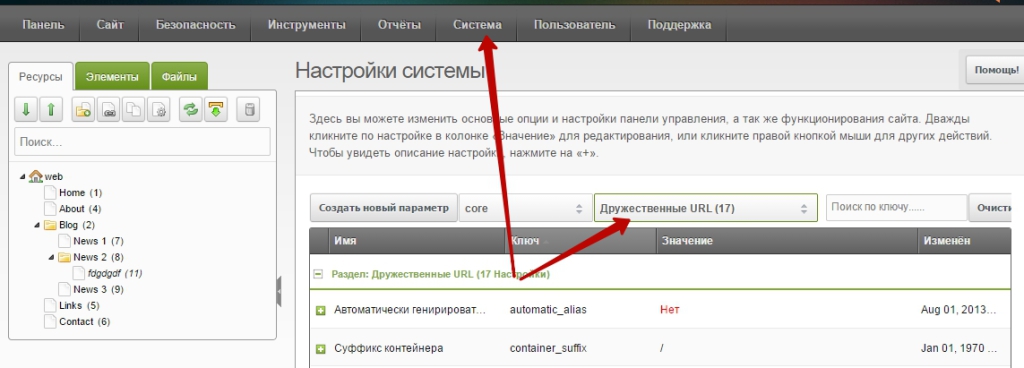

«Система» (System ) –> «Настройки системы» (System settings) –> выбираем «Дружественные URL» (Friendly URL):

Выбираем следующие значения:

- автоматически генирировать псевдоним – ставим «Нет»;

- использовать дружественные URL – «Да»;

- использовать вложенные урлы – «Да».

Потом установите «дополнение Translit» (modx.com/extras/package/translit)

.htaccess для MODX revolution

Что важно для этой CMS? Для директории “public_html“ :

<IfModule mod_rewrite.c> Options +FollowSymlinks RewriteEngine On RewriteBase / </IfModule>

Для “subdirectory“:

<IfModule mod_rewrite.c> Options +FollowSymlinks RewriteEngine On RewriteBase /subdirectory/ </IfModule>

Сайт с www или без www в MODX через .htaccess

Для поисковых систем важно, чтобы была одна версия сайта. Какая из них вам по душе — выбирайте сами, но правильнее бы без www:

для сайта с www:

RewriteCond %{HTTP_HOST} .

RewriteCond %{HTTP_HOST} !^www\.example-domain-please-change\.com [NC]

RewriteRule (.*) http://www.example-domain-please-change.com/$1 [R=301,L]

для сайта без www

RewriteCond %{HTTP_HOST} .

RewriteCond %{HTTP_HOST} !^example-domain-please-change\.com [NC]

RewriteRule (.*) http://example-domain-please-change.com/$1 [R=301,L]