Первая поисковая система

Moonspell

Автор:

Автор: 02 июля 2015 15:28

Современные поисковые системы просты и удобны в использовании, чем не могли похвастаться их предшественники. Найти с их помощью необходимую информацию было крайне сложно, они требовали огромных, по тем временам, сетевых ресурсов, выводя из строя веб-сервера.

Сегодня поисковая система — это один из самых широко используемых методов навигации в киберпространстве. Она представляет собой веб-сайт, предоставляющий возможность поиска информации в Интернете. Основной его частью является поисковая машина, или поисковый движок — комплекс программ, обеспечивающий функциональность поисковой системы. Основными критериями качества работы поисковой машины являются степень соответствия запроса и найденного результата, полнота базы, учёт морфологии языка.

Первая поисковая интернет-система появилась в 1989 году, ее автором был студент информатики Монреальского Университета им. Мак Гилла Алан Эмтадж. Первый поисковик назывался Archie (от искаженного слова archive — «архив»). Программа собирала в единую базу данных имена файлов публичных ftp-серверов. Однако сами файлы «Archie» не индексировала.

Первая поисковая интернет-система появилась в 1989 году, ее автором был студент информатики Монреальского Университета им. Мак Гилла Алан Эмтадж. Первый поисковик назывался Archie (от искаженного слова archive — «архив»). Программа собирала в единую базу данных имена файлов публичных ftp-серверов. Однако сами файлы «Archie» не индексировала.Следующим этапом в истории поисковых систем стало появление сетевого протокола Gopher. Его автором был Марк Мак Кахилл из Университета Миннесоты. Протокол индексировал текстовые документы и предоставлял к ним доступ в Интернете.

Чуть позже два ученых из Университета Невады, Фред Барри и Стивен Фостер, разработали программу Veronica. В Veronica можно было осуществлять поиск по ключевому слову среди названий документов, перечисленных в Gopher.

Вскоре после ее появления был создан еще один поисковый инструмент — Jughead. Он имел подобные функциональные возможности, как и у Veronica, но при этом в него были добавлены логические возможности поиска. Jughead позволял получать информационное меню с различных серверов Gopher.

Первый сетевой робот

В 1993 году студент Массачусетского технологического института Мэтью Грей создал первого робота, который индексировал страницы Интернета. Назывался он World Wide Web Wanderer, буквально — «странник по Всемирной паутине». Прежде опись сетевых ресурсов составлялась вручную. Программа позволяла пересчитывать веб-серверы, измеряя масштабы Паутины. База сайтов, собранная при помощи первого робота, получила название Wandex. Однако с течением времени эта база становилась все менее пригодной для поиска, и постепенно утратила актуальность для пользователей. Поисковые роботы первого поколения были крайне медлительными и попросту не успевали за ростом всемирной Сети. Проблемы с автоматическим сбором информации привели к появлению принципиально иной концепции поисковой системы. Так возникла система ALIWEB- первый глобальный каталог (или директория) ресурсов Всемирной паутины. Ее базу данных наполняла не программа-робот, а хозяин сайта или веб-страницы.

В 1993 году студент Массачусетского технологического института Мэтью Грей создал первого робота, который индексировал страницы Интернета. Назывался он World Wide Web Wanderer, буквально — «странник по Всемирной паутине». Прежде опись сетевых ресурсов составлялась вручную. Программа позволяла пересчитывать веб-серверы, измеряя масштабы Паутины. База сайтов, собранная при помощи первого робота, получила название Wandex. Однако с течением времени эта база становилась все менее пригодной для поиска, и постепенно утратила актуальность для пользователей. Поисковые роботы первого поколения были крайне медлительными и попросту не успевали за ростом всемирной Сети. Проблемы с автоматическим сбором информации привели к появлению принципиально иной концепции поисковой системы. Так возникла система ALIWEB- первый глобальный каталог (или директория) ресурсов Всемирной паутины. Ее базу данных наполняла не программа-робот, а хозяин сайта или веб-страницы.  Прибыльный бизнес

Прибыльный бизнесПосле того, как бизнесмены поняли, что из Интернета можно извлечь выгоду, началось усиленное финансирование развития поисковых систем. Стали появляться все новые и новые поисковики с усовершенствованным набором функций.

Так, в 1993 году шесть студентов Стэнфорда представили Excite. Программа использовала статистический анализ слов в тексте, чтобы облегчить процесс поиска в Интернете. Годом позже возникла сеть Galaxy — первый доступный для поиска интернет-справочник. В том же 1994 году была представлена программа WebCrawler. Это была первая поисковая машина, которая индексировала весь текст веб-сайтов. В отличие от своих предшественников, она позволяла пользователям искать по любым ключевым словам на любой веб-странице — с тех пор это стало стандартом во всех основных поисковых системах. Кроме того, это был первый поисковик, о котором было известно в широких кругах пользователей. Тогда же доктор Майкл Молдин разработал поисковую машину Lycos. Наряду с результатами поиска она предлагала ссылки на темы, связанные с поисковым запросом. В 1995 году появилась система AltaVista, которая первой предложила расширенную систему поиска. Кроме того, она принимала языковые запросы на так называемом «естественном языке», то есть Alta Vista могла производить поиск не только по одному ключевому слову, но и по целой фразе. Кроме того, система предлагала возможность поиска изображений, музыки и видеофайлов.

В некотором смысле все эти поисковые системы конкурировали с популярными интернет-каталогами, такими, как Yahoo!. Yahoo! появился в 1994 году. Его авторами были Джерри Янг и Дэвид Фило. Проект начался с составления каталога их любимых веб-сайтов. Единственное, что отличало этот перечень от других, был комментарий к каждой ссылке URL. Через год разработчики получили финансирование и создали корпорацию Yahoo!.

В некотором смысле все эти поисковые системы конкурировали с популярными интернет-каталогами, такими, как Yahoo!. Yahoo! появился в 1994 году. Его авторами были Джерри Янг и Дэвид Фило. Проект начался с составления каталога их любимых веб-сайтов. Единственное, что отличало этот перечень от других, был комментарий к каждой ссылке URL. Через год разработчики получили финансирование и создали корпорацию Yahoo!.

Авторский пост

Ссылки по теме:

Понравился пост? Поддержи Фишки, нажми:

Новости партнёров

Поисковая система — это… Что такое Поисковая система?

Поиско́вая систе́ма — программно-аппаратный комплекс с веб-интерфейсом, предоставляющий возможность поиска информации в Интернете. Под поисковой системой обычно подразумевается сайт, на котором размещён интерфейс (фронт-энд) системы. Программной частью поисковой системы является поисковая машина (поисковый движок) — комплекс программ, обеспечивающий функциональность поисковой системы и обычно являющийся коммерческой тайной компании-разработчика поисковой системы.Большинство поисковых систем ищут информацию на сайтах Всемирной паутины, но существуют также системы, способные искать файлы на FTP-серверах, товары в интернет-магазинах, а также информацию в группах новостей Usenet.

Улучшение поиска — это одна из приоритетных задач современного Интернета (см. про основные проблемы в работе поисковых систем в статье Глубокая паутина).

По данным компании Net Applications,[1] в ноябре 2011 года использование поисковых систем распределялось следующим образом:

История

| Хронология | ||

|---|---|---|

| Год | Система | Событие |

| 1993 | W3Catalog | Запуск |

| Aliweb | Запуск | |

| JumpStation | Запуск | |

| 1994 | WebCrawler | Запуск |

| Infoseek | Запуск | |

| Lycos | Запуск | |

| 1995 | AltaVista | Запуск |

| Daum | Основание | |

| Open Text Web Index | Запуск | |

| Magellan | Запуск | |

| Excite | Запуск | |

| SAPO | Запуск | |

| Yahoo! | Запуск | |

| 1996 | Dogpile | Запуск |

| Inktomi | Основание | |

| HotBot | Основание | |

| Ask Jeeves | Основание | |

| 1997 | Northern Light | Запуск |

| Яндекс | Запуск | |

| 1998 | Запуск | |

| 1999 | AlltheWeb | Запуск |

| GenieKnows | Основание | |

| Naver | Запуск | |

| Teoma | Основание | |

| Vivisimo | Основание | |

| 2000 | Baidu | Основание |

| Exalead | Основание | |

| 2003 | Info.com | Запуск |

| 2004 | Yahoo! Search | Окончательный запуск |

| A9.com | Запуск | |

| Sogou | Запуск | |

| 2005 | MSN Search | Окончательный запуск |

| Ask.com | Запуск | |

| GoodSearch | Запуск | |

| SearchMe | Основание | |

| 2006 | wikiseek | Основание |

| Quaero | Основание | |

| Ask.com | Запуск | |

| Live Search | Запуск | |

| ChaCha | Запуск (бета) | |

| Guruji.com | Запуск (бета) | |

| 2007 | wikiseek | Запуск |

| Sproose | Запуск | |

| Wikia Search | Запуск | |

| Blackle.com | Запуск | |

| 2008 | DuckDuckGo | Запуск |

| Tooby | Запуск | |

| Picollator | Запуск | |

| Viewzi | Запуск | |

| Cuil | Запуск | |

| Boogami | Запуск | |

| LeapFish | Запуск (бета) | |

| Forestle | Запуск | |

| VADLO | Запуск | |

| Powerset | Запуск | |

| 2009 | Bing | Запуск |

| KAZ.KZ | Запуск | |

| Yebol | Запуск (бета) | |

| Mugurdy | Закрытие | |

| Goby | Запуск | |

| 2010 | Яндекс (англ.) | Запуск |

| Cuil | Закрытие | |

| Blekko | Запуск (бета) | |

| Viewzi | Закрытие | |

| 2012 | WAZZUB | Запуск |

Одним из первых инструментов поиска в интернете (до Всемирной паутины) был Archie.

Первой поисковой системой для Всемирной паутины был «Wandex», уже не существующий индекс, который создавал «World Wide Web Wanderer» — бот, разработанный Мэтью Грэем (англ. Matthew Gray) из Массачусетского технологического института в 1993. Также в 1993 году появилась поисковая система «Aliweb», работающая до сих пор. Первой полнотекстовой (т. н. «crawler-based», то есть индексирующей ресурсы при помощи робота) поисковой системой стала «WebCrawler», запущенная в 1994. В отличие от своих предшественников, она позволяла пользователям искать по любым ключевым словам на любой веб-странице — с тех пор это стало стандартом во всех основных поисковых системах. Кроме того, это был первый поисковик, о котором было известно в широких кругах. В 1994 был запущен «Lycos», разработанный в университете Карнеги Мелона.

Вскоре появилось множество других конкурирующих поисковых машин, таких как «Excite», «Infoseek», «Inktomi», «Northern Light» и «AltaVista». В некотором смысле они конкурировали с популярными интернет-каталогами, такими, как «Yahoo!». Позже каталоги соединились или добавили к себе поисковые машины, чтобы увеличить функциональность. В 1996 году русскоязычным пользователям интернета стало доступно морфологическое расширение к поисковой машине Altavista и оригинальные российские поисковые машины «Рамблер» и «Апорт». 23 сентября 1997 была открыта поисковая машина Яндекс.

В последнее время завоёвывает всё большую популярность практика применения методов кластерного анализа и поиска по метаданным. Из международных машин такого плана наибольшую известность получила «Clusty» компании Vivísimo. В 2005 году на российских просторах при поддержке МГУ запущен поисковик «Нигма», поддерживающий автоматическую кластеризацию. В 2006 году открылась российская метамашина Quintura, предлагающая визуальную кластеризацию в виде облака тегов. «Нигма» тоже экспериментировала[2] с визуальной кластеризацией.

Помимо поисковых машин для Всемирной паутины, существовали и поисковики для других протоколов, такие как Archie для поиска по анонимным FTP-серверам и «Veronica» для поиска в Gopher.

Популярные поисковые системы

Согласно данным LiveInternet в 2012 году об охвате русскоязычных поисковых запросов:

- Всеязычные:

- Google (24,9 %)

- Bing (0,8 %)

- Yahoo! (0,2 %) и принадлежащие этой компании поисковые машины:

- Англоязычные и международные:

- AskJeeves (механизм Teoma)

- Русскоязычные — большинство «русскоязычных» поисковых систем индексируют и ищут тексты на многих языках — украинском, белорусском, английском, татарском и др. Отличаются же они от «всеязычных» систем, индексирующих все документы подряд, тем, что в основном индексируют ресурсы, расположенные в доменных зонах, где доминирует русский язык или другими способами ограничивают своих роботов русскоязычными сайтами.

Некоторые из поисковых систем используют внешние алгоритмы поиска. Так, Qip.ru использует поисковый механизм Яндекса, а Nigma сочетает в себе как свой алгоритм, так и сборную выдачу от других поисковиков.

Необычные поисковые системы

- DuckDuckGo — гибридная поисковая система с политикой конфиденциальности пользователя и его поисковых запросов.

- Koogle (с его помощью ортодоксальные иудеи могли найти контент, признанный раввинами удовлетворяющим религиозным требованиям).[3]

- Yauba (индийский поиск «для параноиков» — в отличие от привычных поисковиков, за пользователями не следят, а все записи о его действиях удаляются с сервера).[3]

- TinEye — поисковая система, специализирующаяся на поиске изображений в Интернете. С недавнего времени теряет свою актуальность, после того, как Google ввел такую функцию в своем поиске по картинкам.

- Генон — поисковая система, собирающая и создающая контент у себя на сайте.

- ImHalal — первый исламский поисковик. Новый поисковик может отличить разрешённые для мусульман (халяльные) результаты поиска от запретных (харамных). Был открыт в 2009 году. Ориентировочно с начала сентября 2011 прекратил функционирование в связи с недостатком финансирования.

См. также

Примечания

Литература

- Байков Владимир Дмитриевич. Интернет. Поиск информации. Продвижение сайтов. — СПб.: БХВ-Петербург, 2000. — 288 с. — ISBN 5-8206-0095-9

- Ашманов И. С., Иванов А. А. Продвижение сайта в поисковых системах. — М.: Вильямс, 2007. — 304 с. — ISBN 978-5-8459-1155-1

- Колисниченко Д. Н. Поисковые системы и продвижение сайтов в Интернете. — М.: Диалектика, 2007. — 272 с. — ISBN 978-5-8459-1269-5

- Ландэ Д. В. Поиск знаний в Internet. — М.: Диалектика, 2005. — 272 с. — ISBN 5-8459-0764-0

- Маннинг К., Рагхаван П., Шютце Х. Введение в информационный поиск. — Вильямс, 2011. — ISBN 978-5-8459-1623-5

Ссылки

Поисковые машины (список) Поисковые машины (список) | |

|---|---|

| Общие | |

| Региональные | Accoona (Китай/США) • Alleba (Филиппины) • Ansearch (Австралия/США/Великобритания/Новая Зеландия) • Апорт (Россия) • Daum (Юж. Корея) • Guruji.com (Индия) • Поиск@Mail.Ru (Россия) • Maktoob (Бл. Восток) • Meta.ua (Украина) • Miner.hu (Венгрия) • Najdi.si (Словения) • Onkosh (Бл. Восток) • Рамблер (Россия) • Rediff (Индия) • SAPO (Португалия) • Search.ch (Швейцария) • Sesam (Норвегия/Швеция) • Walla! (Израиль) |

| …лидеры | Baidu (Китай) • Naver (Юж. Корея) • Seznam (Чехия) • Yahoo! Japan (Япония) • Яндекс (Россия, СНГ, Турция) |

| Тематические | |

| Метапоиск | AskNet.ru • Brainboost • Clusty • Dogpile • FarSEER • exactus.ru • Excite • HotBot • Info.com • Ixquick • Krozilo • Mamma • Metacrawler • MetaLib • Нигма • Myriad Search • SideStep • Surfwax • Turbo10 • WebCrawler • GlobalFileSearch |

| Открытые / свободные | DataparkSearch • Egothor • Gonzui • Grub • Ht://dig • locust • Isearch • Lucene • Lemur Toolkit & Indri Search Engine • mnoGoSearch • Namazu • Nutch • OpenFTS • Sciencenet (научная, на технологии YaCy) • Wikia Search • Sphinx • SWISH-E • Terrier Search Engine • Xapian • YaCy • Zettair |

| Детские | AGAKIDS (Россия) • Ask Kids (Великобритания) • Frag Finn (Германия) • Kids AOL (США) • Kids Yahoo! (США) • Quintura Дети (Россия) • Семейный Яндекс (Россия) • Гогуль (Россия) |

Поисковые системы

Поиско́вая систе́ма — программно-аппаратный комплекс с веб-интерфейсом, предоставляющий возможность поиска информации в интернете.

Все поисковые системы объединяет то, что они расположены на специально-выделенных мощных серверах и привязаны к эффективным каналам связи. Поисковые системы называют еще информационно-поисковыми системами (ИПС). Количество одновременно обслуживаемых посетителей наиболее популярных систем достигает многих тысяч. Самые известные обслуживают в сутки миллионы клиентов. В случаях, когда поисковая система имеет в своей основе каталог, она называется каталогом. В ее основе лежит работа модераторов. В основе же ИПС с полнотекстовым поиском лежит автоматический сбор информации. Он осуществляется специальными программами. Эти программы периодически исследуют содержимое всех ресурсов Интернета. Для этого они перемещаются, или как говорят, ползают, по разным ресурсам. Соответственно такие программы называются роботы. Есть и другие названия: поскольку WWW – это аббревиатура выражения Всемирная паутина, то такую программу естественно назвать спайдером по англ. – паук. В последнее время используются другие названия: автоматические индексы или директории. Все эти программы исследуют и «скачивают» информацию с разных URL-адресов. Программы указанного типа посещают каждый ресурс через определенное время. Ни одна поисковая система не в состоянии проиндексировать весь Интернет. Поэтому БД, в которых собраны адреса проиндексированных ресурсов, у разных поисковых систем разные. Тем не менее, многие из них стремятся, по возможности, охватывать в своей работе все пространство мировой Сети.

Для поиска информации с помощью поисковой системы пользователь формулирует поисковый запрос. На основании запроса пользователя поисковая система генерируетстраницу результатов поиска. Такая поисковая выдача может сочетать различные типы файлов, например: веб-страницы, изображения, видеофайлы. Некоторые поисковые системы также извлекают данные из баз данных икаталогов ресурсов в Интернете.

По методам поиска и обслуживания разделяют четыре типа поисковых систем:

1.системы использующие поисковых роботов.

2.системы управляемые человеком

3.гибридные системы

4.мета-системы.

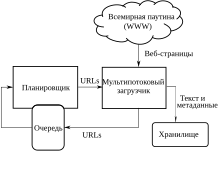

В архитектуру поисковой системы включены: поисковый робот сканирующий сайты сети Интернет, индексатор обеспечивающий быстрый поиск, и поисковик — графический интерфейс для работы пользователя.

Цель поисковой системы заключается в том, чтобы находить документы, содержащие либо ключевые слова, либо слова как-либо связанные с ключевыми словами. Поисковая система тем лучше, чем больше документов релевантных запросу пользователя она будет возвращать.

Примеры поисковых систем

Google— одна из самых полных и популярных зарубежных ИПС. Отличительной особенностью ИПС Google является технология определения степени релевантности документа путем анализа ссылок других источников на данный ресурс. Чем больше ссылок на какую-либо страницу имеется на других страницах, тем выше ее рейтинг в ИПС Google. Google использует алгоритм расчёта авторитетности PageRank. PageRank является одним из вспомогательных факторов приранжированиисайтов в результатах поиска. PageRank не единственный, но очень важный способ определенияположения сайтав результатах поиска Google. Google использует показатель PageRank найденных по запросу страниц, чтобы определить порядок выдачи этих страниц посетителю в результатах поиска.В 2010 году компания запустила голосовой поиск в России. Чтобы осуществить поиск, необходимо нажать в телефоне кнопку рядом со строкой поиска и произнести свой запрос, телефон отправит ваш голос на сервер, и браузер выдаст строку с распознанным вашим запросом и результатами поиска по нему.

Яndex – самая популярная в настоящее время отечественная поисковая система. Начала работу в 1997 г. Она поддерживает собственный каталог Интернет-ресурсов. Также является лучшей поисковой системой для выявления иллюстраций. Англоязычный вариант снабжен справочником ресурсов Интернет. Обладает развернутой системой формирования запроса. В частности, допускается ввод поискового предписания на естественном языке — в этом случае все необходимые расширения производятся автоматически.

Помимо веб-страниц в формате HTML, Яндекс индексирует документы в форматах PDF (Adobe Acrobat), Rich Text Format (RTF), двоичных форматах Word (.doc), Excel (.xls), PowerPoint(.ppt), RSS(блоги и форумы).

Поисковая система компании Mail.ruначала работать в 2007 году. Объем индексного файла весной 2009 г. составлял более 1.5 миллиарда страниц, расположенных на русскоязычных серверах. Помимо разыскания текстов, системой осуществляется поиск иллюстраций и видеофрагментов, размещенных на специализированных «самонаполняемых» российских серверах: Фото@Mail.Ru, Flamber.Ru, 35Photo.ru, PhotoForum.ru, Видео@Mail.Ru, RuTube, Loadup, Rambler Vision и им подобных. Gogo.ru позволяет ограничивать область поиска сайтами коммерческой направленности, информационными сайтами, а также форумами и блогами. Форма «Расширенного поиска» также дает возможность ограничить разыскания определенными типами файлов (PDF, DOC, XLS, PPT), местом положения искомых слов в документе или определенным доменом. В ноябре 2013 в Google Play появилась новая версия поискового приложения от компании Mail.Ru, позволяющего переходить с главного экрана в любые социальные сети и содержащего быстрый доступ к поиску по картинам, видео и новостям. Android-приложение превратилось в мини-браузер, заточенный под эффективный поиск нужной информации. Утилита также научилась распознавать поисковые запросы, заданные не текстом, а голосом. Разработчики также отмечают, что создали специальный виджет, который можно поместить на главный экран смартфона или планшета на базе системы Google Android. Подразумевается, что это позволит еще сильнее сократить время, затрачиваемое на поиск.

AltaVista– одна из старейших поисковых систем занимает одно из первых мест по объему документов – более 350 миллионов. AltaVista позволяет осуществлять простой и расширенный поиск. «Help» позволяет даже неподготовленным пользователям правильно составлять простые и сложные запросы.

Rambler – одна из первых российских ИПС, открыта в 1996 году. В конце 2002 года была произведена коренная модернизация, после которой Rambler вновь вошел в группу лидеров сетевого поиска. В настоящее время объем индекса составляет порядка 150 миллионов документов. Для составления сложных запросов рекомендуется использовать режим «Детальный запрос», который предоставляет широкие возможности для составления поискового предписания с помощью пунктов меню.

АПОРТ. На сегодняшний день объем ее базы составляет более 20 миллионов документов. Система обладает широким спектром поисковых возможностей. АПОРТ обладает функцией встроенного переводчика, это дает пользователю возможность формулировать запросы, как на русском, так и на английском языках. Кроме того, АПОРТ имеет специальные режимы для поиска иллюстраций и аудио файлов.

Поисковые механизмы последнего поколения индексируют все слова на web-странице или в статье из конференции, в то время как ранее область индексирования ограничивалась как правило названием, заголовками, первыми несколькими строками и адресом документа. Это существенно ограничивало возможность выявления материалов по узкой тематике, поскольку результаты поиска не всегда отражали реально существующие данные. Устранив этот недостаток, современные поисковые системы стали намного более надежными, чем их предшественники.

Следующая важнейшая черта — совершенствование внутреннего поискового механизма, выражающееся в увеличении числа операторов и других элементов составления запросов. Несколько лет назад применение находили только два, в лучшем случае, три классических булевых оператора: AND (и), OR (или) и NOT (не). Теперь появились NEAR (рядом, около) в Alta Vista и FOLLOWED BY (следует за) в OpenText — в высшей степени полезные операторы расстояния, которые дают возможность в максимальной степени конкретизировать запрос. Многие системы позволяют усекать окончания терминов, ограничивать поиск по дате создания документа, искать ключевые слова только в обозначенных элементах web-страниц (названии, заголовках, электронном адресе и т.д.), а также вести разыскание на точное словосочетание. Новейшие разработки также позволяют выявлять файлы определенного вида (например графические или аудио) и обладают чувствительностью к строчным и заглавным буквам. Общепринятой становится возможность искать данные на любых языках. Все это дает возможность составлять поисковое предписание с большой степенью точности, что конечно же повышает релевантность получаемых результатов.

На данный момент самые популярные поисковики Google и Яндекс, сравним их:

Количество проиндексированных страниц. У Google 8 миллиардов, а у Яндекса всего 2 миллиарда. То есть, в четыре раза меньше. Победа за Google.

Скорость индексации страниц. Google индексирует новые страницы в течение суток, тогда как Яндексу на это может потребоваться несколько дней. Опять побеждает Google.

Релевантность выдачи. Под релевантностью понимается соответствие результатов, отображенных на странице поисковика, вашему запросу. Сразу скажу, победителя тут сложно определить. Google показал хорошие результаты в зарубежном сегменте интернета, зато в Рунете, Яндекс всегда был немного впереди.

Дополнительные интернет сервисы. Тут преимущество однозначно за Яндексом. У него есть десятки разнообразных сервисов, которые удобно сгруппированы по категориям, тогда как у Google их поменьше, плюс есть интеграция с социальной сетью Google+, которая многим не нравится.

Wandex — Википедия

Материал из Википедии — свободной энциклопедии

Текущая версия страницы пока не проверялась опытными участниками и может значительно отличаться от версии, проверенной 1 сентября 2015; проверки требуют 10 правок. Текущая версия страницы пока не проверялась опытными участниками и может значительно отличаться от версии, проверенной 1 сентября 2015; проверки требуют 10 правок.Wandex — первая поисковая система Интернета в мире, осуществлявшая поиск по веб-сайтам.[1]

Первой системой, придуманной для нахождения информации во Всемирной паутине был «Wandex», уже не существующий индекс, который создавал «World Wide Web Wanderer» — бот на языке Perl, разработанный Мэтью Грэем (англ. Matthew Gray) из Массачусетского технологического института в 1993. Создатель «Вандекса» также принимал участие в разработке Apache[2], создании сайта MIT и других проектах. Ныне Мэтью Грэй является сотрудником компании Google.

Нужно отметить, что в 1993 году во всём Интернете насчитывалось всего лишь 623 веб-сайта[1], так что работы у «Вандекса» было поменьше, чем у современных поисковых систем. К тому же, благодаря таким скромным масштабам, для составления индексов и выдачи результатов не требовались ни мощные сервера с многоуровневой кластеризацией, ни сложная функциональность алгоритмов поиска и ухищрения по их оптимизации.

Wandex и другие первые сервисы имели весьма несовершенную систему поиска. При запросе слова они выдавали не наиболее релевантные ссылки, а все страницы, его содержащие, без анализа и ранжирования. Поэтому некоторое время реальными конкурентами поисковиков были каталоги страниц — сайты с вручную отсортированными коллекциями ссылок на веб-ресурсы.[3]

23 сентября 1997 была открыта поисковая машина Яндекс. К настоящему времени, благодаря её популярности, при слове «Wandex» многие обычно вспоминают как раз её.[1]

Главная страница Wandex[4]31 декабря 2011 стало известно о восстановлении Wandex, 1 января 2012 поисковый бот под именем World Wide Web Wanderer был зафиксирован владельцами многих сайтов, что стало поводом для обсуждений. В данный момент на главной странице расположена поисковая строка, над которой находится надпись «WANDEX». Буква «X» изображена в виде перекрещивающихся линий, одна из которых изображает лупу — часто используемый символ Интернет-поиска.

Главная страница Wandex

Поисковая система — Википедия

Поиск информации во Всемирной паутине был трудной и не самой приятной задачей, но с прорывом в технологии поисковых систем в конце 1990-х годов осуществлять поиск стало намного удобнейПоиско́вая систе́ма (англ. search engine) — это компьютерная система, предназначенная для поиска информации. Одно из наиболее известных применений поисковых систем — веб-сервисы для поиска текстовой или графической информации во Всемирной паутине. Существуют также системы, способные искать файлы на FTP-серверах, товары в интернет-магазинах, информацию в группах новостей Usenet.

Для поиска информации с помощью поисковой системы пользователь формулирует поисковый запрос[1]. Работа поисковой системы заключается в том, чтобы по запросу пользователя найти документы, содержащие либо указанные ключевые слова, либо слова, как-либо связанные с ключевыми словами[2]. При этом поисковая система генерирует страницу результатов поиска. Такая поисковая выдача может содержать различные типы результатов, например: веб-страницы, изображения, аудиофайлы. Некоторые поисковые системы также извлекают информацию из подходящих баз данных и каталогов ресурсов в Интернете.

Поисковая система тем лучше, чем больше документов, релевантных запросу пользователя, она будет возвращать. Результаты поиска могут становиться менее релевантными из-за особенностей алгоритмов (см. «Пузырь фильтров»[⇨]) или вследствие человеческого фактора[⇨]. По состоянию на 2015 год самой популярной поисковой системой в мире является Google, однако есть страны, где пользователи отдали предпочтение другим поисковикам. Так, например, в России «Яндекс» обгоняет Google больше, чем на 10 %[⇨].

По методам поиска и обслуживания разделяют четыре типа поисковых систем: системы, использующие поисковых роботов, системы, управляемые человеком, гибридные системы и мета-системы[⇨]. В архитектуру поисковой системы обычно входят:

- поисковый робот, собирающий информацию с сайтов сети Интернет или из других документов,

- индексатор, обеспечивающий быстрый поиск по накопленной информации, и

- поисковик — графический интерфейс для работы пользователя[⇨].

История

На раннем этапе развития сети Интернет Тим Бернерс-Ли поддерживал список веб-серверов, размещённый на сайте ЦЕРН[3]. Сайтов становилось всё больше, и поддерживать вручную такой список становилось всё сложнее. На сайте NCSA был специальный раздел «Что нового!» (англ. What’s New!)[4], где публиковали ссылки на новые сайты.

Первой компьютерной программой для поиска в Интернете была программа Арчи[en] (англ. archie — архив без буквы «в»). Она была создана в 1990 году Аланом Эмтэджем (Alan Emtage), Биллом Хиланом (Bill Heelan) и Дж. Питером Дойчем (J. Peter Deutsch), студентами, изучающими информатику в университете Макгилла в Монреале. Программа скачивала списки всех файлов со всех доступных анонимных FTP-серверов и строила базу данных, в которой можно было выполнять поиск по именам файлов. Однако, программа Арчи не индексировала содержимое этих файлов, так как объём данных был настолько мал, что всё можно было легко найти вручную.

Развитие и распространение сетевого протокола Gopher, придуманного в 1991 году Марком Маккэхилом (Mark McCahill) в университете Миннесоты, привело к созданию двух новых поисковых программ, Veronica[en] и Jughead[en]. Как и Арчи, они искали имена файлов и заголовки, сохранённые в индексных системах Gopher. Veronica (англ. Very Easy Rodent-Oriented Net-wide Index to Computerized Archives) позволяла выполнять поиск по ключевым словам большинства заголовков меню Gopher во всех списках Gopher. Программа Jughead (англ. Jonzy’s Universal Gopher Hierarchy Excavation And Display) извлекала информацию о меню от определённых Gopher-серверов. Хотя название поисковика Арчи не имело отношения к циклу комиксов «Арчи»[en], тем не менее Veronica и Jughead — персонажи этих комиксов.

К лету 1993 года ещё не было ни одной системы для поиска в вебе, хотя вручную поддерживались многочисленные специализированные каталоги. Оскар Нирштрасс (Oscar Nierstrasz) в Женевском университете написал ряд сценариев на Perl, которые периодически копировали эти страницы и переписывали их в стандартный формат. Это стало основой для W3Catalog, первой примитивной поисковой системы сети, запущенной 2 сентября 1993 года[5].

Вероятно, первым поисковым роботом, написанным на языке Perl, был «World Wide Web Wanderer» — бот Мэтью Грэя (Matthew Gray) из Массачусетского технологического института в июне 1993 года. Этот робот создавал поисковый индекс «Wandex». Цель робота Wanderer состояла в том, чтобы измерить размер всемирной паутины и найти все веб-страницы, содержащие слова из запроса. В 1993 году появилась и вторая поисковая система «Aliweb». Aliweb не использовала поискового робота, но вместо этого ожидала уведомлений от администраторов веб-сайтов о наличии на их сайтах индексного файла в определённом формате.

JumpStation[en], [6] созданный в декабре 1993 года Джонатаном Флетчером, искал веб-страницы и строил их индексы с помощью поискового робота, и использовал веб-форму в качестве интерфейса для формулирования поисковых запросов. Это был первый инструмент поиска в Интернете, который сочетал три важнейших функции поисковой системы (проверка, индексация и собственно поиск). Из-за ограниченности ресурсов компьютеров того времени индексация и, следовательно, поиск были ограничены только названиями и заголовками веб-страниц, найденных поисковым роботом.

Первой полнотекстовой индексирующей ресурсы при помощи робота («craweler-based») поисковой системой, стала система «WebCrawler»[en], запущенная в 1994 году. В отличие от своих предшественниц, она позволяла пользователям искать по любым словам, расположенным на любой веб-странице — с тех пор это стало стандартом для большинства поисковых систем. Кроме того, это был первый поисковик, получивший широкое распространение. В 1994 году была запущена система «Lycos», разработанная в Университете Карнеги-Меллон и ставшая серьёзным коммерческим предприятием.

Вскоре появилось множество других конкурирующих поисковых машин, таких как: «Magellan»[en], «Excite», «Infoseek»[en], «Inktomi»[en], «Northern Light»[en] и «AltaVista». В некотором смысле они конкурировали с популярными интернет-каталогами, такими как «Yahoo!». Но поисковые возможности каталогов ограничивались поиском по самим каталогам, а не по текстам веб-страниц. Позже каталоги объединялись или снабжались поисковыми роботами с целью улучшения поиска.

В 1996 году компания Netscape хотела заключить эксклюзивную сделку с одной из поисковых систем, сделав её поисковой системой по умолчанию на веб-браузере Netscape. Это вызвало настолько большой интерес, что Netscape заключила контракт сразу с пятью крупнейшими поисковыми системами (Yahoo!, Magellan, Lycos, Infoseek и Excite). За 5 млн долларов США в год они предлагались по очереди на поисковой странице Netscape[7][8].

Поисковые системы участвовали в «Пузыре доткомов» конца 1990-х[9]. Несколько компаний эффектно вышли на рынок, получив рекордную прибыль во время их первичного публичного предложения. Некоторые отказались от рынка общедоступных поисковых движков и стали работать только с корпоративным сектором, например, Northern Light[en].

Google взял на вооружение идею продажи ключевых слов в 1998 году, тогда это была маленькая компания, обеспечивавшая работу поисковой системы по адресу goto.com[en]. Этот шаг ознаменовал для поисковых систем переход от соревнований друг с другом к одному из самых выгодных коммерческих предприятий в Интернете[10]. Поисковые системы стали продавать первые места в результатах поиска отдельным компаниям.

Поисковая система Google занимает видное положение с начала 2000-х[11]. Компания добилась высокого положения благодаря хорошим результатам поиска с помощью алгоритма PageRank. Алгоритм был представлен общественности в статье «The Anatomy of Search Engine», написанной Сергеем Брином и Ларри Пейджем, основателями Google[12]. Этот итеративный алгоритм ранжирует веб-страницы, основываясь на оценке количества гиперссылок на веб-страницу в предположении, что на «хорошие» и «важные» страницы ссылаются больше, чем на другие. Интерфейс Google выдержан в спартанском стиле, где нет ничего лишнего, в отличие от многих своих конкурентов, которые встраивали поисковую систему в веб-портал. Поисковая система Google стала настолько популярной, что появились подражающие ей системы, например, Mystery Seeker[en](тайный поисковик).

К 2000 году Yahoo! осуществлял поиск на основе системы Inktomi. Yahoo! в 2002 году купил Inktomi, а в 2003 году купил Overture, которому принадлежали AlltheWeb[en] и AltaVista. Затем Yahoo! работал на основе поисковой системы Google вплоть до 2004 года, пока не запустил, наконец, свой собственный поисковик на основе всех купленных ранее технологий.

Фирма Microsoft впервые запустила поисковую систему Microsoft Network Search (MSN Search) осенью 1998 года, используя результаты поиска от Inktomi. Совсем скоро в начале 1999 года сайт начал отображать выдачу Looksmart[en], смешанную с результатами Inktomi. Недолго (в 1999 году) MSN search использовал результаты поиска от AltaVista. В 2004 году фирма Microsoft начала переход к собственной поисковой технологии с использованием собственного поискового робота — msnbot[en]. После проведения ребрендинга компанией Microsoft 1 июня 2009 года была запущена поисковая система Bing. 29 июля 2009 Yahoo! и Microsoft подписали соглашение, согласно которому Yahoo! Search[en] работал на основе технологии Microsoft Bing. На момент 2015 года союз Bing и Yahoo! дал первые настоящие плоды. Теперь Bing занимает 20,1 % рынка, а Yahoo! 12,7 %, что в общем занимает 32,60 % от общего рынка поисковых систем в США по данным из разных источников.

Поиск информации на русском языке

В 1996 году был реализован поиск с учётом русской морфологии на поисковой машине Altavista и запущены оригинальные российские поисковые машины Рамблер и Апорт. 23 сентября 1997 года была открыта поисковая машина Яндекс. 22 мая 2014 года компанией Ростелеком была открыта национальная поисковая машина Спутник, которая на момент 2015 года находится в стадии бета-тестировании. 22 апреля 2015 года был открыт новый сервис Спутник. Дети специально для детей с повышенной безопасностью.

Большую популярность получили методы кластерного анализа и поиска по метаданным. Из международных машин такого плана наибольшую известность получила «Clusty»[en] компании Vivisimo[en]. В 2005 году в России при поддержке МГУ запущен поисковик «Нигма», поддерживающий автоматическую кластеризацию. В 2006 году открылась российская метамашина Quintura, предлагающая визуальную кластеризацию в виде облака тегов. «Нигма» тоже экспериментировала[13] с визуальной кластеризацией.

Как работает поисковая система

Высокоуровневая архитектура стандартного краулераОсновные составляющие поисковой системы: поисковый робот, индексатор, поисковик[14].

Как правило, системы работают поэтапно. Сначала поисковый робот получает контент, затем индексатор генерирует доступный для поиска индекс, и наконец, поисковик обеспечивает функциональность для поиска индексируемых данных. Чтобы обновить поисковую систему, этот цикл индексации выполняется повторно[14].

Поисковые системы работают, храня информацию о многих веб-страницах, которые они получают из HTML-страниц. Поисковый робот или «краулер» (англ. Crawler) — программа, которая автоматически проходит по всем ссылкам, найденным на странице, и выделяет их. Краулер, основываясь на ссылках или исходя из заранее заданного списка адресов, осуществляет поиск новых документов, ещё не известных поисковой системе. Владелец сайта может исключить определённые страницы при помощи robots.txt, используя который можно запретить индексацию файлов, страниц или каталогов сайта.

Поисковая система анализирует содержание каждой страницы для дальнейшего индексирования. Слова могут быть извлечены из заголовков, текста страницы или специальных полей — метатегов. Индексатор — это модуль, который анализирует страницу, предварительно разбив её на части, применяя собственные лексические и морфологические алгоритмы. Все элементы веб-страницы вычленяются и анализируются отдельно. Данные о веб-страницах хранятся в индексной базе данных для использования в последующих запросах. Индекс позволяет быстро находить информацию по запросу пользователя[15].

Ряд поисковых систем, подобных Google, хранят исходную страницу целиком или её часть, так называемый кэш, а также различную информацию о веб-странице. Другие системы, подобные системе AltaVista, хранят каждое слово каждой найденной страницы. Использование кэша помогает ускорить извлечение информации с уже посещённых страниц[15]. Кэшированные страницы всегда содержат тот текст, который пользователь задал в поисковом запросе. Это может быть полезно в том случае, когда веб-страница обновилась, то есть уже не содержит текст запроса пользователя, а страница в кэше ещё старая[15]. Эта ситуация связана с потерей ссылок (англ. linkrot[en]) и дружественным по отношению к пользователю (юзабилити) подходом Google. Это предполагает выдачу из кэша коротких фрагментов текста, содержащих текст запроса. Действует принцип наименьшего удивления, пользователь обычно ожидает увидеть искомые слова в текстах полученных страниц (User expectations[en]). Кроме того, что использование кэшированных страниц ускоряет поиск, страницы в кэше могут содержать такую информацию, которая уже нигде более не доступна.

Поисковик работает с выходными файлами, полученными от индексатора. Поисковик принимает пользовательские запросы, обрабатывает их при помощи индекса и возвращает результаты поиска[14].

Когда пользователь вводит запрос в поисковую систему (обычно при помощи ключевых слов), система проверяет свой индекс и выдаёт список наиболее подходящих веб-страниц (отсортированный по какому-либо критерию), обычно с краткой аннотацией, содержащей заголовок документа и иногда части текста[15]. Поисковый индекс строится по специальной методике на основе информации, извлечённой из веб-страниц[11]. С 2007 года поисковик Google позволяет искать с учётом времени, создания искомых документов (вызов меню «Инструменты поиска» и указание временного диапазона).

Большинство поисковых систем поддерживает использование в запросах булевых операторов И, ИЛИ, НЕ, что позволяет уточнить или расширить список искомых ключевых слов. При этом система будет искать слова или фразы точно так, как было введено. В некоторых поисковых системах есть возможность приближённого поиска[en], в этом случае пользователи расширяют область поиска, указывая расстояние до ключевых слов[15]. Есть также концептуальный поиск[en], при котором используется статистический анализ употребления искомых слов и фраз в текстах веб-страниц. Эти системы позволяют составлять запросы на естественном языке. Примером такой поисковой системы является сайт ask com.

Полезность поисковой системы зависит от релевантности найденных ею страниц. Хоть миллионы веб-страниц и могут включать некое слово или фразу, но одни из них могут быть более релевантны, популярны или авторитетны, чем другие. Большинство поисковых систем использует методы ранжирования, чтобы вывести в начало списка «лучшие» результаты. Поисковые системы решают, какие страницы более релевантны, и в каком порядке должны быть показаны результаты, по-разному[15]. Методы поиска, как и сам Интернет со временем меняются. Так появились два основных типа поисковых систем: системы предопределённых и иерархически упорядоченных ключевых слов и системы, в которых генерируется инвертированный индекс на основе анализа текста.

Большинство поисковых систем являются коммерческими предприятиями, которые получают прибыль за счёт рекламы, в некоторых поисковиках можно купить за отдельную плату первые места в выдаче для заданных ключевых слов. Те поисковые системы, которые не берут денег за порядок выдачи результатов, зарабатывают на контекстной рекламе, при этом рекламные сообщения соответствуют запросу пользователя. Такая реклама выводится на странице со списком результатов поиска, и поисковики зарабатывают при каждом клике пользователя на рекламные сообщения.

Типы поисковых систем

Существует четыре типа поисковых систем: с поисковыми роботами, управляемые человеком, гибридные и мета-системы[16].

- системы, использующие поисковые роботы

- Состоят из трёх частей: краулер («бот», «робот» или «паук»), индекс и программное обеспечение поисковой системы. Краулер нужен для обхода сети и создания списков веб-страниц. Индекс — большой архив копий веб-страниц. Цель программного обеспечения — оценивать результаты поиска. Благодаря тому, что поисковый робот в этом механизме постоянно исследует сеть, информация в большей степени актуальна. Большинство современных поисковых систем являются системами данного типа.

- Эти поисковые системы получают списки веб-страниц. Каталог содержит адрес, заголовок и краткое описание сайта. Каталог ресурсов ищет результаты только из описаний страницы, представленных ему веб-мастерами. Достоинство каталогов в том, что все ресурсы проверяются вручную, следовательно, и качество контента будет лучше по сравнению с результатами, полученными системой первого типа автоматически. Но есть и недостаток — обновление данных каталогов выполняется вручную и может существенно отставать от реального положения дел. Ранжирование страниц не может мгновенно меняться. В качестве примеров таких систем можно привести каталог Yahoo[en], dmoz и Galaxy.

- гибридные системы

- Такие поисковые системы, как Yahoo, Google, MSN, сочетают в себе функции систем, использующие поисковых роботов, и систем, управляемых человеком.

- Метапоисковые системы объединяют и ранжируют результаты сразу нескольких поисковиков. Эти поисковые системы были полезны, когда у каждой поисковой системы был уникальный индекс, и поисковые системы были менее «умными». Поскольку сейчас поиск намного улучшился, потребность в них уменьшилась. Примеры: MetaCrawler[en] и MSN Search.

Рынок поисковых систем

Google — самая популярная поисковая система в мире с долей на рынке 68,69 %. Bing занимает вторую позицию, его доля 12,26 %[17].

Самые популярные поисковые системы в мире[18]:

| Поисковая система | Доля рынка в июле 2014 | Доля рынка в октябре 2014 | Доля рынка в сентябре 2017 |

|---|---|---|---|

| 68,69 % | 58,01 % | 69,24 % | |

| Bing | 17,17 % | 29,06 % | 12,26 % |

| Baidu | 6,22 % | 8,01 % | 6,48 % |

| Yahoo! | 6,74 % | 4,01 % | 5,19 % |

| AOL | 0,13 % | 0,21 % | 1,11 % |

| Excite | 0,22 % | 0,00 % | 0,00 % |

| Ask | 0,13 % | 0,10 % | 0,24 % |

Азия

В восточноазиатских странах и в России Google — не самая популярная поисковая система. В Китае, например, более популярна поисковая система Soso[en].

В Южной Корее поисковым порталом собственной разработки Naver пользуется около 70 % жителей[19]Yahoo! Japan и Yahoo! Taiwan — самые популярные системы для поиска в Японии и Тайване соответственно[20].

Россия и русскоязычные поисковые системы

Яндексом пользуются 53,3 % пользователей в России (Google — 42,9 %)[21].

Согласно данным LiveInternet в декабре 2017 года об охвате русскоязычных поисковых запросов[22]:

- Всеязычные:

- Англоязычные и международные:

- Русскоязычные — большинство «русскоязычных» поисковых систем индексируют и ищут тексты на многих языках — украинском, белорусском, английском, татарском и других. Отличаются же они от «всеязычных» систем, индексирующих все документы подряд, тем, что, в основном, индексируют ресурсы, расположенные в доменных зонах, где доминирует русский язык, или другими способами ограничивают своих роботов русскоязычными сайтами.

Некоторые из поисковых систем используют внешние алгоритмы поиска.

Количественные данные поисковой системы Google

Число пользователей Интернета и поисковых систем и требований пользователей к этим системам постоянно растёт. Для увеличений скорости поиска нужной информации крупные поисковые системы содержат большое количество серверов. Сервера обычно группируют в серверные центры (дата-центры). У популярных поисковых систем серверные центры разбросаны по всему миру[23].

В октябре 2012 года Google запустила проект «Где живёт Интернет», где пользователям предоставляется возможность познакомиться с центрами обработки данных этой компании[24].

О работе дата-центров поисковой системе Google известно следующее[23]:

- Суммарная мощность всех дата-центров Google, по состоянию на 2011 год, оценивалась в 220 МВт.

- Когда в 2008 году Google планировала открыть в Орегоне новый комплекс, состоящий из трёх зданий общей площадью 6,5 млн м², в журнале Harper’s Magazine подсчитали, что такой большой комплекс потребляет свыше 100 МВт электроэнергии, что сравнимо с потреблением энергии города с населением 300 000 человек.

- Ориентировочное число серверов Google в 2012 году — 1 000 000.

- Расходы Google на дата-центры составили в 2006 году — $1,9 млрд, а в 2007 году — $2,4 млрд.

Размер всемирной паутины, проиндексированной Google на декабрь 2014 года, составляет примерно 4,36 миллиарда страниц[25].

Поисковые системы, учитывающие религиозные запреты

Глобальное распространение Интернета и увеличение популярности электронных устройств в арабском и мусульманском мире, в частности, в странах Ближнего Востока и Индийского субконтинента, способствовало развитию локальных поисковых систем, учитывающих исламские традиции. Такие поисковые системы содержат специальные фильтры, которые помогают пользователям не попадать на запрещённые сайты, например, сайты с порнографией, и позволяют им пользоваться только теми сайтами, содержимое которых не противоречит исламской вере.

Незадолго до мусульманского месяца Рамадан, в июле 2013 года, миру был представлен Halalgoogling[en] — система, выдающая пользователям только халяльные «правильные» ссылки[26], фильтруя результаты поиска, полученные от других поисковых систем, таких как Google и Bing. Двумя годами ранее, в сентябре 2011 года, был запущен поисковый движок I’mHalal, предназначенный для обслуживания пользователей Ближнего Востока. Однако этот поисковый сервис пришлось вскоре закрыть, по сообщению владельца, из-за отсутствия финансирования[27].

Отсутствие инвестиций и медленный темп распространения технологий в мусульманском мире препятствовали прогрессу и мешали успеху серьёзного исламского поисковика. Очевиден провал огромных инвестиций в веб-проекты мусульманского образа жизни, одним из которых был Muxlim[en]. Он получил миллионы долларов от инвесторов, таких как Rite Internet Ventures, и теперь — в соответствии с последним сообщением от I’mHalal перед его закрытием — выступает с сомнительной идеей о том, что «следующий Facebook или Google могут появиться только в странах Ближнего Востока, если вы поддержите нашу блестящую молодёжь»[28].

Тем не менее исламские эксперты в области Интернета в течение многих лет занимаются определением того, что соответствует или не соответствует шариату, и классифицируют веб-сайты как «халяль» или «харам». Все бывшие и настоящие исламские поисковые системы представляют собой просто специальным образом проиндексированный набор данных либо это главные поисковые системы, такие как Google, Yahoo и Bing, с определённой системой фильтрации, использующейся для того, чтобы пользователи не могли получить доступ к харам-сайтам, таким как сайты о наготе, ЛГБТ, азартных играх и каким-либо другим, тематика которых считается антиисламской[28].

Среди других религиозно-ориентированных поисковых систем распространёнными являются Jewogle — еврейская версия Google и SeekFind.org — христианский сайт, включающий в себя фильтры, оберегающие пользователей от контента, который может подорвать или ослабить их веру[29].

Персональные результаты и пузыри фильтров

Многие поисковые системы, такие как Google и Bing, используют алгоритмы выборочного угадывания того, какую информацию пользователь хотел бы увидеть, основываясь на его прошлых действиях в системе. В результате, веб-сайты показывают только ту информацию, которая согласуется с прошлыми интересами пользователя. Этот эффект получил название «пузырь фильтров»[30].

Всё это ведёт к тому, что пользователи получают намного меньше противоречащей своей точке зрения информации и становятся интеллектуально изолированными в своём собственном «информационном пузыре». Таким образом, «эффект пузыря» может иметь негативные последствия для формирования гражданского мнения[31].

Предвзятость поисковых систем

Несмотря на то, что поисковые системы запрограммированы, чтобы оценивать веб-сайты на основе некоторой комбинации их популярности и релевантности, в реальности экспериментальные исследования указывают на то, что различные политические, экономические и социальные факторы оказывают влияние на поисковую выдачу[32][33].

Такая предвзятость может быть прямым результатом экономических и коммерческих процессов: компании, которые рекламируются в поисковой системе, могут стать более популярными в результатах обычного поиска в ней. Удаление результатов поиска, не соответствующих местным законам, является примером влияния политических процессов. Например, Google не будет отображать некоторые неонацистские веб-сайты во Франции и Германии, где отрицание Холокоста незаконно[34].

Предвзятость может также быть следствием социальных процессов, поскольку алгоритмы поисковых систем часто разрабатываются, чтобы исключить неформатные точки зрения в пользу более «популярных» результатов[35]. Алгоритмы индексации главных поисковых систем отдают приоритет американским сайтам[33].

Поисковая бомба — один из примеров попытки управления результатами поиска по политическим, социальным или коммерческим причинам.

См. также

Примечания

- ↑ Chu & Rosenthal, 1996, p. 129.

- ↑ Tarakeswar & Kavitha, 2011, p. 29.

- ↑ World-Wide Web Servers.

- ↑ What’s New.

- ↑ Oscar Nierstrasz.

- ↑ Archive of NCSA.

- ↑ Yahoo! And Netscape.

- ↑ Netscape, 1996.

- ↑ The dynamics of competition, 2001.

- ↑ Intro to Computer Science.

- ↑ 1 2 Google`s history.

- ↑ Брин и Пейдж, p. 3.

- ↑ Nigma.

- ↑ 1 2 3 Risvik & Michelsen, 2002, p. 290.

- ↑ 1 2 3 4 5 6 Knowledge Management, 2011.

- ↑ Tarakeswar & Kavitha, 2011, p. 29.

- ↑ NMS.

- ↑ Статистика.

- ↑ Naver.

- ↑ Age of Internet Empires.

- ↑ LiveInternet.

- ↑ Liveinternet

- ↑ 1 2 Antula.

- ↑ Where the Internet lives.

- ↑ World wide web size.

- ↑ Islam.

- ↑ I’mHalal

- ↑ 1 2 Halalblog

- ↑ ChristianNews.

- ↑ Pariser, 2011.

- ↑ Auralist, 2012, p. 13.

- ↑ Segev, 2010.

- ↑ 1 2 Search engine coverage bias, 2004.

- ↑ Replacement of Google.

- ↑ Shaping the Web, 2000.

Литература

- Gandal, Neil. The dynamics of competition in the internet search engine market. — 2001. — Vol. 19. — P. 1103–1117. — DOI:10.1016/S0167-7187(01)00065-0.

- Tarakeswar M. K., Kavitha M. D. Search Engines:A Study (англ.) // Journal of Computer Applications (JCA) : journal. — 2011. — Vol. 4, no. 1. — P. 29—33. — ISSN 0974-1925.

- Vaughan L., Thelwall M. Search engine coverage bias: evidence and possible causes (англ.) // Information Processing & Management : journal. — 2004. — Vol. 40. — P. 693–707. — DOI:10.1016/S0306-4573(03)00063-3.

Ссылки

- FAQ. NetMarketShare. Проверено 23 ноября 2014.

Поисковые системы мира: ТОП-10

Поисковые системы мира: ТОП-10

1. Google

Ожидаемо Гугл занял первое место в мировом рейтинге. На его долю приходится более 70% поисковых запросов от жителей со всех уголков Земли. Причем треть всего трафика google.com приходится на граждан США. Кроме того, Гугл является самым посещаемым сайтом в мире. Средняя ежедневная продолжительность использования поисковой системы Гугл составляет 9 минут.

Преимуществом поисковика Гугл является отсутствие лишних элементов на странице. Лишь строка поиска и логотип компании. Фишкой являются анимированные картинки и браузерные игры, приуроченные к популярным и локальным праздникам.

2. Bing

Бинг — поисковая система от Microsoft, ведущая свою историю с 2009 года. С этого момента она стала обязательным атрибутом смартфонов на ОС Windows. Bing также отличает минимализм — помимо шапки с перечнем всех продуктов Microsoft, на странице расположена лишь поисковая строка и название системы. Наиболее популярен Бинг в США (31%), Китае (18%) и Германии (6%).

3. Yahoo!

Третье место закрепилось за одним из старейших поисковиков — Яху. Основная масса пользователей также проживает в США (24%). Складывается впечатление, что весь остальной мир сознательно избегает помощи поисковых роботов… Также поисковик популярен в Индии, Индонезии, Тайване и в Великобритании. Помимо строки поиска, на странице Yahoo! предлагается прогноз погоды в вашем регионе, а также мировые тренды в виде ленты новостей.

4. Baidu

Китайский поисковик, который в России снискал дурную славу. Из-за агрессивной политики и отсутствия перевода на русский или английский языки, расширения этой поисковый системы воспринимаются в качестве вирусов. Их очень сложно удалить до конца и избавиться от всплывающих окон с иероглифами. Тем не менее, этот сайт является четвертым в мире по посещаемости. 92% его аудитории составляют граждане Китая.

5. AOL

AOL — американская поисковая система, чье название расшифровывается как America Online. Ее популярность значительно ниже, чем у предыдущих систем. Ее рассвет приходился на 90-е и 00-е годы. Почти 70% аудитории АОЛ — жители Соединенных Штатов.

6. Ask.com

У этой поисковой системы, ведущей свою историю с 1995, довольно необычный интерфейс. Все запросы она воспринимает в качестве вопросов и предлагает варианты ответов в соответствии с поисковой выдачей. Это чем-то напоминает сервис Ответы.Мэйл. Однако в выдачу попадают не ответы любителей, а полноценные статьи. За последний год сайт потерял около 50 позиций в мировом рейтинге самых популярных интернет-ресурсов и на сегодняшний день занимает лишь 104 место.

7. Excite

Этот поисковик ничем не примечателен, и похож на массу других сайтов. Он предлагает пользователям массу сервисов (таких, как Новости, Почта, Погода, Путешествия и т.д.) Интерфейс сайта также вызывает воспоминания о вэбе 90-х гг и, можно предположить, мало изменился с тех пор.

8. DuckDuckGo

Разработчики сразу предупреждают, что данная поисковая система не отслеживает ваши действия в сети. В наши дни это является весомым аргументом при выборе поисковика. Дизайн сайта выполнен в современной манере, использует яркие краски и забавные картинки. В отличие от других поисковых машин, «утиный поисковик» переведен на русский язык. За последний год сайт отыграл около 400 позиций и в марте 2017г. находится на 504 строчке рейтинга популярности Alexa.

9. WolframAlpha

Отличительной чертой этого поиска является многообразие вспомогательных сервисов, рассчитанных на запросы, связанные с теми или иными знаниями. То есть, в выдаче вы не увидите ссылок на посты в соцсетях или статьи желтой прессы. Вам предложат конкретные цифры и проверенные факты в форме единого документа. Этот браузер идеально подходит школьникам и студентам.

10. Yandex

Поисковик, наиболее популярный в России и странах СНГ. Кроме того, около 3% аудитории сайта являются жителями Германии. Сайт примечателен большим количеством сервисов на все случаи жизни (музыка, радио, расписание общественного транспорта, недвижимость, переводчик и пр.) Также ресурс предлагает большой выбор индивидуального оформления сайта, а также настройку виджетов «под себя». Яндекс занимает 31 место в мире по популярности, потеряв 11 позиций за последний год.

Читайте далее: Где скачать книги бесплатно: ТОП электронных библиотек.

Поисковая система — Википедия

Поиск информации во Всемирной паутине был трудной и не самой приятной задачей, но с прорывом в технологии поисковых систем в конце 1990-х годов осуществлять поиск стало намного удобнейПоиско́вая систе́ма (англ. search engine) — это компьютерная система, предназначенная для поиска информации. Одно из наиболее известных применений поисковых систем — веб-сервисы для поиска текстовой или графической информации во Всемирной паутине. Существуют также системы, способные искать файлы на FTP-серверах, товары в интернет-магазинах, информацию в группах новостей Usenet.

Для поиска информации с помощью поисковой системы пользователь формулирует поисковый запрос[1]. Работа поисковой системы заключается в том, чтобы по запросу пользователя найти документы, содержащие либо указанные ключевые слова, либо слова, как-либо связанные с ключевыми словами[2]. При этом поисковая система генерирует страницу результатов поиска. Такая поисковая выдача может содержать различные типы результатов, например: веб-страницы, изображения, аудиофайлы. Некоторые поисковые системы также извлекают информацию из подходящих баз данных и каталогов ресурсов в Интернете.

Поисковая система тем лучше, чем больше документов, релевантных запросу пользователя, она будет возвращать. Результаты поиска могут становиться менее релевантными из-за особенностей алгоритмов (см. «Пузырь фильтров»[⇨]) или вследствие человеческого фактора[⇨]. По состоянию на 2015 год самой популярной поисковой системой в мире является Google, однако есть страны, где пользователи отдали предпочтение другим поисковикам. Так, например, в России «Яндекс» обгоняет Google больше, чем на 10 %[⇨].

По методам поиска и обслуживания разделяют четыре типа поисковых систем: системы, использующие поисковых роботов, системы, управляемые человеком, гибридные системы и мета-системы[⇨]. В архитектуру поисковой системы обычно входят:

- поисковый робот, собирающий информацию с сайтов сети Интернет или из других документов,

- индексатор, обеспечивающий быстрый поиск по накопленной информации, и

- поисковик — графический интерфейс для работы пользователя[⇨].

История

На раннем этапе развития сети Интернет Тим Бернерс-Ли поддерживал список веб-серверов, размещённый на сайте ЦЕРН[3]. Сайтов становилось всё больше, и поддерживать вручную такой список становилось всё сложнее. На сайте NCSA был специальный раздел «Что нового!» (англ. What’s New!)[4], где публиковали ссылки на новые сайты.

Первой компьютерной программой для поиска в Интернете была программа Арчи[en] (англ. archie — архив без буквы «в»). Она была создана в 1990 году Аланом Эмтэджем (Alan Emtage), Биллом Хиланом (Bill Heelan) и Дж. Питером Дойчем (J. Peter Deutsch), студентами, изучающими информатику в университете Макгилла в Монреале. Программа скачивала списки всех файлов со всех доступных анонимных FTP-серверов и строила базу данных, в которой можно было выполнять поиск по именам файлов. Однако, программа Арчи не индексировала содержимое этих файлов, так как объём данных был настолько мал, что всё можно было легко найти вручную.

Развитие и распространение сетевого протокола Gopher, придуманного в 1991 году Марком Маккэхилом (Mark McCahill) в университете Миннесоты, привело к созданию двух новых поисковых программ, Veronica[en] и Jughead[en]. Как и Арчи, они искали имена файлов и заголовки, сохранённые в индексных системах Gopher. Veronica (англ. Very Easy Rodent-Oriented Net-wide Index to Computerized Archives) позволяла выполнять поиск по ключевым словам большинства заголовков меню Gopher во всех списках Gopher. Программа Jughead (англ. Jonzy’s Universal Gopher Hierarchy Excavation And Display) извлекала информацию о меню от определённых Gopher-серверов. Хотя название поисковика Арчи не имело отношения к циклу комиксов «Арчи»[en], тем не менее Veronica и Jughead — персонажи этих комиксов.

К лету 1993 года ещё не было ни одной системы для поиска в вебе, хотя вручную поддерживались многочисленные специализированные каталоги. Оскар Нирштрасс (Oscar Nierstrasz) в Женевском университете написал ряд сценариев на Perl, которые периодически копировали эти страницы и переписывали их в стандартный формат. Это стало основой для W3Catalog, первой примитивной поисковой системы сети, запущенной 2 сентября 1993 года[5].

Вероятно, первым поисковым роботом, написанным на языке Perl, был «World Wide Web Wanderer» — бот Мэтью Грэя (Matthew Gray) из Массачусетского технологического института в июне 1993 года. Этот робот создавал поисковый индекс «Wandex». Цель робота Wanderer состояла в том, чтобы измерить размер всемирной паутины и найти все веб-страницы, содержащие слова из запроса. В 1993 году появилась и вторая поисковая система «Aliweb». Aliweb не использовала поискового робота, но вместо этого ожидала уведомлений от администраторов веб-сайтов о наличии на их сайтах индексного файла в определённом формате.

JumpStation[en], [6] созданный в декабре 1993 года Джонатаном Флетчером, искал веб-страницы и строил их индексы с помощью поискового робота, и использовал веб-форму в качестве интерфейса для формулирования поисковых запросов. Это был первый инструмент поиска в Интернете, который сочетал три важнейших функции поисковой системы (проверка, индексация и собственно поиск). Из-за ограниченности ресурсов компьютеров того времени индексация и, следовательно, поиск были ограничены только названиями и заголовками веб-страниц, найденных поисковым роботом.

Первой полнотекстовой индексирующей ресурсы при помощи робота («craweler-based») поисковой системой, стала система «WebCrawler»[en], запущенная в 1994 году. В отличие от своих предшественниц, она позволяла пользователям искать по любым словам, расположенным на любой веб-странице — с тех пор это стало стандартом для большинства поисковых систем. Кроме того, это был первый поисковик, получивший широкое распространение. В 1994 году была запущена система «Lycos», разработанная в Университете Карнеги-Меллон и ставшая серьёзным коммерческим предприятием.

Вскоре появилось множество других конкурирующих поисковых машин, таких как: «Magellan»[en], «Excite», «Infoseek»[en], «Inktomi»[en], «Northern Light»[en] и «AltaVista». В некотором смысле они конкурировали с популярными интернет-каталогами, такими как «Yahoo!». Но поисковые возможности каталогов ограничивались поиском по самим каталогам, а не по текстам веб-страниц. Позже каталоги объединялись или снабжались поисковыми роботами с целью улучшения поиска.

В 1996 году компания Netscape хотела заключить эксклюзивную сделку с одной из поисковых систем, сделав её поисковой системой по умолчанию на веб-браузере Netscape. Это вызвало настолько большой интерес, что Netscape заключила контракт сразу с пятью крупнейшими поисковыми системами (Yahoo!, Magellan, Lycos, Infoseek и Excite). За 5 млн долларов США в год они предлагались по очереди на поисковой странице Netscape[7][8].

Поисковые системы участвовали в «Пузыре доткомов» конца 1990-х[9]. Несколько компаний эффектно вышли на рынок, получив рекордную прибыль во время их первичного публичного предложения. Некоторые отказались от рынка общедоступных поисковых движков и стали работать только с корпоративным сектором, например, Northern Light[en].

Google взял на вооружение идею продажи ключевых слов в 1998 году, тогда это была маленькая компания, обеспечивавшая работу поисковой системы по адресу goto.com[en]. Этот шаг ознаменовал для поисковых систем переход от соревнований друг с другом к одному из самых выгодных коммерческих предприятий в Интернете[10]. Поисковые системы стали продавать первые места в результатах поиска отдельным компаниям.

Поисковая система Google занимает видное положение с начала 2000-х[11]. Компания добилась высокого положения благодаря хорошим результатам поиска с помощью алгоритма PageRank. Алгоритм был представлен общественности в статье «The Anatomy of Search Engine», написанной Сергеем Брином и Ларри Пейджем, основателями Google[12]. Этот итеративный алгоритм ранжирует веб-страницы, основываясь на оценке количества гиперссылок на веб-страницу в предположении, что на «хорошие» и «важные» страницы ссылаются больше, чем на другие. Интерфейс Google выдержан в спартанском стиле, где нет ничего лишнего, в отличие от многих своих конкурентов, которые встраивали поисковую систему в веб-портал. Поисковая система Google стала настолько популярной, что появились подражающие ей системы, например, Mystery Seeker[en](тайный поисковик).

К 2000 году Yahoo! осуществлял поиск на основе системы Inktomi. Yahoo! в 2002 году купил Inktomi, а в 2003 году купил Overture, которому принадлежали AlltheWeb[en] и AltaVista. Затем Yahoo! работал на основе поисковой системы Google вплоть до 2004 года, пока не запустил, наконец, свой собственный поисковик на основе всех купленных ранее технологий.

Фирма Microsoft впервые запустила поисковую систему Microsoft Network Search (MSN Search) осенью 1998 года, используя результаты поиска от Inktomi. Совсем скоро в начале 1999 года сайт начал отображать выдачу Looksmart[en], смешанную с результатами Inktomi. Недолго (в 1999 году) MSN search использовал результаты поиска от AltaVista. В 2004 году фирма Microsoft начала переход к собственной поисковой технологии с использованием собственного поискового робота — msnbot[en]. После проведения ребрендинга компанией Microsoft 1 июня 2009 года была запущена поисковая система Bing. 29 июля 2009 Yahoo! и Microsoft подписали соглашение, согласно которому Yahoo! Search[en] работал на основе технологии Microsoft Bing. На момент 2015 года союз Bing и Yahoo! дал первые настоящие плоды. Теперь Bing занимает 20,1 % рынка, а Yahoo! 12,7 %, что в общем занимает 32,60 % от общего рынка поисковых систем в США по данным из разных источников.

Поиск информации на русском языке

В 1996 году был реализован поиск с учётом русской морфологии на поисковой машине Altavista и запущены оригинальные российские поисковые машины Рамблер и Апорт. 23 сентября 1997 года была открыта поисковая машина Яндекс. 22 мая 2014 года компанией Ростелеком была открыта национальная поисковая машина Спутник, которая на момент 2015 года находится в стадии бета-тестировании. 22 апреля 2015 года был открыт новый сервис Спутник. Дети специально для детей с повышенной безопасностью.

Большую популярность получили методы кластерного анализа и поиска по метаданным. Из международных машин такого плана наибольшую известность получила «Clusty»[en] компании Vivisimo[en]. В 2005 году в России при поддержке МГУ запущен поисковик «Нигма», поддерживающий автоматическую кластеризацию. В 2006 году открылась российская метамашина Quintura, предлагающая визуальную кластеризацию в виде облака тегов. «Нигма» тоже экспериментировала[13] с визуальной кластеризацией.

Видео по теме

Как работает поисковая система

Высокоуровневая архитектура стандартного краулера

Высокоуровневая архитектура стандартного краулераОсновные составляющие поисковой системы: поисковый робот, индексатор, поисковик[14].

Как правило, системы работают поэтапно. Сначала поисковый робот получает контент, затем индексатор генерирует доступный для поиска индекс, и наконец, поисковик обеспечивает функциональность для поиска индексируемых данных. Чтобы обновить поисковую систему, этот цикл индексации выполняется повторно[14].

Поисковые системы работают, храня информацию о многих веб-страницах, которые они получают из HTML-страниц. Поисковый робот или «краулер» (англ. Crawler) — программа, которая автоматически проходит по всем ссылкам, найденным на странице, и выделяет их. Краулер, основываясь на ссылках или исходя из заранее заданного списка адресов, осуществляет поиск новых документов, ещё не известных поисковой системе. Владелец сайта может исключить определённые страницы при помощи robots.txt, используя который можно запретить индексацию файлов, страниц или каталогов сайта.

Поисковая система анализирует содержание каждой страницы для дальнейшего индексирования. Слова могут быть извлечены из заголовков, текста страницы или специальных полей — метатегов. Индексатор — это модуль, который анализирует страницу, предварительно разбив её на части, применяя собственные лексические и морфологические алгоритмы. Все элементы веб-страницы вычленяются и анализируются отдельно. Данные о веб-страницах хранятся в индексной базе данных для использования в последующих запросах. Индекс позволяет быстро находить информацию по запросу пользователя[15].

Ряд поисковых систем, подобных Google, хранят исходную страницу целиком или её часть, так называемый кэш, а также различную информацию о веб-странице. Другие системы, подобные системе AltaVista, хранят каждое слово каждой найденной страницы. Использование кэша помогает ускорить извлечение информации с уже посещённых страниц[15]. Кэшированные страницы всегда содержат тот текст, который пользователь задал в поисковом запросе. Это может быть полезно в том случае, когда веб-страница обновилась, то есть уже не содержит текст запроса пользователя, а страница в кэше ещё старая[15]. Эта ситуация связана с потерей ссылок (англ. linkrot[en]) и дружественным по отношению к пользователю (юзабилити) подходом Google. Это предполагает выдачу из кэша коротких фрагментов текста, содержащих текст запроса. Действует принцип наименьшего удивления, пользователь обычно ожидает увидеть искомые слова в текстах полученных страниц (User expectations[en]). Кроме того, что использование кэшированных страниц ускоряет поиск, страницы в кэше могут содержать такую информацию, которая уже нигде более не доступна.

Поисковик работает с выходными файлами, полученными от индексатора. Поисковик принимает пользовательские запросы, обрабатывает их при помощи индекса и возвращает результаты поиска[14].

Когда пользователь вводит запрос в поисковую систему (обычно при помощи ключевых слов), система проверяет свой индекс и выдаёт список наиболее подходящих веб-страниц (отсортированный по какому-либо критерию), обычно с краткой аннотацией, содержащей заголовок документа и иногда части текста[15]. Поисковый индекс строится по специальной методике на основе информации, извлечённой из веб-страниц[11]. С 2007 года поисковик Google позволяет искать с учётом времени, создания искомых документов (вызов меню «Инструменты поиска» и указание временного диапазона).

Большинство поисковых систем поддерживает использование в запросах булевых операторов И, ИЛИ, НЕ, что позволяет уточнить или расширить список искомых ключевых слов. При этом система будет искать слова или фразы точно так, как было введено. В некоторых поисковых системах есть возможность приближённого поиска[en], в этом случае пользователи расширяют область поиска, указывая расстояние до ключевых слов[15]. Есть также концептуальный поиск[en], при котором используется статистический анализ употребления искомых слов и фраз в текстах веб-страниц. Эти системы позволяют составлять запросы на естественном языке. Примером такой поисковой системы является сайт ask com.

Полезность поисковой системы зависит от релевантности найденных ею страниц. Хоть миллионы веб-страниц и могут включать некое слово или фразу, но одни из них могут быть более релевантны, популярны или авторитетны, чем другие. Большинство поисковых систем использует методы ранжирования, чтобы вывести в начало списка «лучшие» результаты. Поисковые системы решают, какие страницы более релевантны, и в каком порядке должны быть показаны результаты, по-разному[15]. Методы поиска, как и сам Интернет со временем меняются. Так появились два основных типа поисковых систем: системы предопределённых и иерархически упорядоченных ключевых слов и системы, в которых генерируется инвертированный индекс на основе анализа текста.

Большинство поисковых систем являются коммерческими предприятиями, которые получают прибыль за счёт рекламы, в некоторых поисковиках можно купить за отдельную плату первые места в выдаче для заданных ключевых слов. Те поисковые системы, которые не берут денег за порядок выдачи результатов, зарабатывают на контекстной рекламе, при этом рекламные сообщения соответствуют запросу пользователя. Такая реклама выводится на странице со списком результатов поиска, и поисковики зарабатывают при каждом клике пользователя на рекламные сообщения.

Типы поисковых систем

Существует четыре типа поисковых систем: с поисковыми роботами, управляемые человеком, гибридные и мета-системы[16].

- системы, использующие поисковые роботы

- Состоят из трёх частей: краулер («бот», «робот» или «паук»), индекс и программное обеспечение поисковой системы. Краулер нужен для обхода сети и создания списков веб-страниц. Индекс — большой архив копий веб-страниц. Цель программного обеспечения — оценивать результаты поиска. Благодаря тому, что поисковый робот в этом механизме постоянно исследует сеть, информация в большей степени актуальна. Большинство современных поисковых систем являются системами данного типа.

- Эти поисковые системы получают списки веб-страниц. Каталог содержит адрес, заголовок и краткое описание сайта. Каталог ресурсов ищет результаты только из описаний страницы, представленных ему веб-мастерами. Достоинство каталогов в том, что все ресурсы проверяются вручную, следовательно, и качество контента будет лучше по сравнению с результатами, полученными системой первого типа автоматически. Но есть и недостаток — обновление данных каталогов выполняется вручную и может существенно отставать от реального положения дел. Ранжирование страниц не может мгновенно меняться. В качестве примеров таких систем можно привести каталог Yahoo[en], dmoz и Galaxy.

- гибридные системы

- Такие поисковые системы, как Yahoo, Google, MSN, сочетают в себе функции систем, использующие поисковых роботов, и систем, управляемых человеком.

- Метапоисковые системы объединяют и ранжируют результаты сразу нескольких поисковиков. Эти поисковые системы были полезны, когда у каждой поисковой системы был уникальный индекс, и поисковые системы были менее «умными». Поскольку сейчас поиск намного улучшился, потребность в них уменьшилась. Примеры: MetaCrawler[en] и MSN Search.

Рынок поисковых систем

Google — самая популярная поисковая система в мире с долей на рынке 68,69 %. Bing занимает вторую позицию, его доля 12,26 %[17].

Самые популярные поисковые системы в мире[18]:

| Поисковая система | Доля рынка в июле 2014 | Доля рынка в октябре 2014 | Доля рынка в сентябре 2017 |

|---|---|---|---|

| 68,69 % | 58,01 % | 69,24 % | |

| Bing | 17,17 % | 29,06 % | 12,26 % |

| Baidu | 6,22 % | 8,01 % | 6,48 % |

| Yahoo! | 6,74 % | 4,01 % | 5,19 % |

| AOL | 0,13 % | 0,21 % | 1,11 % |

| Excite | 0,22 % | 0,00 % | 0,00 % |

| Ask | 0,13 % | 0,10 % | 0,24 % |

Азия

В восточноазиатских странах и в России Google — не самая популярная поисковая система. В Китае, например, более популярна поисковая система Soso[en].

В Южной Корее поисковым порталом собственной разработки Naver пользуется около 70 % жителей[19]Yahoo! Japan и Yahoo! Taiwan — самые популярные системы для поиска в Японии и Тайване соответственно[20].

Россия и русскоязычные поисковые системы

Яндексом пользуются 53,3 % пользователей в России (Google — 42,9 %)[21].

Согласно данным LiveInternet в декабре 2017 года об охвате русскоязычных поисковых запросов[22]:

- Всеязычные:

- Англоязычные и международные: