Правильный Robots.txt для WordPress (2020) — как сделать?

В интернете можно найти много публикаций на тему, как составить лучший (или даже самый лучший) файл robots.txt для WordPress. При этом в ряде таких популярных статей многие правила не объясняются и, как мне кажется, вряд ли понимаются самими авторами. Единственный обзор, который я нашел и который действительно заслуживает внимания, — это статья в блоге wp-kama. Однако и там я нашел не совсем корректные рекомендации. Понятно, что на каждом сайте будут свои нюансы при составлении файла robots.txt. Но существует ряд общих моментов для совершенно разных сайтов, которые можно взять за основу. Robots.txt, опубликованный в этой статье, можно будет просто копировать и вставлять на новый сайт и далее дорабатывать в соответствии со своими нюансами.

Более подробно о составлении robots.txt и значении всех его директив я писал здесь. Ниже я не буду подробно останавливаться на значении каждого правила. Ограничусь тем, что кратко прокомментирую что для чего необходимо.

Правильный Robots.txt для WordPress

Действительно самый лучший robots.txt, который я видел на данный момент, это роботс, предложенный в блоге wp-kama. Ряд директив и комментариев я возьму из его образца + внесу свои корректировки. Корректировки коснутся нескольких правил, почему так напишу ниже. Кроме того, напишем индивидуальные правила для всех роботов, для Яндекса и для Google.

Действительно самый лучший robots.txt, который я видел на данный момент, это роботс, предложенный в блоге wp-kama. Ряд директив и комментариев я возьму из его образца + внесу свои корректировки. Корректировки коснутся нескольких правил, почему так напишу ниже. Кроме того, напишем индивидуальные правила для всех роботов, для Яндекса и для Google.

Ниже привожу короткий и расширенный вариант. Короткий не включает отдельные блоки для Google и Яндекса. Расширенный уже менее актуален, т.к. теперь нет принципиальных особенностей между двумя крупными поисковиками: обеим системам нужно индексировать файлы скриптов и изображений, обе не поддерживают директиву Host. Тем не менее, если в этом мире снова что-то изменится, либо вам потребуется все-таки как-то по-отдельному управлять индексацией файлов на сайте Яндексом и Гугл, сохраню в этой статье и второй вариант.

Еще раз обращаю внимание, что это базовый файл robots.txt. В каждом конкретном случае нужно смотреть реальный сайт и по-необходимости вносить корректировки. Поручайте это дело опытным специалистам!

Короткий вариант (оптимальный)

User-agent: * # общие правила для роботов, кроме Яндекса и Google,

# т.к. для них правила ниже

Disallow: /cgi-bin # папка на хостинге

Disallow: /? # все параметры запроса на главной

Disallow: /wp- # все файлы WP: /wp-json/, /wp-includes, /wp-content/plugins

Disallow: /wp/ # если есть подкаталог /wp/, где установлена CMS (если нет,

# правило можно удалить)

Disallow: *?s= # поиск

Disallow: *&s= # поиск

Disallow: /search/ # поиск

Disallow: /author/ # архив автора

Disallow: /users/ # архив авторов

Disallow: */trackback # трекбеки, уведомления в комментариях о появлении открытой

# ссылки на статью

Disallow: */feed # все фиды

Disallow: */rss # rss фид

Disallow: */embed # все встраивания

Disallow: */wlwmanifest.xml # xml-файл манифеста Windows Live Writer (если не используете,

# правило можно удалить)

Disallow: /xmlrpc.php # файл WordPress API

Disallow: *utm*= # ссылки с utm-метками

Disallow: *openstat= # ссылки с метками openstat

Allow: */uploads # открываем папку с файлами uploads

# Укажите один или несколько файлов Sitemap (дублировать для каждого User-agent

# не нужно). Google XML Sitemap создает 2 карты сайта, как в примере ниже.

Sitemap: http://site.ru/sitemap.xml

Sitemap: http://site.ru/sitemap.xml.gz

# Укажите главное зеркало сайта, как в примере ниже (с WWW / без WWW, если HTTPS

# то пишем протокол, если нужно указать порт, указываем). Команда стала необязательной. Ранее Host понимал

# Яндекс и Mail.RU. Теперь все основные поисковые системы команду Host не учитывают.

Host: www.site.ruРасширенный вариант (отдельные правила для Google и Яндекса)

User-agent: * # общие правила для роботов, кроме Яндекса и Google,

# т.к. для них правила ниже

Disallow: /cgi-bin # папка на хостинге

Disallow: /? # все параметры запроса на главной

Disallow: /wp- # все файлы WP: /wp-json/, /wp-includes, /wp-content/plugins

Disallow: /wp/ # если есть подкаталог /wp/, где установлена CMS (если нет,

# правило можно удалить)

Disallow: *?s= # поиск

Disallow: *&s= # поиск

Disallow: /search/ # поиск

Disallow: /author/ # архив автора

Disallow: /users/ # архив авторов

Disallow: */trackback # трекбеки, уведомления в комментариях о появлении открытой

# ссылки на статью

Disallow: */feed # все фиды

Disallow: */rss # rss фид

Disallow: */embed # все встраивания

Disallow: */wlwmanifest.xml # xml-файл манифеста Windows Live Writer (если не используете,

# правило можно удалить)

Disallow: /xmlrpc.php # файл WordPress API

Disallow: *utm*= # ссылки с utm-метками

Disallow: *openstat= # ссылки с метками openstat

Allow: */uploads # открываем папку с файлами uploads

User-agent: GoogleBot # правила для Google (комментарии не дублирую)

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: */wlwmanifest.xml

Disallow: /xmlrpc.php

Disallow: *utm*=

Disallow: *openstat=

Allow: */uploads

Allow: /*/*.js # открываем js-скрипты внутри /wp- (/*/ - для приоритета)

Allow: /*/*.css # открываем css-файлы внутри /wp- (/*/ - для приоритета)

Allow: /wp-*.png # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.jpg # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.jpeg # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.gif # картинки в плагинах, cache папке и т.д.

Allow: /wp-admin/admin-ajax.php # используется плагинами, чтобы не блокировать JS и CSS

User-agent: Yandex # правила для Яндекса (комментарии не дублирую)

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: */wlwmanifest.xml

Disallow: /xmlrpc.php

Allow: */uploads

Allow: /*/*.js

Allow: /*/*.css

Allow: /wp-*.png

Allow: /wp-*.jpg

Allow: /wp-*.jpeg

Allow: /wp-*.gif

Allow: /wp-admin/admin-ajax.php

Clean-Param: utm_source&utm_medium&utm_campaign # Яндекс рекомендует не закрывать

# от индексирования, а удалять параметры меток,

# Google такие правила не поддерживает

Clean-Param: openstat # аналогично

# Укажите один или несколько файлов Sitemap (дублировать для каждого User-agent

# не нужно). Google XML Sitemap создает 2 карты сайта, как в примере ниже.

Sitemap: http://site.ru/sitemap.xml

Sitemap: http://site.ru/sitemap.xml.gz

# Укажите главное зеркало сайта, как в примере ниже (с WWW / без WWW, если HTTPS

# то пишем протокол, если нужно указать порт, указываем). Команда стала необязательной. Ранее Host понимал

# Яндекс и Mail.RU. Теперь все основные поисковые системы команду Host не учитывают.

Host: www.site.ruВ примере я не добавляю правило Crawl-Delay, т.к. в большинстве случаев эта директива не нужна. Однако если у вас крупный нагруженный ресурс, то использование этой директивы поможет снизить нагрузку на сайт со стороны роботов Яндекса, Mail.Ru, Bing, Yahoo и других (Google не учитывает). Подробнее про это читайте в статье Robots.txt.

Ошибочные рекомендации других блогеров для Robots.txt на WordPress

- Использовать правила только для User-agent: *

Для многих поисковых систем не требуется индексация JS и CSS для улучшения ранжирования, кроме того, для менее значимых роботов вы можете настроить большее значение Crawl-Delay и снизить за их счет нагрузку на ваш сайт. - Прописывание Sitemap после каждого User-agent

Это делать не нужно. Один sitemap должен быть указан один раз в любом месте файла robots.txt - Закрыть папки wp-content, wp-includes, cache, plugins, themes

Это устаревшие требования. Однако подобные советы я находил даже в статье с пафосным названием «Самые правильный robots для WordPress 2018»! Для Яндекса и Google лучше будет их вообще не закрывать. Или закрывать «по умному», как это описано выше. - Закрывать страницы тегов и категорий

Если ваш сайт действительно имеет такую структуру, что на этих страницах контент дублируется и в них нет особой ценности, то лучше закрыть. Однако нередко продвижение ресурса осуществляется в том числе за счет страниц категорий и тегирования. В этом случае можно потерять часть трафика - Закрывать от индексации страницы пагинации /page/

Это делать не нужно. Для таких страниц настраивается тег rel=»canonical», таким образом, такие страницы тоже посещаются роботом и на них учитываются расположенные товары/статьи, а также учитывается внутренняя ссылочная масса. - Прописать Crawl-Delay

Модное правило. Однако его нужно указывать только тогда, когда действительно есть необходимость ограничить посещение роботами вашего сайта. Если сайт небольшой и посещения не создают значительной нагрузки на сервер, то ограничивать время «чтобы было» будет не самой разумной затеей. - Ляпы

Некоторые правила я могу отнести только к категории «блогер не подумал». Например:Disallow: /20— по такому правилу не только закроете все архивы, но и заодно все статьи о 20 способах или 200 советах, как сделать мир лучше 🙂

Спорные рекомендации других блогеров для Robots.txt на WordPress

- Комментарии

Некоторые ребята советуют закрывать от индексирования комментарииDisallow: /commentsиDisallow: */comment-*. - Открыть папку uploads только для Googlebot-Image и YandexImages

User-agent: Googlebot-ImageСовет достаточно сомнительный, т.к. для ранжирования страницы необходима информация о том, какие изображения и файлы размещены на ней.

Allow: /wp-content/uploads/

User-agent: YandexImages

Allow: /wp-content/uploads/

Спасибо за ваше внимание! Если у вас возникнут вопросы или предложения, пишите в комментариях!

Оцените статью

Загрузка…

Загрузка…Друзья, буду благодарен за ваши вопросы, дополнения и рекомендации по теме статьи. Пишите ниже в комментариях.

Буду благодарен, если поставите оценку статье.

И снова про robots.txt для WordPress (шпаргалка начинающим) / Habr

Перед каждым блогером (продвинутым, да) рано или поздно встает вопрос: «Чего бы такого написать в robots.txt, чтобы было все в шоколаде?»Совершенно естественно встал данный вопрос и передо мной, а написать хотелось грамотно и с пользой. Полез гуглить и все что нашел, были неуклюжие примеры robots.txt стянутые с официального сайта, которые некоторыми авторами выдавались за собственные поделки, продиктованные редкой музой веб-строительства.

Думаю не стоит и говорить, что такие примеры слабо подходили под наши с вами реалии (читай ПС Яндекс — прим. автора).

Поэтому собрав воедино всю информацию найденную в сети, а также собственные мысли и понимание того «как должно быть» написал следующий вариант.

Что имеем?

Во-первых что важно — разные конструкции для Гугла (и остальных) и для Яндекса.

Обусловлено следующим: Для Гугла в дубликатах прописывается мета-тег canonical (в шаблоне вручную, или при помощи многочисленных сео-плагинов), который должен решать проблему дублирующегося контента, а Яндекс пока этого не понимает, там другие штучки…

Во-вторых у Яндекса прописан Host — что в любом случае не помешает.

В-третьих задача разрешить как можно больше страниц для сапы не стояла, поэтому все лишнее закрыто.

В-четвертых используются более-менее принятые настройки ЧПУ и ссылок. Если у вас иерархия ЧПУ и ссылок другая (например изменены каким-либо плагином) — корректируйте исходя их своих настроек.

Основные ошибки виденные мной:

— зачастую для Яндекса прописывают только директива Host, оставляя Dissalow пустым, но такая конструкция дает право Яндексу опять индексировать все что угодно, несмотря на запреты в первой секции, что, впрочем, логично.

— закрывая категории не закрывают архивы по дате и архив автора.

— не закрывают системные адреса (трекбэки, вход и регистрацию)

Остальное я как мог вынес в комментарии, которые можно смело удалить, если вы со всем разобрались.

Не думаю что он универсален и идеален, но думаю послужит многим хорошей отправной точкой. robots.txt:

User-agent: *

Disallow: /cgi-bin

# запрещаем индексацию системных папок

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

# запрещаем индексацию страницы входа и регистрации

Disallow: /wp-login.php

Disallow: /wp-register.php

# запрещаем индексацию трекбеков, rss-ленты

Disallow: /trackback

Disallow: /feed

Disallow: /rss

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: /xmlrpc.php

# запрещаем индексацию архива автора

Disallow: /author*

# запрещаем индексацию постраничных комментариев

Disallow: */comments

Disallow: */comment-page*

# запрещаем индексацию результатов поиска и другого возможного "мусора"

Disallow: /*?*

Disallow: /*?

# разрешаем индексацию вложений, особо мнительным можно запретить папку wp-content целиком

Allow: /wp-content/uploads

User-agent: Yandex

Disallow: /cgi-bin

# запрещаем индексацию системных папок

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

# запрещаем индексацию категорий

Disallow: /category*

# запрещаем индексацию архивов по датам. Прописываем вручную актуальные года

Disallow: /2008*

Disallow: /2009*

# запрещаем индексацию архива автора

Disallow: /author*

# запрещаем индексацию страницы входа и регистрации

Disallow: /wp-login.php

Disallow: /wp-register.php

# запрещаем индексацию трекбеков, rss-ленты

Disallow: /trackback

Disallow: /feed

Disallow: /rss

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: /xmlrpc.php

# запрещаем индексацию постраничных комментариев

Disallow: */comments

Disallow: */comment-page*

# запрещаем индексацию результатов поиска и другого возможного «мусора»

Disallow: /*?*

Disallow: /*?

# разрешаем индексацию вложений, особо мнительным можно запретить папку wp-content целиком

Allow: /wp-content/uploads

# прописываем директиву Host

Host: mysite.ru

User-agent: Googlebot-Image

Disallow:

Allow: /*

# разрешаем индексировать изображения

User-agent: YandexBlog

Disallow:

Allow: /*

# разрешаем индексировать rss-ленту

PS. Данный файл использую на своих блогах, валидность и правильность проверял в панели веб-мастера, добиваясь нужного мне результата. Поэтому если что-то не устраивает — проверяйте и дописывайте свое.

PPS. Я еще не матерый сеошник, посему где-то могу ошибаться. С robots.txt не ошибается тот, у кого такого файла вообще нет)

Как сделать robots.txt для WordPress.Создаем правильный robots.txt для сайта на WordPress

Приветствую, друзья! В этом уроке мы поговорим о создании файла robots.txt, который показывает роботам поисковых систем, какие разделы Вашего сайта нужно посещать, а какие нет.

Фактически, с помощью этого служебного файла можно указать, какие разделы будут индексироваться в поисковых системах, а какие нет.

Создание файла robots.txt

1. Создайте обычный текстовый файл с названием robots в формате .txt.

2. Добавьте в него следующую информацию :

User-agent: Yandex Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-comments Disallow: /wp-content/plugins Disallow: /wp-content/themes Disallow: /wp-content/cache Disallow: /wp-login.php Disallow: /wp-register.php Disallow: */trackback Disallow: */feed Disallow: /cgi-bin Disallow: /tmp/ Disallow: *?s= User-agent: * Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-comments Disallow: /wp-content/plugins Disallow: /wp-content/themes Disallow: /wp-content/cache Disallow: /wp-login.php Disallow: /wp-register.php Disallow: */trackback Disallow: */feed Disallow: /cgi-bin Disallow: /tmp/ Disallow: *?s= Host: site.com Sitemap: http://site.com/sitemap.xml

3. Замените в в текстовом файле строчку site.com на адрес Вашего сайта.

4. Сохраните изменения и загрузите файл robots.txt (с помощью FTP) в корневую папку Вашего сайта.

5. Готово.

Для просмотра и скачки примера, нажмите кнопку ниже и сохраните файл (Ctrl + S на клавиатуре).

Скачать пример файла robots.txtРазбираемся в файле robots.txt (директивы)

Давайте теперь более детально разберем, что именно и зачем мы добавили в файл robots.txt.

User-agent — директива, которая используется для указания названия поискового робота. С помощью этой директивы можно запретить или разрешить поисковым роботам посещать Ваш сайт. Примеры:

Запрещаем роботу Яндекса просматривать папку с кэшем:

User-agent: Yandex Disallow: /wp-content/cache

Разрешаем роботу Bing просматривать папку themes (с темами сайта):

User-agent: bingbot Allow: /wp-content/themes

Allow и Disallow — разрешающая и запрещающая директива. Примеры:

Разрешим боту Яндекса просматривать папку wp-admin:

User-agent: Yandex Allow: /wp-admin

Запретим всем ботам просматривать папку wp-content:

User-agent: * Disallow: /wp-content

В нашем robots.txt мы не используем директиву Allow, так как всё, что не запрещено боту с помощью Disallow — по умолчанию будет разрешено.

Host — директива, с помощью которой нужно указать главное зеркало сайта, которое и будет индексироваться роботом.

Sitemap — используя эту директиву, нужно указать путь к карте сайта. Напомню, что карта сайта является очень важным инструментом при продвижении сайта! Обязательно указывайте её в этой директиве!

Если остались какие-то вопросы — задавайте их в комментарий. Если же информации в этом уроке для Вас оказалось недостаточно, рекомендую почитать подробнее о всех директивах и способах их использования перейдя по этой ссылке.

Приветствую, друзья! В этом уроке мы поговорим о создании файла robots.txt, который показывает роботам поисковых систем, какие разделы Вашего сайта нужно посещать, а какие нет. Фактически, с помощью этого служебного файла можно указать, какие разделы будут индексироваться в поисковых системах, а какие нет. Создание файла robots.txt 1. Создайте обычный текстовый файл с названием robots в формате .txt. 2. Добавьте в него следующую информацию : User-agent: Yandex Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-comments Disallow: /wp-content/plugins Disallow: /wp-content/themes Disallow: /wp-content/cache Disallow: /wp-login.php Disallow: /wp-register.php Disallow: */trackback Disallow: */feed Disallow: /cgi-bin Disallow: /tmp/ Disallow: *?s= User-agent: * Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-comments Disallow: /wp-content/plugins Disallow: /wp-content/themes…

Создание и настройка robots.txt

Рейтинг: 4.5 ( 32 голосов ) 100Правильный robots txt для WordPress (и не только)

Правильный robots txt для WordPress.

Содержание статьи

Приветствую, дорогие вебмастера! С помощью этой статьи, я хочу показать вам как правильно настроить файл robots.txt для конкретного сайта. Но, чтобы научиться его составлять, вам необходимо вдумчиво прочитать эту статью (возможно, не один раз). Только поняв, что вы будете делать, вы сможете настраивать этот файл для любого сайта. Будь то интернет-магазин, корпоративный сайт или блог, не важно.

Для тех, кто ищет готовый вариант (универсальный) для всех сайтов, я вас разочарую… Такого не существует! На каждом сайте есть свои собственные разделы, папки и файлы, о которых невозможно предугадать заранее. Так что, лучше научиться один раз и не мучить каждый раз поисковик.

Составлять правильный файл robots txt мы будем сразу и для Яндекс’а и для Google одновременно. Иначе, смысла особого вообще не вижу. Я считаю, продвигаться нужно сразу в обоих и глупо делать упор только на один. Алгоритмы меняются постоянно и то, что работало сегодня во благо, завтра может сработать против.

Псевдо – правильный файл robots

Итак, для начала давайте разберемся что нужно закрывать в этом самом файле, а что уже давно кануло в лету. Все примеры правильного роботса, которые вы сможете найти в интернете (или уже нашли), написаны зачастую для конкретного сайта и к вашему не имеет вообще никакого отношения.

Обычно, в файле роботс советуют закрывать страницу входа в админку wp-login.php, саму страницу админки wp-admin, да и вообще всю директорию wp. Так же закрывают стили и скрипты js и css, и конечно же не нужные для индексирования страницы и всё в этом духе…

Но возникает вопрос, а нужно ли? Ведь большинство директорий, которые нужно было закрывать в роботс.тхт раньше, теперь закрываются более разумным методом – тегом robots. Почему более разумный спросите вы? На этот вопрос поможет ответить представитель Google Джон Мюллер в этом видео (включите русские титры, видео начинается с нужного места):

Немного поясню. Джон предупредил, что если в robots txt закрыть какую-то страницу или директорию, но при этом на неё вдруг будет проставлена ссылка в интернете, то эта страница или директория будет проиндексирована не зависимо от правила файла роботс.

С каждым годом, файл robots txt становиться всё бесполезнее и бессмысленнее. И этот ответ, тому подтверждение. Закрытие в этом файле вас уже можно сказать не спасёт, ссылка может появиться тысячами способов как автоматических, так и ручных. Поэтому Мюллер рекомендует закрывать не нужные страницы не файлом роботс, а тегом robots. Что собственно и я советую вам научиться делать.

Бессмысленность файла роботс.

Проанализируйте сами, большинство директив в файле уже упразднили к 2019 году:

- Crawl-delay (таймаут для роботов) перестали учитывать.

- Host (главное зеркало) тоже упразднили.

- Закрывать js и css Гугл не рекомендует, вебмастер ругается.

- Директива wp- и другие технические страницы закрываются тегом.

- Собственно, всё. Закрывать больше нечего.

А судя по тому, что как минимум, поисковик Google может проиндексировать закрытые страницы в файле роботс (не удивлюсь что и Яндекс тоже), то смысла закрывать не нужные страницы таким образом уже нет.

Единственное, что осталось для файла robots, так это пользовательские папки и директории, на которые точно никто не будет ссылаться и нет возможности проставить тег robots. К ним относятся собственные папки и пользовательские файлы у которых нет собственных страниц (например файлы для скачивания).

Что касается get параметров, в Яндекс’е есть специальная директива Clean-param, но используют её единицы. В Google же вообще не упоминается об этой директиве, похоже поэтому она и не обрела популярности в глазах вебмастеров. Поэтому, если вы всё же решили закрыть страницы с get параметрами, то закрывайте обычным синтаксисом.

Синтаксис файла для поисковиков.

Ниже представлена официальная документация для наших двух поисковиков. В принципе, этого будет достаточно, потому что остальным поисковикам приходиться ровняться на этих двух гигантов.

- Синтаксис файла robots.txt Яндекс.

- Синтаксис файла robots.txt Google.

Но я считаю, это бессмысленная затея, закрывать генерируемые страницы с get параметрами. Я никогда не закрываю такие страницы и проблем не возникало. Так что, решайте сами, этот пункт абсолютно не критичен.

Правильная настройка robots txt.

Простое удаление портянки из файла проблему не решит конечно же. Перед этим, нужно настроить закрытие не нужных страниц тегом robots, а уже потом удалять всё ненужное из файла. В идеале, у вас должен получиться вот такой роботс /robots.txt. То есть, закрыты только пользовательские директории и файлы, которые не должны быть в индексе и на которые никто не будет ссылаться в принципе. Директиву Host можете оставить, а можете и удалить. Поисковики её уже не учитывают, поэтому не парьтесь. Я оставил, мне она не мешает.

Закрывать ли wp-admin, wp-login и т.д.?

Закрывать эти директории уже нет необходимости и вот почему. Все технические страницы WordPress перенаправляет для не авторизованных пользователей на страницу входа wp-login.php. А если открыть код этой страницы CTRL+U и проверить его, вы увидите тег проставленный ВП автоматически:

<meta name='robots' content='noindex,noarchive' />

То есть, движок уже закрыл эту страницу от индексации. И все остальные страницы тоже, так как не авторизованный пользователь на них не сможет попасть, в том числе и краулер поисковиков. Так что, директории wp-… можно смело удалять из файла robots txt. Идем дальше.

Закрывать ли от индексации js и css?

Как вы уже наверное знаете, поисковики очень много внимания уделяют мобильным (адаптивным) версиям сайта. И чтобы определить на сколько мобильна страница, краулеру необходимо проиндексировать файлы стилей и скриптов, чтобы понять это. Так вот, если вы будете закрывать стили css и скрипты js от индексации, большая вероятность что краулер посчитает ваш сайт убогим не адаптивным. Отсюда понижение выдачи, потеря посещаемости и все вытекающие.

Вот так должны воспринимать ваш сайт поисковики:

Адаптивность под мобильные Яндекс

Адаптивность под мобильные Яндекс

Адаптивность под мобильные Google

Адаптивность под мобильные GoogleКонечно же, не стоит забывать о самой мобильности. Если сайт не адаптирован, открытие или закрытие тут явно не поможет избавиться от ошибок в вебмастерах. Исходя из выше описанного, закрытие стилей и скриптов в файле robots txt не желательное занятие. Удаляйте эти директивы и забудьте о них. Едем дальше.

Закрывать ли wp-json, author, embed, page и т.д.?

Все эти технические страницы закрываются с помощью тега роботс. Отлично с этим справляется плагин Yoast SEO, рекомендую ознакомиться с обзором. В нем можно будет закрыть все не нужные архивы и метки в автоматическом режиме.

Что касается embed, pingback и подобных приблуд, с этим отлично справляются плагины Clearfy Webcraftic или Wpshop. Там вы сможете отключить не нужные директории сайта программно и закрывать их дополнительно ещё где либо не потребуется.

И наконец, что касается страниц пагинации page. Закрывать от индексации их даже тегом роботс не рекомендуется. Для таких страниц отлично подходит тег rel=»canonical», подробнее про него я писал ранее.

Разбор примера популярного роботса для ВП.

Вижу что многим читателям трудно воспринять теорию без практики, поэтому дополняю статью конкретным примером. Возьмём популярный вариант robots и разберём его по полочкам. Итак, вот он сам файл:

User-agent: * Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: */comments Disallow: /category/*/* Disallow: /trackback Disallow: */trackback Disallow: */*/trackback Disallow: */*/feed/*/ Disallow: */feed Disallow: /feed/ Disallow: /*?* Disallow: /?s= User-agent: Yandex Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /feed/ Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /trackback Disallow: */comments Disallow: /category/*/* Disallow: */trackback Disallow: */*/trackback Disallow: */*/feed/*/ Disallow: */feed Disallow: /*?* Disallow: /?s= Host: https://kakoytosite.ru Sitemap: https://kakoytosite.ru/sitemap.xml

Что мы видим? Первое что бросается в глаза, это дублирование условий для всех роботов user-agent: * и отдельно зачем-то для Яндекса user-agent: Yandex. Хочется сразу же спросить у автора – Вы действительно думаете что робот Яндекса тупой и не поймёт общие правила со звёздочкой?

(это конечно же риторический вопрос).

(это конечно же риторический вопрос).

Ну что ж, а теперь по порядку:

Disallow: /wp-login.php Disallow: /wp-register.php

Если вы читаете эту статью не из прошлого, то на борту у вас минимум должна быть версия WordPress 5.x.x не меньше. Так вот, страницы входа wp-login.php и wp-register.php по умолчанию наделены специальным тегом robots – nofollow. То есть, ВордПресс уже сам закрыл эти страницы от индексации и вам не нужно их больше нигде закрывать.

Disallow: /cgi-bin

Директория сервера это классика, только не понятно откуда она взялась. Эта директория изначально отдает 403 ошибку сервиса при переходе, поэтому она никак не может быть проиндексирована поисковиками. Стало быть, этот пункт из файла можно так же смело удалить.

Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes

Первые две директории wp-admin и wp-includes являются техническими. То есть, к ним нет доступа не авторизованным пользователям. В том числе и пауку (краулеру) не удастся попасть на эти страницы. Он будет автоматически перенаправлен на страницу входа wp-login.php которая уже закрыта тегом роботс от индексации.

Директории /wp-content/… отвечают за файлы ваших тем и плагинов, в том числе и за файлы js и css. Если закрывать эти файлы от индексации, то Google не сможет прочитать их и в вебмастере вы увидите ошибки, что сайт не адаптирован. Хотя он может быть полностью мобильным.

Disallow: */comments Disallow: /category/*/*

Скорее всего, это пользовательские директивы, которые были прописаны под конкретный сайт (как я и говорил в начале) и никаким боком к вашему не относятся. Но все просто копируют готовый и даже не думают, что они делают.

Disallow: /trackback Disallow: */trackback Disallow: */*/trackback

Это одна из приблуд движка WordPress. С помощью неё движок посылает уведомления на сайты, ссылки на которые у вас будут в статьях. Отключается это штатными средствами. В админке перейдите по пути Настройки > Обсуждение и уберите галочки на первых двух (верхних) пунктах.

Disallow: */*/feed/*/ Disallow: */feed Disallow: /feed/

Вообще не понимаю, зачем закрывать фиды от индексации? Поисковик фиды не индексирует и не выводит в выдаче. Вы хоть раз видели в поиске страницу фидов?

Это один из бесполезных сео-маразмов. Удаляйте эти бессмысленные правила.

Это один из бесполезных сео-маразмов. Удаляйте эти бессмысленные правила.Disallow: /*?* Disallow: /?s=

Эти директории отвечают за страницы с get параметрами и за страницу поиска по сайту. Здесь уже решать вам, нужны ли они в индексе или нет. Я никогда их не закрываю и бед не знаю.

Что же закрывать в robots txt.

Исходя из выше написанного, остается закрывать только пользовательские папки и файлы, которые не относятся на прямую к самому сайту WordPress. То есть, ни папки темы, ни плагинов, а собственные, со сторонними файлами (например для скачивания и т.д.).

Закрывать картинки от индексирования – считаю маразмом. Это относиться к тому случаю, когда вы начитавшись, что не уникальные картинки портят репутацию, решаете их закрыть. Это бред собачий, но это личное ИМХО.

А вот различные рекламные баннеры и файлы для скачивания, можно поместить в отдельную пользовательскую папку (или в несколько) и закрыть эту папку от индексации в файле роботс. Собственно так я и поступил с папкой files в моём роботсе.

Заключение.

Как видите, файл robots txt потерял свою актуальность к 2019 году (по крайней мере в мире WordPress). Закрывать практически нечего, поэтому данный файл обречен пустовать и мозолить всем вебмастерам глаз. Надеюсь я был убедителен, если есть что сказать, прошу в комментарии. На этом блоге свобода слова, так что высказывайтесь на здоровье. На этом у меня всё, увидимся на страницах wpmaster.kz!

Правильный robots.txt для WordPress

О том, как сделать правильный robots.txt для WordPress написано уже достаточно. Однако, чтобы угодить своим читателям, я решил опубликовать свой пост на эту тему. Тем более, что моими коллегами эта тема раскрыта не полностью и тут можно многое добавить.

Что такое robots.txt и зачем он нужен?

robots.txt это текстовый документ, составленный в обыкновенном блокноте, расположенный в корневой директории блога и содержащий в себе инструкции по индексации для поисковых роботов. Проще говоря, что индексировать, а что нет. Наличие этого файла является обязательным условием для качественной внутренней поисковой оптимизации блога.

Как известно, блоги на платформе WordPress содержат в себе множество дублей (копий основного содержимого блога), а также целый набор служебных файлов. Дубли контента снижают его уникальность на домене и поисковые роботы могут наложить на блог серьезные штрафные санкции.

Чтобы повысить уникальность контента, облегчить поисковым ботам работу и тем самым улучшить качество индексации блога, нам и нужен robots.txt.

Правильный robots.txt для WordPress

Рассмотрим на примере моего robots.txt, как его правильно оформить и что в него должно входить.

Скачайте его себе на жесткий диск по этой ссылке и откройте для редактирования. В качестве редактора текстовых файлов настоятельно рекомендую использовать Notepad++.

Строки 6,7: Принято считать, что необходимо закрывать поисковым роботам доступ к служебным файлам в папках «wp-content» и «wp-includes». Но, Гугл по этому поводу нам говорит следующее:

Чтобы обеспечить правильное индексирование и отображение страниц, нужно предоставить роботу Googlebot доступ к JavaScript, CSS и графическим файлам на сайте. Робот Googlebot должен видеть ваш сайт как обычный пользователь. Если в файле robots.txt закрыт доступ к этим ресурсам, то Google не удастся правильно проанализировать и проиндексировать содержание. Это может ухудшить позиции вашего сайта в Поиске.

Таким образом, для Googlebot не рекомендуется запрещать доступ к файлам в этих папках.

Строка 40: С весны 2018 года директива «Host», указывающая главное зеркало сайта Яндексу, больше не действует. Главное зеркало для нашей поисковой системы теперь определяется только через 301 редирект.

Строки 42,43: Если у Вас еще не создана карта сайта, обязательно сделайте ее. В пути к файлам карты вместо моего адреса wordpress-book.ru пропишите свой. Этот ход сделает индексацию блога поисковиками полной и увеличит ее скорость.

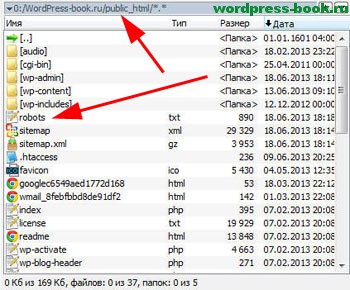

Уже сейчас, можно сказать, что ваш правильный robots.txt для WordPress готов. В таком виде он подойдет для абсолютного большинства блогов и сайтов. Останется только закачать его в корень блога (обычно в папку public_html).

Сделать robots.txt для блога можно и с помощью плагина, например, PC Robots.txt. С его помощью вы сможете создать и редактировать свой robots.txt прямо в админке блога. Но я не советую использовать плагины для создания robots.txt, чтобы исключить лишнюю нагрузку на блог.

Содержание robots.txt любого блога или сайта, если он конечно есть, вы всегда можете посмотреть. Для этого достаточно в адресной строке браузера ввести к нему путь – https://wordpress-book.ru/robots.txt.

Ниже приведена информация по содержанию этого документа и некоторые рекомендации по его оформлению и анализу.

Звездочка «*», прописанная в тексте robots.txt, означает, что на ее месте допускается последовательность любых символов.

Директива «User-agent» определяет, для каких поисковых роботов даны указания по индексации, прописанные под ней. Таким образом, «User-agent: *» (строка 1) указывает, что инструкции, прописанные под ней, предназначены для всех поисковых систем.

Строка 21: Персонально для Яндекса под «User-agent: Yandex» дублируем список этих команд. Дублирование инструкций для Яндекса дает нам гарантию их выполнения поисковой системой.

Директива «Disallow» запрещает индексацию прописанного для нее каталога или страниц. Директива «Allow» разрешает. Командой «Disallow: /wp-content/» (строка 7) я запретил индексацию служебного каталога «wp-content» на сервере и соответственно всех папок в ней с их содержимым, но командой «Allow: /wp-content/uploads» (строка 8) разрешил индексировать все картинки в папке «upload» каталога «wp-content». Так как «Allow» является приоритетной директивой для поисковых роботов, то в индекс попадут только изображения папки «upload» каталога «wp-content».

Для директивы «Disallow» имеет смысл в некоторых случаях дополнительно прописывать следующие запреты:

- — /amp/ — дубли ускоренных мобильных страниц. На всякий случай для Яндекса.

- — /comments — закрыть от индексации комментарии. Зачем закрывать содержащийся в комментариях уникальный контент? Для большей релевантности ключевых слов и неиндексации исходящих ссылок в комментариях. Вряд ли это поможет.

- — /comment-page-* — другое дело древовидные комментарии. Когда комментарии не помещаются на одну страницу (их количество вы проставили в настройках админки), создается дубль страницы типа wordpress-book.ru/…/comment-page-1. Эти дубли конечно же надо закрывать.

- — /xmlrpc.php — служебный файл для удаленных вызовов. У меня его нет и соответственно нет индексации и без запрета.

- — /webstat/ — папка со статистикой сайта. Эта папка есть тоже далеко не у всех.

Нельзя не упомянуть про редко используемую, но очень полезную директиву для Яндекса — «Crawl-delay». Она задает роботу паузу во времени в секундах между скачиванием страниц, прописывается после групп директив «Disallow» и «Allow» и используется в случае повышенной нагрузки на сервер. Прописью «Crawl-delay: 2» я задал эту паузу в 2 секунды. При нормальной работе сервера качество индексации не пострадает, а при пиковых нагрузках не ухудшится.

Некоторым веб-мастерам может понадобится запретить индексацию файлов определенного типа, например, с расширением pdf. Для этого пропишите — «Disallow: *.pdf$». Или поместите все файлы, индексацию которых требуется запретить, в предварительно созданную новую папку, например, pdf, и пропишите «Disallow: /pdf/».

При необходимости запрета индексации всей рубрики, такое бывает ,например, при публикации в нее чужих интересных записей, пропишите — «Disallow: /nazvanie-rubriki/*», где «nazvanie-rubriki», как вы уже догадались — название рубрики, записи которой поисковикам индексировать не следует.

Тем, кто зарабатывает на своем блоге размещением контекстной рекламы в партнерстве с Google AdSense, будет нелишним прописать следующие две директивы:

User-agent: Mediapartners-Google

Disallow:

Это поможет роботу AdSense избежать ошибок сканирования страниц сайта и подбирать для них более релевантные объявления.

wp-content/uploads/2014/02/YouTube_Downloader_dlya_Ope.jpg»,tid: «OIP.M3a4a31010ee6a500049754479585407do0

Обнаружил у себя только что вот такой вот новый вид дублей в Яндекс Вебмастере. 96 штук уже накопилось и это не предел. А ведь совсем недавно у wordpress-book.ru с дублями был полный порядок. Есть подозрение, что шлак с идентификатором tid:»OIP появляется в индексе поисковика после скачивания картинок роботом Яндекса. Если не лень, посмотрите сколько таких несуществующих страниц разных сайтов уже участвуют в поиске.

Понятно, что с этим чудом надо что-то делать. Достаточно добавить запрещающую директиву — «Disallow: /wp-content/uploads/*.jpg*tid*» в robots.txt. Если на сайте есть картинки png, gif и т.д., добавьте директивы с соответствующими расширениями изображений.

При редактировании robots.txt, учтите, что:

— перед каждой новой директивой «User-agent» должна быть пустая строка, которая обозначает конец инструкций для предыдущего поисковика. И соответственно после «User-agent» и между «Disallow» и «Allow» пустых строк быть не должно;

— запретом индексации страниц в результатах поиска «Disallow: /*?*» вы заодно можете случайно запретить индексацию всего контента, если адреса страниц вашего блога заданы по умолчанию со знаком вопроса в виде — /?p=123. Советую сделать для адресов ЧПУ (человеко понятные урлы :-)). Для этого в настройках постоянных ссылок выберите произвольный шаблон и поставьте плагин Rus-to-Lat.

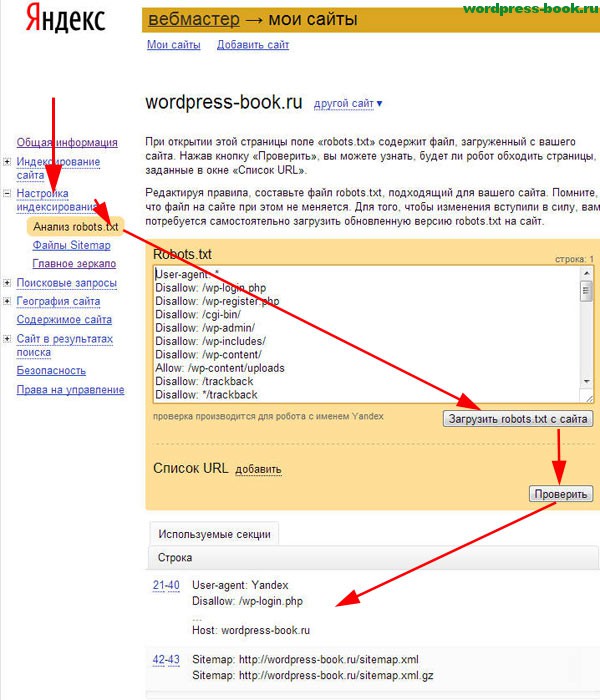

Анализ robots.txt

Теперь, когда ваш robots.txt отредактирован и залит на сервер, остается только проверить, правильно ли он работает.

Зайдите в свой аккаунт Яндекс Вебмастер и перейдите «Настройки индексирования» → «Анализ robots.txt». Нажмите на кнопку «Загрузить robots.txt с сайта» и далее на кнопку «Проверить».

Если Яндексу понравится ваш файл, под кнопкой «Проверить» появится сообщение, примерно как на картинке выше.

Недавно в инструментах для веб-мастеров Гугла появилось очень полезная функция — «Инструмент проверки файла robots.txt«. Можно проверить свой файл на наличие ошибок и предупреждений.

Просто в своем аккаунте перейдите «Сканирование» → «Инструмент проверки файла robots.txt«.

Через некоторое время, когда бот Яндекса скачает ваш robots.txt, проанализируйте в Яндекс Вебмастере адреса страниц вошедших в индекс и исключенных из него в robots.txt. Вошедшие в индекс дубли срочно запрещайте к индексации.

Теперь ваш robots.txt для WordPress правильный и можно поставить еще одну галочку под пунктом выполнения задач по внутренней поисковой оптимизации блога.

robots.txt запретить индексацию всем

При создании тестового блога или при самом его рождении, если вы хотите полностью запретить индексацию сайта всеми поисковыми системами, в robots.txt должно быть прописано всего лишь следующее:

User-agent: *

Disallow: /

Правильный robots.txt для WordPress сайта

(Последнее обновление: 31.05.2019)Привет всем! Сегодня тема очень важная это — robots.txt для сайта WordPress. Поисковые роботы заходя на сайт или блог первым делом ищут файл robots.txt. Что такое robots.txt? Robots.txt — служебный файл, который находится в корневом каталоге сайта и содержит набор директив, позволяющих управлять индексацией сайта. Он позволяет указывать поисковым системам, какие страницы сайта или файлы должны присутствовать в поиске, а какие — нет. Когда краулер приходит на хостинг, файл robots.txt является одним из первых документов, к которому он обращается.

Создание robots.txt для сайта WordPress

Как создать файл robots.txt для WordPress

Robots.txt в большинстве случаев используется для исключения дубликатов, служебных страниц, удаленных страниц и других ненужных страниц из индекса поисковых систем. Кроме того, именно через robots.txt можно указать ПС адрес карты сайта.

Воспользуйтесь любым текстовым редактором (например, блокнотом), создайте файл с именем robots.txt и заполните его как показано ниже. Файл должен называться robots.txt, а не так — Robots.txt или ROBOTS.TXT.

После этого необходимо загрузить файл в корневой каталог вашего сайта.

Файл robots.txt должен располагаться строго в корне сайта и он должен быть единственным.

Оптимальный, правильный robots.txt для сайта WordPress. Общий для Google и Яндекс . Такой robots.txt у меня стоит на всех сайтах:

User-agent: * Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: /core/ Disallow: */feed Disallow: *?s= Disallow: *&s= Disallow: /search Disallow: */embed Disallow: *?attachment_id= Disallow: /id_date Disallow: */page/ Disallow: *?stats_author Disallow: *?all_comments Disallow: *?post_type=func Disallow: /filecode Disallow: /profile Disallow: /qtag/ Disallow: /articles/ Disallow: /artictag/ Allow: */uploads Allow: /*/*.js Allow: /*/*.css Allow: /wp-*.png Allow: /wp-*.jpg Allow: /wp-*.jpeg Allow: /wp-*.gif Allow: /*ajax Sitemap: http://example.com/sitemap.xml

Стандартный robots.txt WordPress

Раздельный для Google и Yandex :

User-agent: Yandex Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-json/ Disallow: /wp-login.php Disallow: /wp-register.php Disallow: */embed Disallow: */page/ Disallow: /cgi-bin Disallow: *?s= Allow: /wp-admin/admin-ajax.php Host: site.ru User-agent: * Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-json/ Disallow: /wp-login.php Disallow: /wp-register.php Disallow: */embed Disallow: */page/ Disallow: /cgi-bin Disallow: *?s= Allow: /wp-admin/admin-ajax.php Sitemap: http://сайт.ру/sitemap.xml

Замените сайт.ру на ваш URL адрес блога. Смело можете скормить данным файлом поисковые системы Яндекс и Google.

Как настроить индивидуально важный файл robots.txt можно прочитав эти справки:

На странице помощи Яндекса. Проверить правильность составления файла можно в webmaster.yandex — Настройка индексирования — Анализ robots.txt. Далее, в Google robots.txt можно проверить по этой ссылке. Не забудьте что проверяемый блог должен быть добавлен в Инструменты для веб-мастеров Google и Яндекс.

Обратите внимание, что для Яндекса и Google правила составления robots.txt немного различаются. Вот ещё полезный ресурс для изучения robotstxt.org.ru. Вот и всё.

Теперь остаётся загрузить созданный файл в корневой каталог вашего блога. Корень блога это — папка public_html, где находятся файл config.php, index.php и так далее.

В заключение

Создание и тщательная подготовка robots.txt крайне важны. При его отсутствии поисковые роботы собирают всю информацию, относящуюся к сайту. В поиске могут появиться незаполненные страницы, служебная информация или тестовая версия сайта.

Вот на этом позвольте с вами не надолго попрощаться. Удачи. До новых встреч на страницах блога.

Поделиться в социальных сетях

Robots.txt для WordPress, идеальный вариант robots.txt для WP

Файл robots.txt это первоначальный, и один из главнейших инструментов для корректной индексации ваших сайтов и их контента. Отсутствие данного файла приведет к печальным последствиям которые тяжело будет исправить. От того как вы настроите robots.txt зависит что попадет в выдачу по запросам в поисковых системах. Сейчас рассмотрим правильный файл robots.txt для WordPress сайта.

Для чего использовать robots.txt?

Перед тем как приступать к созданию и наполнению давайте разберем саму суть данного файла.

Ваш сайт это набор файлов и папок, некоторые из которых нужно защитить от чтения от сторонних глаз, которыми являются так же и поисковые роботы, пришедшие прочитать и запомнить наш контент, для дальнейшей выдачи в поиске.

Чем занимается поисковой робот на сайте?

Итак, к примеру ваш сайт посетил поисковой робот, что он делает в первую очередь? Во-первых пытается найти уникальную информацию, которую сможет занести в свою базу данных. Если роботс отсутствует, а именно к нему в первую очередь обращается робот, тогда он начинает «читать» файлы находящиеся в корне сайта, что конечно же нам не очень понравиться, ведь он не только не найдет там нужную ему информацию, а и прочитает наши данные настроек, которые созданы для нашей личной цели. Именно для этого и существует robots.txt. Он дает указания роботу куда ходить нужно, а куда заглядывать не стоит.

Создание и размещение файла на сайте WordPress.

Для того что бы создать путеводитель для роботов, вам потребуется обычный блокнот windows, в котором вы будете прописывать нужные команды для поисковых роботов. После этого нужно сохранить файл в формате «txt», под названием «robots». На этом создание завершено, далее в статье мы рассмотрим какие же команды должны находиться в robots.txt для WordPress.

Где размещать?

Robots.txt размещается на вашем хостинге, непосредственно в корневой папке сайта, куда мы перенесли наш сайт. Теперь поисковой робот перед тем как лазить по нашему сайту, сначала спросит разрешение куда ему можно, а куда запрещено заходить.

Важно: при размещении документа в подкаталогах, роботы не смогут найти этот файл.

Зайдя к вам на сайт робот заходит смотрит предназначеную для него «инструкцию» и начинает его изучать. Изучив до конца он пойдет по выбранному вами пути индексации, и будет игнорировать те директории, папки и URL к которым вы запретили обращаться.

Что включает в себя роботс?

Robots.txt несет в себе информативные данные для поисковых роботов и включает в себя такие основные «команды»:

User-agent

Указывает на имя потенциального робота посетителя. Синтаксис «User-agent: *» будет означать что данным командам должны следовать все роботы. Варианты для отдельных роботов рассматривать не будем, их очень много. По этому для примера будет только два варианта (для всех роботов и отдельно для Яндекс).

Disallow

Команда для роботов, рассказывающая о том куда ходить не стоит, запрещает чтение указанных адресов и файлов.

Allow

Команда которая рекомендует «направление» на индексирования данного адреса или файла.

Host

Данная команда указывает роботу, какой из вариантов сайта будет нашим главным зеркалом сайта.

Sitemap

Место нахождения xml карты сайта по которой должен пробежаться посетивший нас робот, в той части за которой он пришел (контент сайта).

Правильный robots.txt для сайта на CMS WordPress.

Для того что бы правильно настроить файл robots.txt специально под «движок» WordPress нужно для начала понимать что ищут роботы и что им будет интересно.

А наши паучки ищут контент нашего ресурса, и им совершенно не нужно знать о всех остальных конфигурационных данных наших сайтов. Во первых они им приходятся не по вкусу, и от переедания таковых они могут покинуть наш сайт так и не найдя то что нам бы хотелось да еще и вынесут наши запрещенные для общего глаза данные на общее обозрение.

Говоря о требуемых размещения директорий в robots.txt для WordPress, нам нужно разобраться с главной (корневой) папкой нашего сайта, в которой мы обнаружим огромное количество стандартных файлов и папок. Роботам незачем их читать, они не найдут там то что ищут, по этому нужно запрещать индексировать по возможности весь «лишний мусор».

Подумайте сами чем может сулить нам например индексация нашего wp-config.php. Робот просто возьмет и «расскажет» всем о наших вводных данных к нашим базам данных, а это крайне плохо для нас.

Сейчас я покажу готовый вариант. Затем разберем каждую строчку в расширенном описании. Итак, правильный robots.txt для WordPress должен выглядеть так:

Disallow: /wp-

Disallow: */trackback

Disallow: /*?*

Disallow: /?s=*

Disallow: */author

Disallow: /2016

Disallow: /xmlrpc.php

Allow: /wp-content/uploads/

Allow: *.js

Allow: *.css

Host: site.ru

Sitemap: http://site.ru/sitemap.xml

Теперь посмотрим как мы смогли добиться такого короткого содержания файла robots.txt для WordPress, рассмотрим расширенную версию файла и постепенно уберем повторы:

Disallow: /wp-admin # Блокируем индексацию папки admin

Disallow: /wp-includes # папки includes

Disallow: /wp-content/languages # папки content/languages

Disallow: /wp-content/plugins # папки content/plugins

Disallow: /wp-content/cache # папки content/cache

Disallow: /wp-content/themes # папки content/themes

Disallow: /trackback # блокируем индекс всех возможных трекбеков

Disallow: */trackback

Disallow: */*/trackback

Disallow: */feed # блокируем индексацию фидов, новостных лент всех вариантов

Disallow: /feed/

Disallow: /?feed=

Disallow: */*/feed

Disallow: */*/feed/*/

Disallow: /*?* # запрет индекса всех ссылок (защита от дублей)

Disallow: /tag # каталоги находящихся в разных директориях ( метки, категории )

Disallow: /tag/*

Disallow: /?s=*

Disallow: /page/* # запрещаем лишние страницы в WP, создающие дубли

Disallow: /author # блокировка индексации автора

Disallow: /2015 # дублирование ссылок с архива # далее блокировка всех административных файлов

Disallow: /xmlrpc.php

Disallow: /wp-activate.php

Disallow: /wp-blog-header.php

Disallow: /wp-comments-post.php

Disallow: /wp-config.php

Disallow: /wp-cron.php

Disallow: /wp-links-opml.php

Disallow: /wp-load.php

Disallow: /wp-login.php

Disallow: /wp-mail.php

Disallow: /wp-register.php

Disallow: /wp-settings.php

Disallow: /wp-signup.php

Disallow: /wp-trackback.php

Disallow: /wp-config-sample.php

Allow: /wp-content/uploads/ # Разрешаем индексировать наши загруженные картинки

Host: site.ru # Указываем основное зеркало

Sitemap: http://site.ru/sitemap.xml # Направляем робота на наши страницы контента

Указанный выше пример заблокирует от индексации все ненужные для поисковой оптимизации файлы и ссылки и укажет на тот материал который должен быть проиндексирован.

Ну уж очень длинный у нас вышел пример, сейчас мы его будем упрощать. Для начала возьмемся за файлы и папки с префиксом «wp-« их все можно объединить воедино.

Disallow: /wp-

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */feed

Disallow: /feed/

Disallow: /?feed=

Disallow: */*/feed

Disallow: */*/feed/*/

Disallow: /*?*

Disallow: /tag

Disallow: /tag/*

Disallow: /?s=*

Disallow: /page/*

Disallow: /author

Disallow: /2015

Disallow: /xmlrpc.php

Allow: /wp-content/uploads/

Allow: *.js

Allow: *.css

Host: site.ru

Sitemap: http://site.ru/sitemap.xml

Значительно уменьшили, но это не предел, пойдем немножко дальше и постараемся еще сократить, да еще и проделать необходимые внутренние настройки.

Все дело в том что при таком варианте файла, Google все равно внесет запрещенные вами страницы в индекс, но выглядеть они будут иначе:

Это не столь опасно как открытые дубли, но все же лучше от этого избавляться. Для того что бы исправить данную ситуацию можно воспользоваться сразу несколькими методами. Я расскажу о самом быстром и простом — запрет индексирования страниц с помощью Google Webmasters Tools «Параметры URL». Кстати в рекомендациях для Яндекса лучше оставить параметр «feed» в указанном варианте.

Избавились от feed с помощью Google, теперь для альтернативы запретим индексирование пагинации с помощью плагина, который скорее всего используется вами, если же это не так, тогда альтернативный так же подойдет. Речь идет о All in One SEO и его настройках тегов «robots» и «canonical».

Для того что бы запретить индексировать поисковикам не нужные нам страницы, такие как страницы пагинации всех видов (главной, рубрик и меток) нужно всего навсего поставить галочки в нужных местах.

Сперва включим канонические ссылки на главные страницы, для избежания их дублирования.

Что мы сделали? В общем все что было нужно, мы указали на страницах которые дублируют наш контент ссылку на основную страницу, что укажет роботу что именно нужно сканировать и считать за основной контент. Теперь добавим еще мета тег robots.

После проведенных настроек, снова обращаемся к нашему варианту файла и смотрим что получилось:

Disallow: /wp-

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: /*?*

Disallow: /?s=*

Disallow: /author

Disallow: /2015

Disallow: /xmlrpc.php

Allow: /wp-content/uploads/

Allow: *.js

Allow: *.css

Host: site.ru

Sitemap: http://site.ru/sitemap.xml

По поводу меток и рубрик вопрос спорный, вы можете оптимизировать рубрики, и добиться результата с которым ваши страницы категорий будут не вредны, а наоборот принесут дополнительный трафик. Метки можно подогнать под поисковики аналогично рубрикам.

Если тема, которую вы установили использует картинки, тогда лучше открыть их для индекса:

Allow: /wp-content/themes/название вашей темы/images

Если вы проигнорируете это, у вас могут возникнуть проблемы с поисковиками, они не любят когда от них скрывают важную информацию.

Пример можно расширять, например добавлением запрета для индексации определенных ссылок на страницы, обычно это страницы повторы которые вредят нашей оптимизации.

В документе обычно не указывают конкретно для всех поисковых роботов по отдельности, а делаю два набора команд один для всех второй для Яндекса.

User-agent: *

Disallow: /wp-

…

User-agent: Yandex

Disallow: /wp-

…

Host: site.ru

Sitemap: http://site.ru/sitemap.xml

Host — нужно обязательно указывать, пренебрежение приведет к дублирования индексации ваших страниц между www.site.ru и site.ru, что рассеет ваш трафик и пагубно скажется на вашем сайте.

Как правильно создать карту сайта можно почитать в отдельных уроках по WordPress.

На этом урок по созданию файла robots.txt заканчивается, и помните что от этого по большей степени зависит судьба индексации ваших страниц.

Рекомендую почитать: