robots.txt для WordPress — что это и как его использовать

Искусство и науку повышения рейтинга вашего сайта в различных поисковых системах обычно называют SEO (поисковая оптимизация). И когда дело доходит до SEO, существует множество различных аспектов, возможно, слишком много, чтобы охватить их в одной статье. Вот почему мы сосредоточимся только на одном – robots.txt WordPress. В этой статье подробнее рассмотрим, что такое robots.txt и как его использовать, обсудим различные способы создания файла и рассмотрим лучшие практики в отношении его директив.

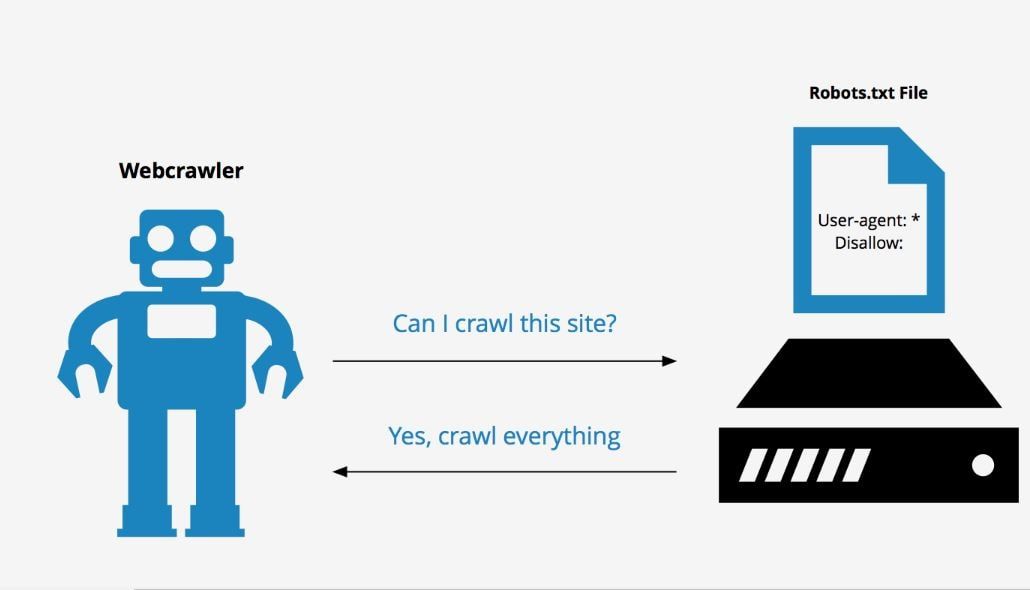

Robots.txt – это текстовый файл, расположенный в корневом каталоге WordPress. К нему можно получить доступ из браузера, открыв URL-адрес your-website.com/robots.txt. Он позволяет ботам поисковых систем знать, какие страницы сайта следует сканировать, а какие нет. Строго говоря, веб-сайту не нужен robots.txt. Если вы находитесь в процессе создания своего веб-сайта, лучше сначала сосредоточиться на создании качественного контента. Боты поисковых систем будут сканировать вебсайт независимо от того, есть ли у вас robots.txt или нет.

Боты поисковых систем будут сканировать вебсайт независимо от того, есть ли у вас robots.txt или нет.

Однако есть немало преимуществ наличия robots.txt с соответствующими директивами после завершения создания веб-сайта WordPress. Помимо предотвращения сканирования ненужного контента сканерами, оптимизированные директивы robots.txt гарантируют, что ваша квота на сканирование (максимальное количество раз, которое сканер может сканировать сайт в течение определенного времени) не будет потрачена впустую.

Более того, хорошо написанные директивы WordPress robots.txt могут уменьшить негативные последствия плохих ботов, запретив им доступ. Это, в свою очередь, улучшит общую скорость загрузки сайта. Но имейте в виду, что директивы robots.txt не должны быть единственной защитой. Плохие боты часто игнорируют их, поэтому настоятельно рекомендуется использовать хороший плагин безопасности, особенно если на веб-сайте возникают проблемы, вызванные плохими ботами.

Наконец, распространено заблуждение, что robots. txt предотвратит индексацию некоторых страниц веб-сайта. Файл robots.txt может содержать директивы, запрещающие сканирование, но не индексирование. И даже если страница не просканирована, ее все равно можно проиндексировать с помощью внешних ссылок, ведущих на нее. Если вы хотите избежать индексации определенной страницы, следует использовать метатег noindex вместо директив в robots.txt для WordPress.

txt предотвратит индексацию некоторых страниц веб-сайта. Файл robots.txt может содержать директивы, запрещающие сканирование, но не индексирование. И даже если страница не просканирована, ее все равно можно проиндексировать с помощью внешних ссылок, ведущих на нее. Если вы хотите избежать индексации определенной страницы, следует использовать метатег noindex вместо директив в robots.txt для WordPress.

Как использовать «robots.txt»

Уяснив, что такое robots.txt в WordPress и что он делает, рассмотрим, как он используется. Из этого раздела вы узнаете, как создать и отредактировать robots.txt, некоторые передовые практики в отношении его содержания и как проверить его на наличие ошибок.

По умолчанию WordPress создает виртуальный robots.txt для любого веб-сайта. Он может выглядеть примерно так:

Смотрите также:

Как закрыть сайт от индексации и что это означает

Но если вы захотите его отредактировать, нужно создать настоящий robots. txt. Ниже описаны три способа, как это сделать. Два из них предполагают использование плагинов WordPress, а третий полагается на использование FTP.

txt. Ниже описаны три способа, как это сделать. Два из них предполагают использование плагинов WordPress, а третий полагается на использование FTP.

Yoast SEO

Плагин Yoast SEO – один из самых популярных доступных плагинов для SEO с более чем 5 миллионами активных установок. Он включает множество инструментов для оптимизации сайта, в том числе функцию для создания и редактирования robots.txt для WordPress.

После установки плагина, нажмите на вновь созданный SEO раздел, а затем кликните на подраздел Инструменты. На открывшейся странице щелкните ссылку Редактор файлов вверху.

На следующей странице найдите раздел robots.txt. Оттуда, если не создали файл раньше, следует нажать кнопку Создать robots.txt.

Это действие создаст файл, и теперь можно увидеть его содержимое в текстовой области. Используя ту же текстовую область, можно редактировать содержание нового robots.txt. Закончив редактирование, нажмите кнопку Сохранить изменения в robots. txt ниже.

txt ниже.

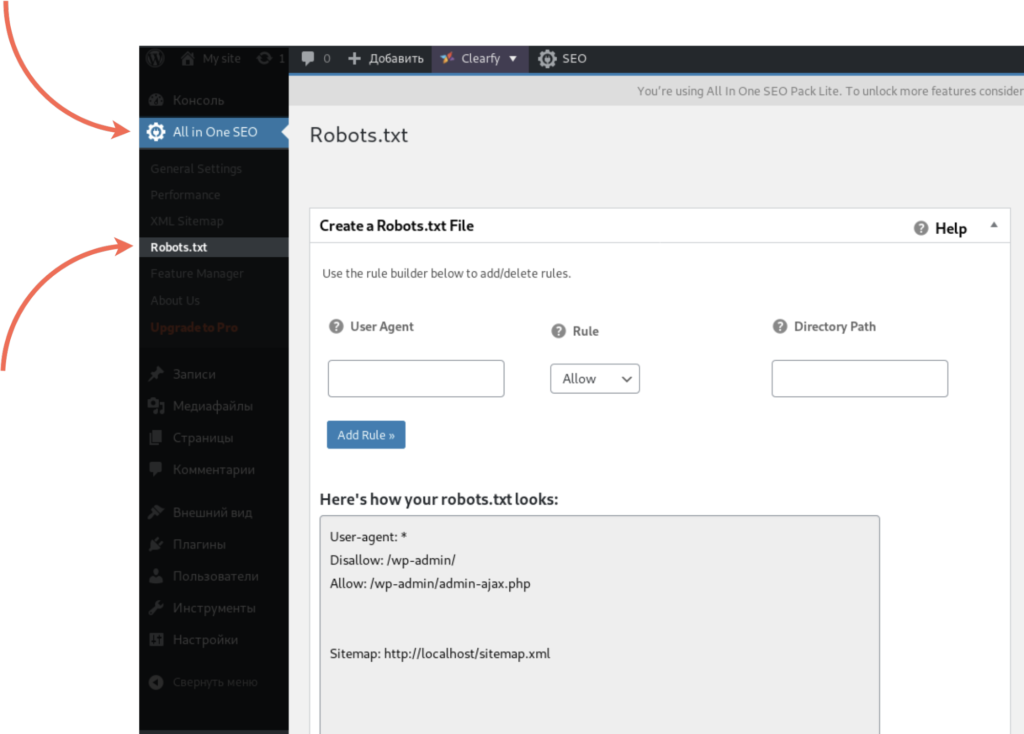

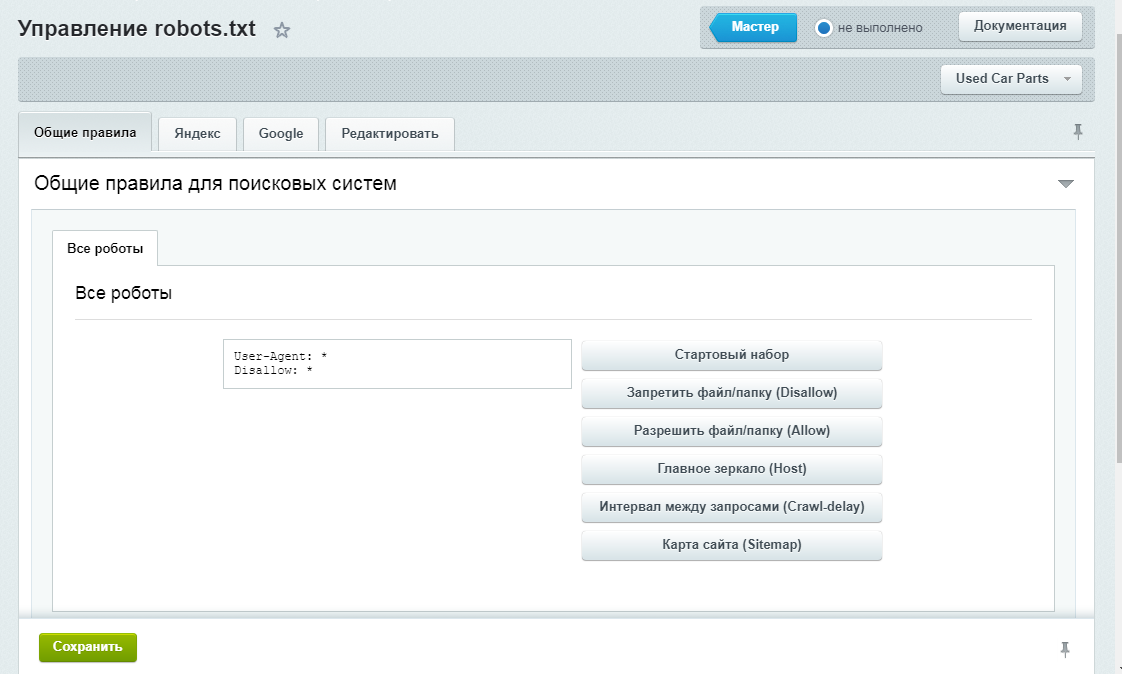

All in one SEO

All in one SEO – еще один очень популярный плагин SEO, который поставляется с различными бесплатными функциями, в том числе возможностью создавать и редактировать robots.txt для WordPress.

После установки плагина нажмите новый раздел All in One SEO в меню панели инструментов, а затем кликните на опцию Feature Manager. На странице Feature Manager найдите функцию Robots.txt и нажмите кнопку Активировать.

Файл robots.txt создан. После этого появится сообщение об успешном выполнении, в котором говорится, что параметры обновлены. И появится новый подраздел под названием Robots.txt.

Нажав на опцию Robots.txt, откроется новый раздел. Там вы сможете добавить новые правила в robots.txt, а также посмотреть, как он выглядит в настоящее время.

Помимо использования плагина WordPress, можно создать robots.txt вручную. Сначала создайте на своем компьютере пустой файл типа . txt и сохраните его как robots.txt.

txt и сохраните его как robots.txt.

Затем подключитесь к серверу, используя свои учетные данные FTP. Затем в правом разделе перейдите в корневой каталог WordPress, который часто называется public_html. В левой части вашего FTP-клиента (в примере используем Filezilla) найдите robots.txt, который вы ранее создали и сохранили на своем компьютере. Щелкните на него правой кнопкой мыши и выберите Загрузить вариант.

Через несколько секунд файл будет загружен, и его можно увидеть среди других в корневом каталоге WordPress.

Если вы хотите впоследствии отредактировать загруженный robots.txt, найдите его в корневом каталоге WordPress, щелкните по нему правой кнопкой мыши и выберите параметр «Просмотр / редактирование».

Добавление правил в robots.txt

Теперь, когда вы знаете, как создавать и редактировать robots.txt, можем подробнее поговорить о правилах, которые может содержать этот файл. В robots.txt чаще всего присутствуют две директивы: User-agent и Disallow.

Правило User-agent указывает, к какому боту применяются директивы, перечисленные под User-agent. Вы можете указать одного бота (например, User-agent: Bingbot) или применить директивы ко всем ботам, поставив звездочку (User-agent: *).

Правило Disallow запрещает боту доступ к определенной части сайта. А еще есть правило Allow, которое делает прямо противоположное. Ее не нужно использовать так часто, как Disallow, потому что ботам по умолчанию предоставляется доступ к сайту. Allow обычно используется в сочетании с директивой Disallow. Точнее, она служит для разрешения доступа к файлу или подпапке, принадлежащей запрещенной папке.

Кроме того, есть еще две директивы: Crawl-delay и Sitemap.

Правило Crawl-delay используется для предотвращения перегрузки сервера из-за чрезмерных запросов сканирования. Однако эту директиву следует использовать с осторожностью, поскольку она не поддерживается некоторыми сканерами (например, Googlebot) и по-разному интерпретируется поисковыми роботами, которые ее поддерживают (например, BingBot).

Правило Sitemap указывает поисковым системам на ваш XML-файл карты сайта. Настоятельно рекомендуем использовать эту директиву, так как она поможет с отправкой созданной вами XML-карты сайта в Google Search Console или Bing Webmaster Tools. Но имейте в виду, что при использовании этой директивы нужно использовать абсолютный URL-адрес для ссылки на свою карту сайта (например, Sitemap: https://www.example.com/sitemap_index.xml).

Примеры фрагментов robots.txt

Ниже рассмотрим два примера фрагментов, иллюстрирующие использование директив robots.txt, упомянутых выше. Однако это только примеры; в зависимости от вашего веб-сайта может потребоваться другой набор правил. С учетом сказанного, давайте взглянем на фрагменты.

- Этот фрагмент примера запрещает доступ ко всему каталогу / wp-admin / для всех ботов, за исключением файла /wp-admin/admin-ajax.php, находящегося внутри.

User-agent: *

Disallow: / wp-admin /

Allow: /wp-admin/admin-ajax.php

- Этот фрагмент обеспечивает доступ к папке / wp-content / uploads / для всех ботов.

При этом запрещает доступ к папке / wp-content / plugins /, / wp-admin / и / refer /, а также к файлу /readme.html для всех ботов. В приведенном ниже примере показан правильный способ написания нескольких правил; независимо от того, относятся они к одному или к разным типам, обязательно указывайте по одному в каждой строке. Кроме того, этот пример фрагмента позволяет ссылаться на файл карты сайта, указав его абсолютный URL. Если решите использовать его, не забудьте заменить часть www.example.com фактическим URL-адресом вашего веб-сайта.

При этом запрещает доступ к папке / wp-content / plugins /, / wp-admin / и / refer /, а также к файлу /readme.html для всех ботов. В приведенном ниже примере показан правильный способ написания нескольких правил; независимо от того, относятся они к одному или к разным типам, обязательно указывайте по одному в каждой строке. Кроме того, этот пример фрагмента позволяет ссылаться на файл карты сайта, указав его абсолютный URL. Если решите использовать его, не забудьте заменить часть www.example.com фактическим URL-адресом вашего веб-сайта.

User-agent: *

Allow: / wp-content / uploads /

Disallow: / wp-admin /

Disallow: /readme.html

Disallow: / refer /

Sitemap: https://www.example.com/sitemap_index.xml

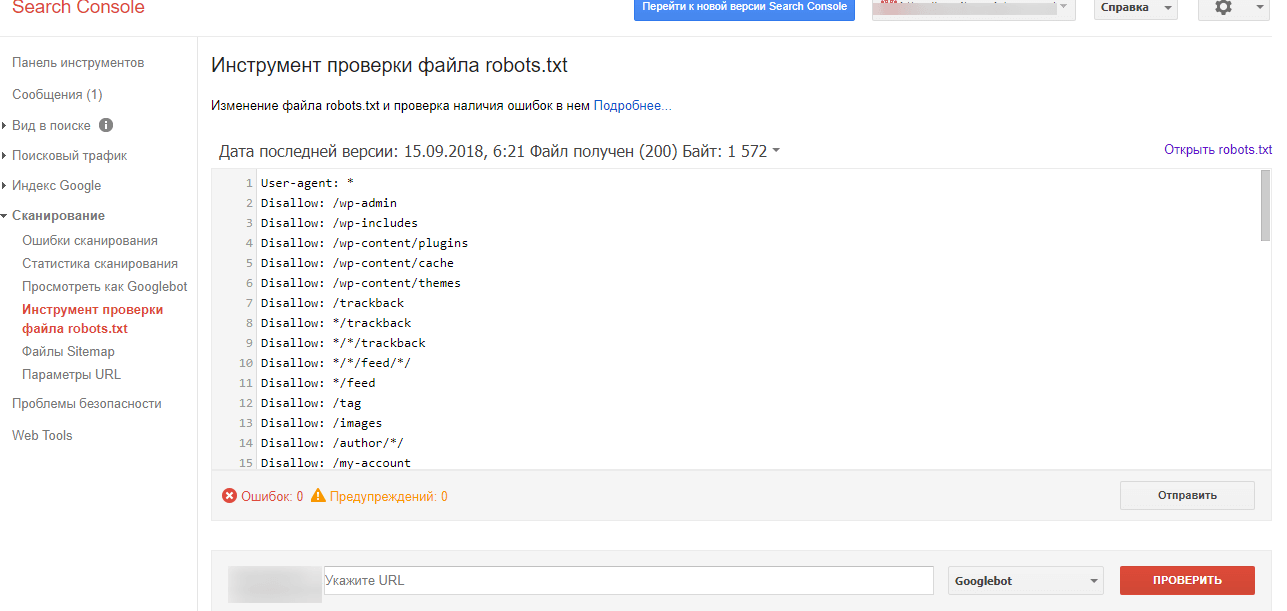

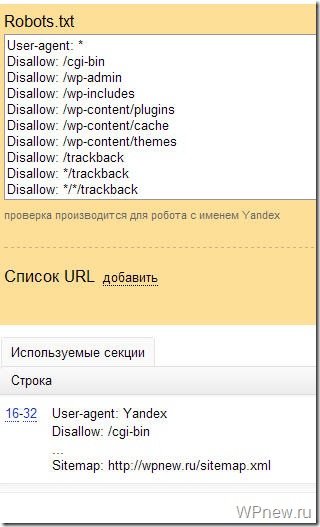

Тестирование «robots.txt»

После добавления директив, соответствующих требованиям вашего веб-сайта, вам следует протестировать robots.txt WordPress. Таким образом, вы одновременно проверяете, что в файле нет никаких синтаксических ошибок, и убедитесь, что соответствующие области вашего веб-сайта были правильно разрешены или запрещены.

Чтобы протестировать robots.txt своего веб-сайта, перейдите на веб-сайт, посвященный SEO-тестированию. Затем вставьте любой URL вашего сайта (URL домашней страницы, например), выберите User-agent (Googlebot, например), и нажмите кнопку Test.

Если URL-адрес доступен для сканирования, то увидите зеленый результат с надписью Разрешено. В противном случае будет отображаться сообщение «Запрещено». Чтобы подтвердить правильность директив сканирования на своем веб-сайте, можете повторить тот же процесс для любого количества разных URL-адресов.

robots.txt – это текстовый файл, расположенный в корневом каталоге каждого сайта WordPress. Он содержит директивы для поисковых роботов, сообщающие им, какие части веб-сайта следует сканировать, а какие нет. Хотя этот файл по умолчанию является виртуальным, знание того, как создать его самостоятельно, будет полезным для поисковой оптимизации.

Поэтому мы рассмотрели различные способы создания физической версии и поделились инструкциями по ее редактированию, коснулись основных директив, которые должен содержать robots. txt WordPress, и того, как проверить правильность их установки.

txt WordPress, и того, как проверить правильность их установки.

Источник: qodeinteractive.com

Смотрите также:

Изучает сайтостроение с 2008 года. Практикующий вебмастер, специализирующий на создание сайтов на WordPress. Задать вопрос Алексею можно на https://profiles.wordpress.org/wpthemeus/

Как создать правильный Robots txt для WordPress

Чтобы помочь поисковым системам правильно индексировать ваш блог, нужно сделать правильный файл Robots txt для WordPress. Посмотрим как его создать и чем наполнить.

Что дает Robots.txt?

Он нужен для поисковых систем, для правильной индексации ими веб-ресурса. Содержимое файла “говорит” поисковому роботу, какие страницы нужно показывать в поиске, а какие скрыть. Это позволяет управлять контентом в поисковой выдаче.

Например, при запросе в Гугле “купить холодильник” конечному покупателю незачем попадать на страницу администрирования магазина. Ему важно перейти сразу в раздел “Холодильники”.

Наполнять robots.

txt нужно уже на этапе разработки сайта. Его изменения вступают в силу не сразу. Может пройти неделя или несколько месяцев.

Где находится Robots?

Этот обычный тестовый файл лежит в корневом каталоге сайта. Его можно получить по адресу

https://site.ru/robots.txt

Движок изначально Роботс не создает. Это нужно делать вручную или пользоваться инструментами, которые создают его автоматически.

Не могу найти этот файл

Если по указанному адресу содержимое файл отображается, но на сервере его нет, то значит он создан виртуально. Поисковику все равно. Главное, чтобы он был доступен.

Из чего состоит

Из 4 основных директив:

- User-agent — правила поисковым роботам.

- Disalow — запрещает доступ.

- Allow — разрешает.

- Sitemap — полный URL-адрес карты XML.

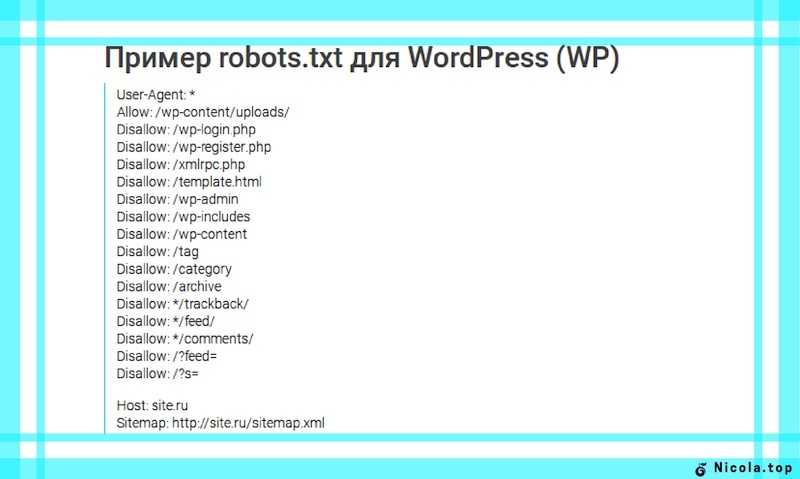

Правильный robots.txt для ВордПресс

Вариантов много. Инструкции на каждом сайте отличаются.

Вот пример корректного robots. txt, в котором учтены все разделы сайта. Коротко разберем директивы.

txt, в котором учтены все разделы сайта. Коротко разберем директивы.

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-content/cache

Disallow: /wp-json/

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /xmlrpc.php

Disallow: /license.txt

Disallow: /readme.html

Disallow: /trackback/

Disallow: /comments/feed/

Disallow: /*?replytocom

Disallow: */feed

Disallow: */rss

Disallow: /author/

Disallow: /?

Disallow: /*?

Disallow: /?s=

Disallow: *&s=

Disallow: /search

Disallow: *?attachment_id=

Allow: /*.css

Allow: /*.js

Allow: /wp-content/uploads/

Allow: /wp-content/themes/

Allow: /wp-content/plugins/

Sitemap: https://site.ru/sitemap_index.xml

В первой строке указывается, что ресурс доступен для всех поисковых роботов (краулеров).

Allow разрешают добавлять в индекс скрипты, стили, файлы загрузок, тем и плагинов.

Последняя – это адрес XML-карты.

Как создать robots.txt для сайта

Рассмотрим несколько методов: вручную и с помощью WordPress-плагинов.

Вручную

Это можно сделать например, в Блокноте (если локальный сервер) или через FTP-клиент (на хостинге).

Вручную добавить robots.txt на сайт проще всего по FTP. Для этого необходимо создать сам файл в текстовом формате. Затем, воспользовавшись одним из FTP-клиентов (например, FileZilla), загрузить robots.txt в корневую папку сайта (рядом с файлами wp-config.php, wp-settings.php).

После успешной загрузки robots.txt, перейдите по адресу

https://ваш_сайт.ru/robots.txt, чтобы посмотреть актуальное состояние файла.С помощью плагинов

Для облегчения создания robots.txt в WordPress существуют специальные плагины. Некоторые из них: WordPress Robots.txt File, DL Robots.txt, Yoast SEO, All in One SEO Pack.

Clearfy Pro

Clearfy Pro создает виртуальный файл. Для этого:

Для этого:

- Перейдите в админ-меню Clearfy Pro.

- На вкладке SEO задействуйте опцию Создать правильный robots.txt.

- Он создастся автоматически. При желании отредактируйте в поле здесь же.

- Сохраните изменения.

Всегда можно отредактировать содержимое Robots. Просто измените/дополните его нужным содержимым и сохраните изменения.

Активировать промокод на 15%

Yoast SEO

Рассмотрим создание файла robots.txt на примере одного из самых мощных SEO-плагинов Yoast SEO.

Этот мощный СЕО-модуль для WP также решит задачу.

- Перейдите SEO > Инструменты.

- Нажмите Редактор файлов.

- Если в корневом каталоге этого файла нет, кликните Создать файл robots.txt. В редакторе вставьте вышеописанный код и нажмите Сохранить изменения в robots.txt.

Если есть, то откроется редактор для внесения изменений.

- Нажмите Сохранить изменения в robots.txt.

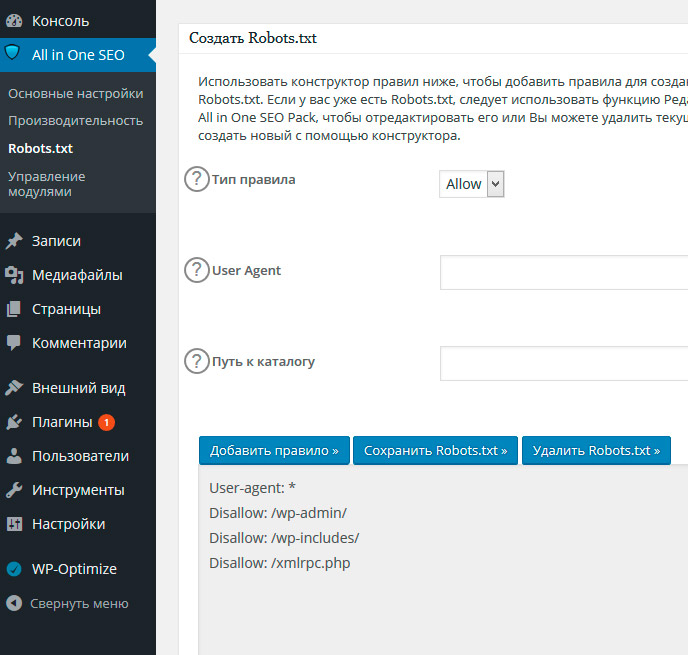

All in One SEO Pack

Это решение тоже “умеет” работать с Robots. Для этого:

- Откройте All in One SEO > Модули.

- Выберите одноименное название модуля и нажмите Activate.

- Перейдите All in One SEO > Robots.txt.

- В полях добавьте директивы.

Настройка для интернет-магазинов (WooCommerce)

Для WordPress-ресурсов с использованием этого расширения просто добавьте эти правила:

Disallow: /cart/ Disallow: /checkout/ Disallow: /*add-to-cart=* Disallow: /my-account/

Нажмите, пожалуйста, на одну из кнопок, чтобы узнать понравилась статья или нет.

Как оптимизировать файл WordPress Robots.txt для улучшения SEO

Контент Themeisle бесплатный. Когда вы покупаете по реферальным ссылкам на нашем сайте, мы получаем комиссию. Узнать больше

Если вам интересно, как оптимизировать файл WordPress robots. txt для улучшения SEO, вы пришли в нужное место.

txt для улучшения SEO, вы пришли в нужное место.

В этом кратком руководстве я объясню, что такое файл robots.txt, почему он важен для улучшения вашего поискового рейтинга и как вносить в него изменения и отправлять в Google.

Давайте погрузимся!

Что такое файл robots.txt WordPress и нужно ли мне беспокоиться об этом?

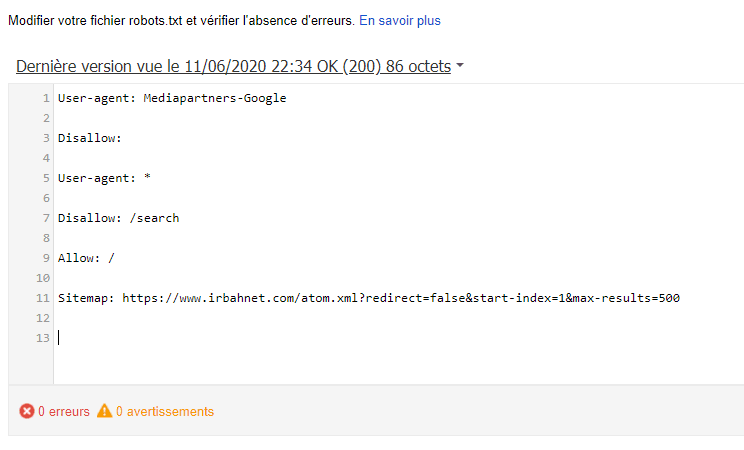

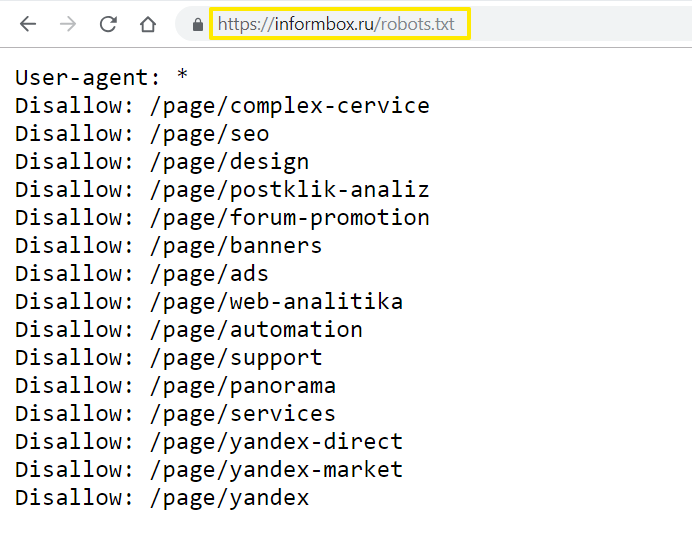

Файл robots.txt — это файл на вашем сайте, который позволяет запретить поисковым системам доступ к определенным файлам и папкам. Вы можете использовать его, чтобы заблокировать роботов Google (и других поисковых систем) от сканирования определенных страниц вашего сайта. Вот пример файла:

Так как же отказ в доступе к поисковым системам на самом деле улучшает вашу поисковую оптимизацию? Кажется нелогичным…

Это работает следующим образом: чем больше страниц на вашем сайте, тем больше страниц должен просканировать Google.

Например, если в вашем блоге много страниц категорий и тегов, эти страницы некачественные и не нуждаются в сканировании поисковыми системами; они просто потребляют краулинговый бюджет вашего сайта (количество страниц, которые Google будет сканировать на вашем сайте в любой момент времени).

Бюджет сканирования важен, потому что он определяет, насколько быстро Google улавливает изменения на вашем сайте и, следовательно, как быстро ваш рейтинг. Это может особенно помочь с SEO электронной коммерции!

Просто будьте осторожны, чтобы сделать это правильно, так как это может повредить вашему SEO, если все сделано плохо. Для получения дополнительной информации о том, как правильно не индексировать нужные страницы, ознакомьтесь с этим руководством от DeepCrawl.

Итак, вам нужно возиться с файлом robots.txt WordPress?

Возможно, если вы находитесь в высококонкурентной нише с большим сайтом. Однако, если вы только начинаете свой первый блог, создание ссылок на ваш контент и создание большого количества высококачественных статей являются более важными приоритетами.

Как оптимизировать файл WordPress robots.txt для улучшения SEO

Теперь давайте обсудим, как на самом деле получить (или создать) и оптимизировать файл WordPress robots. txt.

txt.

Robots.txt обычно находится в корневой папке вашего сайта. Вам нужно будет подключиться к своему сайту с помощью FTP-клиента или с помощью файлового менеджера cPanel, чтобы просмотреть его. Это обычный текстовый файл, который затем можно открыть в блокноте.

Если у вас нет файла robots.txt в корневом каталоге вашего сайта, вы можете создать его. Все, что вам нужно сделать, это создать новый текстовый файл на вашем компьютере и сохранить его как robots.txt. Затем просто загрузите его в корневую папку вашего сайта.

Как выглядит идеальный файл robots.txt?

Формат файла robots.txt очень прост. Первая строка обычно называет пользовательский агент. Пользовательский агент — это имя поискового бота, с которым вы пытаетесь связаться. Например, Googlebot или Bingbot . Вы можете использовать звездочку * , чтобы проинструктировать всех ботов.

Следующая строка содержит инструкции Разрешить или Запретить для поисковых систем, чтобы они знали, какие части вы хотите, чтобы они индексировали, а какие — нет.

Вот пример:

Агент пользователя: * Разрешить: /?display=широкий Разрешить: /wp-content/uploads/ Запретить: /readme.html Запретить: /см./ Карта сайта: http://www.codeinwp.com/post-sitemap.xml Карта сайта: http://www.codeinwp.com/page-sitemap.xml Карта сайта: http://www.codeinwp.com/deals-sitemap.xml Карта сайта: http://www.codeinwp.com/hosting-sitemap.xml

Обратите внимание: если вы используете такой плагин, как Yoast или All in One SEO, вам может не понадобиться добавлять раздел карты сайта, поскольку они пытаются сделать это автоматически. Если это не удается, вы можете добавить его вручную, как в примере выше.

Что я должен запретить или noindex?

В руководстве Google для веб-мастеров веб-мастерам рекомендуется не использовать файл robots.txt для сокрытия некачественного контента. Таким образом, использование файла robots.txt для запрета Google индексировать вашу категорию, дату и другие страницы архива может быть неразумным решением.

Помните, что файл robots.txt предназначен для указания ботам, что делать с контентом, который они сканируют на вашем сайте. Это не мешает им сканировать ваш сайт.

Кроме того, вам не нужно добавлять страницу входа в WordPress, каталог администратора или страницу регистрации в файл robots.txt, поскольку страницы входа и регистрации имеют тег noindex, автоматически добавленный WordPress.

Однако я рекомендую вам запретить файл readme.html в файле robots.txt. Этот файл readme может быть использован кем-то, кто пытается выяснить, какую версию WordPress вы используете. Если это человек, он может легко получить доступ к файлу, просто просмотрев его. Кроме того, размещение тега Disallow может блокировать вредоносные атаки.

Как отправить файл WordPress robots.txt в Google?

После того как вы обновили или создали файл robots.txt, вы можете отправить его в Google с помощью Google Search Console.

Тем не менее, я рекомендую сначала протестировать его с помощью инструмента тестирования robots. txt от Google.

txt от Google.

Если вы не видите созданную вами версию здесь, вам придется повторно загрузить файл robots.txt, который вы создали, на свой сайт WordPress. Вы можете сделать это с помощью Yoast SEO.

Вывод

Теперь вы знаете, как оптимизировать файл WordPress robots.txt для улучшения SEO.

Будьте осторожны при внесении каких-либо серьезных изменений на свой сайт с помощью файла robots.txt. Хотя эти изменения могут улучшить ваш поисковый трафик, они также могут принести больше вреда, чем пользы, если вы не будете осторожны.

А если вам не терпится узнать больше, ознакомьтесь с нашим последним обзором руководств по WordPress!

Дайте нам знать в комментариях; У вас есть вопросы о том, как оптимизировать файл robots.txt WordPress? Какое влияние оказала забота об этом на ваш поисковый рейтинг?

Бесплатная направляющая

5 основных советов по ускорению

вашего сайта WordPress

Сократите время загрузки даже на 50-80%

просто следуя простым советам.

Как получить доступ и изменить Robots.txt в WordPress (Руководство)

Обновлено: 10 августа 2022 г.

В этом кратком руководстве я покажу вам, как создавать, получать доступ и изменять robots. txt в WordPress четырьмя простыми способами.

Если вы серьезно относитесь к своему веб-сайту (и особенно если у вас большой веб-сайт), вам обязательно нужно контролировать его файл robots.txt. К счастью, с веб-сайтами WordPress это довольно легко сделать.

Позвольте мне показать вам 4 простых способа доступа и изменения файла robots.txt в WordPress.

Основная информация о файле robots.txt

4 способа получить доступ к robots.txt в WordPress

#1: Используйте SEO-плагин

#2: Используйте специальный плагин robots.txt

#3: Доступ к robots.txt через cPanel на вашем хостинге

#4: Используйте FTP для доступа к robots. txt

txt

Как протестировать файл robots.txt на вашем сайте

Основная информация о файле robots.txt

Robots.txt — это файл, информирующий роботов поисковых систем о страницах или файлах, которые следует или не следует сканировать.

- Файл robots.txt предназначен для защиты веб-сайта от перегрузки запросами поисковых роботов (см. мое полное руководство по оптимизации краулингового бюджета ).

- 9Файл 0063 robots.txt не является способом заблокировать веб-страницы или файлы от индексации и появления в результатах поиска. Вот напоминание от Google:

- Сканеры поисковых систем всегда начинают сканирование вашего сайта с проверки директив в robots.txt .

- Поисковые системы должны, но не всегда, соблюдать директивы, содержащиеся в robots.txt (Google делает).

- Большинство сканеров веб-сайтов позволяют настроить их так, чтобы они либо игнорировали, либо учитывали файл robots.

txt.

txt.

Если вам нужно небольшое напоминание, вот некоторая основная техническая информация о robots.txt :

- Единственным правильным расположением robots.txt является корень (основной каталог) веб-сайта. Это относится к любому веб-сайту, независимо от того, является ли он веб-сайтом WordPress.

- Один веб-сайт (один домен) может иметь только один файл robots.txt .

- Единственным приемлемым именем файла является robots.txt .

- Robots.txt должен быть текстовым файлом в кодировке UTF-8.

Имея это в виду, расположение robots.txt в WordPress такое же, как и для любого другого веб-сайта. Это корень сайта.

В случае моего веб-сайта это https://seosly.com/robots.txt.

Так выглядит файл robots.txt WordPress по умолчанию.Имейте в виду, что:

- Если у вас есть веб-сайт, доступный на разных языках, и определенные языки помещаются в разные папки, например.

seosly.com/pl/ , тогда у вас будет один файл robots.txt для всех языковых версий.

seosly.com/pl/ , тогда у вас будет один файл robots.txt для всех языковых версий. - Если у вас есть разные поддомены или разные домены для разных языковых версий, например seosly.pl , то для каждой языковой версии будет свой файл robots.txt.

Преимущество WordPress в том, что он позволяет вам получить доступ к вашему robots.txt несколькими различными способами, даже если у вас нет FTP-доступа.

☝️ Если вы хотите узнать больше о файле robots.txt, о том, как он работает и что это такое, обязательно ознакомьтесь с введение в robots.txt в Google Search Central.

4 способа получить доступ к файлу robots.txt в WordPress

А вот четыре способа доступа и изменения файла robots.txt на вашем сайте WordPress

#1: Используйте плагин SEO

Существует множество плагинов SEO для WordPress но фактически только два действительно учитываются:

- Rank Math

- Yoast SEO

Существует также All in One SEO , но я не большой поклонник этого плагина. Все эти SEO-плагины позволяют легко получать доступ к файлу robots.txt и изменять его.

Все эти SEO-плагины позволяют легко получать доступ к файлу robots.txt и изменять его.

Доступ к robots.txt с помощью Rank Math

Если вы используете Rank Math, вот что вам нужно сделать:

- Войдите в панель управления WordPress как администратор. Обратите внимание, что только администраторы могут изменять плагины.

- Перейти к Rank Math SEO .

- На левой боковой панели под Rank Math вы увидите различные настройки Rank Math. Нажмите Общие настройки с.

- Теперь вы увидите список общих настроек SEO. Нажмите Изменить robots.txt .

- Если вы ничего не сделаете, Rank Math автоматически обработает robots.txt, как показано на скриншоте ниже.

- Если вы хотите изменить robots.txt, просто начните вводить текст в текстовое поле и нажмите Сохранить изменения .

- Если вы не уверены, что вставить в robots.

txt или делаете что-то не так, просто нажмите Параметры сброса .

txt или делаете что-то не так, просто нажмите Параметры сброса .

Вот и все для Rank Math и robots.txt.

Доступ к robots.txt с помощью Yoast SEO

Вот что нужно делать, если вы используете Yoast SEO:

- Войдите в панель управления WordPress как администратор. Помните, что только администраторы могут изменять настройки плагина.

- Перейдите к SEO .

- На левой боковой панели вы увидите пару настроек под SEO . Нажмите на Инструменты .

- Щелкните Редактор файлов.

- Теперь вы можете изменить файл robots.txt.

- Когда вы закончите, просто нажмите Сохранить изменения в robots.txt.

Для большинства веб-сайтов WordPress подойдут эти два метода с использованием этих двух плагинов SEO. Но есть и другие способы.

#2: Используйте специальный плагин robots.txt

Существует также множество различных плагинов WordPress, созданных специально для того, чтобы вы могли редактировать robots. txt.

txt.

Вот наиболее популярные плагины robots.txt WordPress, которые вы можете проверить:

- Виртуальные роботы. TXT

- WordPress Robots.txt Optimization

- ROBOTS.TXT

- One Robots.txt

- One Robots.txt

- One.txt editor

- One.txt editor

- One. позволяет легко получать доступ к файлу robots.txt и изменять его. Ниже приведены быстрые шаги, которые необходимо предпринять для доступа к файлу robots.txt с помощью этих 3 плагинов WordPress.

❗ Обратите внимание, что некоторые плагины создают файл robots.txt, который помещается в корень вашего сайта, а другие создают его динамически. Если robots.txt создается динамически, то вы не найдете его в корневом каталоге вашего сайта (например, через FTP).

❗ Не используйте одновременно несколько плагинов robots.

txt!

txt!Virtual Robots.txt

Вот как использовать плагин Virtual Robots.txt:

- Установите и активируйте Virtual Robots.txt .

- В панели инструментов WordPress перейдите к Настройки , а затем Virtual Robots.txt .

- Теперь вы можете просматривать файл robots.txt и изменять его. Когда закончите, нажмите Сохранить изменения .

Вот оно!

Better Robots.txt

Этот плагин robots.txt немного отличается от плагинов, которые я показал вам выше. С Better Robots.txt вы не изменяете текстовый файл, а просто настраиваете параметры на удобной панели внутри WordPress.

Вот что нужно:

- Установить и активировать Better Robots.txt. Плагин также называется Оптимизация WordPress Robots.txt.

- Предоставьте плагину необходимые разрешения.

- Перейдите к Better Robots.

txt . Плагин будет доступен на левой боковой панели.

txt . Плагин будет доступен на левой боковой панели.

- Теперь вы увидите множество полезных и удобных настроек.

- Плагин также позволяет вручную разрешать или запрещать определенные поисковые роботы.

- Вы также можете изменить некоторые настройки, чтобы защитить свои данные или оптимизировать скорость загрузки.

- Есть и другие интересные настройки, которые предлагает плагин. Я рекомендую проверить тех.

Better Robots.txt позволяет создать полностью настраиваемый файл robots.txt, не касаясь ни строчки кода.

Редактор Robots.txt

Вот как использовать редактор Robots.txt:

- Установите и активируйте Редактор Robots.txt .

- Перейдите к Плагины > Установленные плагины на панели инструментов WordPress. Вы также можете получить доступ к файлу robots.txt, выбрав «Настройки» > 9.0049 Чтение .

- Нажмите Настройки под Robots.txt Редактор.

- Теперь у вас есть доступ к файлу robots.txt и его редактирование. Когда вы закончите, нажмите Сохранить изменения .

❗ Будьте осторожны и избегайте одновременного использования нескольких редакторов robots.txt. Это действительно может все испортить. Если вы используете SEO-плагин, вам следует использовать только его редактор robots.txt.

#3. Доступ к файлу robots.txt через cPanel на вашем хостинге

Здесь я покажу вам, как загрузить robots.txt в WordPress без доступа по FTP.

Вы также можете использовать cPanel вашего хостинга для создания или изменения файла robots.txt.

Обратите внимание, что некоторые плагины, показанные выше, динамически создают файл robots.txt. Это означает, что вы не сможете найти файл в корневом каталоге вашего сайта.

❗ Если вы используете плагин для создания robots.

txt и управления им, вам не следует пытаться вручную добавить новый robots.txt с помощью cPanel или FTP (ниже).

txt и управления им, вам не следует пытаться вручную добавить новый robots.txt с помощью cPanel или FTP (ниже). Однако, если вы не полагаетесь на эти плагины, вы можете вручную создать и обновить файл robots.txt на своем веб-сайте WordPress.

Вот как это сделать с помощью Bluehost:

- Войдите в cPanel на вашем хостинге.

- Развернуть секцию Дополнительно .

- Нажмите Диспетчер файлов .

- Перейдите в корневой каталог вашего веб-сайта.

- Если вы не используете подключаемый модуль, динамически генерирующий robots.txt, вы должны увидеть файл robots.txt в корне.

- Щелкните файл robots.txt и выберите Изменить .

- Теперь вы можете редактировать содержимое файла robots.txt. Когда закончите, нажмите Сохранить изменение с.

Если на вашем сайте нет файла robots.txt, вам необходимо создать и загрузить его.

Вот что нужно сделать:

- Откройте редактор текстовых файлов, например Notepad или Notepad++.

- Создайте файл robots.txt.

- Загрузите файл в основной каталог вашего сайта. В случае Bluehost вы просто нажимаете Загрузить в файловом менеджере. Просто убедитесь, что вы находитесь в корне.

Этот метод будет работать как для веб-сайтов WordPress, так и для веб-сайтов, отличных от WordPress.

#4: Используйте FTP для доступа к robots.txt

Здесь я покажу вам, как получить доступ к robots.txt через FTP.

Самый быстрый и самый «профессиональный» способ получить доступ к robots.txt — использовать FTP. Этот метод также работает для любого типа веб-сайтов, включая сайты WordPress.

❗ Я не рекомендую этот метод, если вы используете плагин для автоматического создания robots.txt для вас.

Этот метод аналогичен тому, что вы делаете с помощью cPanel на своем хостинге, за исключением того, что на этот раз вы используете FTP-клиент для доступа к своему веб-сайту.

Чтобы использовать этот метод, вам потребуется имя пользователя и пароль FTP, а также FTP-клиент, например Filezilla .

Вот что вам нужно сделать:

- Подключитесь к вашему сайту через FTP-клиент.

- Перейдите в корневой каталог вашего веб-сайта, если вы еще этого не сделали.

- Загрузите файл robots.txt, если он есть.

- Откройте файл robots.txt в текстовом редакторе, например Notepad++.

- При необходимости измените файл. Сохранить изменения.

- Загрузите файл в корневой каталог. Это перезапишет существующий файл robots.txt.

Если на вашем веб-сайте нет файла robots.txt, вы также можете создать и загрузить его.

Как проверить файл robots.txt на вашем веб-сайте

Если вы внесли некоторые изменения в robots.txt, я настоятельно рекомендую вам протестировать файл robots.txt, чтобы убедиться, что файл правильный и действительно выполняет свои функции.

При этом запрещает доступ к папке / wp-content / plugins /, / wp-admin / и / refer /, а также к файлу /readme.html для всех ботов. В приведенном ниже примере показан правильный способ написания нескольких правил; независимо от того, относятся они к одному или к разным типам, обязательно указывайте по одному в каждой строке. Кроме того, этот пример фрагмента позволяет ссылаться на файл карты сайта, указав его абсолютный URL. Если решите использовать его, не забудьте заменить часть www.example.com фактическим URL-адресом вашего веб-сайта.

При этом запрещает доступ к папке / wp-content / plugins /, / wp-admin / и / refer /, а также к файлу /readme.html для всех ботов. В приведенном ниже примере показан правильный способ написания нескольких правил; независимо от того, относятся они к одному или к разным типам, обязательно указывайте по одному в каждой строке. Кроме того, этот пример фрагмента позволяет ссылаться на файл карты сайта, указав его абсолютный URL. Если решите использовать его, не забудьте заменить часть www.example.com фактическим URL-адресом вашего веб-сайта.

txt.

txt. seosly.com/pl/ , тогда у вас будет один файл robots.txt для всех языковых версий.

seosly.com/pl/ , тогда у вас будет один файл robots.txt для всех языковых версий. txt или делаете что-то не так, просто нажмите Параметры сброса .

txt или делаете что-то не так, просто нажмите Параметры сброса . txt!

txt! txt . Плагин будет доступен на левой боковой панели.

txt . Плагин будет доступен на левой боковой панели.

txt и управления им, вам не следует пытаться вручную добавить новый robots.txt с помощью cPanel или FTP (ниже).

txt и управления им, вам не следует пытаться вручную добавить новый robots.txt с помощью cPanel или FTP (ниже).