Нужно ли скрывать внешние ссылки на сайте?

В последнее время в рунете все чаще попадаются сайты, где внешние ссылки скрыты от поисковых систем при помощи JavaScript, или еще какими-то хитроумными способами разной степени сложности и заморочности. Даже систему кодирования base64 применяют.

Base64, Карл!!! Это вообще жесть!

Чаще всего используют замену тега a href на какой-нибудь span с куском кода JavaScript, а чтобы пользователь все же видел, что это таки ссылка, добавляют в правила CSS для него cursor: pointer и в title прописывают адрес ссылки. Кто-то применяет для этого же библиотеку jQuery, хотя разницы абсолютно никакой.

Кстати, зачастую такие псевдо-ссылки не работают вовсе. Если вы используете этот метод, то проверьте, все ли ссылки у вас рабочие.

При этом владельцы сайтов наивно полагают, что поисковики не прочитают код JavaScript и не засчитают это ссылкой. Еще в 2014 году Гугл заявил, что поисковые роботы уже умеют прочитывать скрытое содержимое в JavaScript (пруф):

Traditionally, we were only looking at the raw textual content that we’d get in the HTTP response body and didn’t really interpret what a typical browser running JavaScript would see. When pages that have valuable content rendered by JavaScript started showing up, we weren’t able to let searchers know about it, which is a sad outcome for both searchers and webmasters.

In order to solve this problem, we decided to try to understand pages by executing JavaScript. It’s hard to do that at the scale of the current web, but we decided that it’s worth it. We have been gradually improving how we do this for some time. In the past few months, our indexing system has been rendering a substantial number of web pages more like an average user’s browser with JavaScript turned on. Sometimes things don’t go perfectly during rendering, which may negatively impact search results for your site.

Для тех, кто не в ладах с английским, суть приведенной цитаты вот в чем: раньше поисковые боты считывали только «сырой» текст страницы, не заглядывая в содержимое JavaScript. Но порой в этом содержимом заключалась ценная информация. Поэтому со временем роботы научились распознавать и ее тоже.

Обратите внимание на последнюю строку. В ней четко говорится, что пока боты делают это не идеально, и возможны траблы, что весьма негативно скажется на результатах поисковой выдачи. Оно вам таки надо?

Зачем вообще скрывать внешние ссылки?

Многие боятся, что попадут под очередные санкции от любимого поисковика за кучу внешних не релевантных ссылок со страниц сайта. Пример — комментарии на блоге. Если их достаточно много, то страница действительно будет ссылаться на кучу не релевантных сайтов, и это не есть гуд.

Вот тут и придумывают владельцы сайтов всякие извращения, чтобы ссылок как бы не было, но они как бы все равно были. То есть, чтобы посетитель их видел и мог воспользоваться, а боты поисковых систем — нет.

Так в чем проблема то?

Было проверено, распознает ли Гугл текстовую ссылку без <a href именно как ссылку или нет? Оказалось, что таки он может узнать в этом тексте ссылку, но бот по ней не переходит, и никакого веса по ней не передается. Это вам не nofollow, который теперь отдает вес в никуда.

Еще в 2009 Мэтт Каттс говорил об этом же:

Включите титры с переводом на русский, если что-то непонятно. В целом, он говорит, что просто текст url не учитывается как ссылка, иначе вебмастера давно бы этим делом стали злоупотреблять. Думаю, с тех пор мало что изменилось.

Как скрыть внешнюю ссылку?

Зачем в очередной раз выдумывать велосипед? Во все времена вебмастера, если хотели показать ссылку, но только так, чтобы она не работала именно как ссылка, то просто писали ее обычным текстом:

http://www.site.com/

По-моему, лучшего пока ничего не придумали.

Лично у меня на блоге Вебсовет так и сделано в комментариях. Ссылка на сайт комментатора просто написана обычным текстом. Делает это встроенная функция comment_author_url(). И не нужно ничего выдумывать.

Подобный подход, имхо, позволяет поймать сразу двух зайцев:

Во-первых, отсеивает халявщиков. Никому будет не интересно сорить направо и налево своими ссылками, если они не работают как ссылки.

Во-вторых, это заставляет комментаторов оставлять более адекватные и ценные комментарии, а не короткие и ничего не значащие фразы. Если комментатор хочет, чтобы по его текстовой ссылке кто-то перешел, не поленившись скопировать ее и вставить в адресную строку браузера, то он напишет действительно толковый коммент.

Вывод

Прятать ссылки хитрыми способами — глупо! Поисковики рано или поздно накажут и за это. Будьте проще. Используйте обычный текст вместо ссылки, если хотите, чтобы поисковики по ним не переходили.

Автор: Игорь Квентор

www.websovet.com

Как скрыть от поисковых систем часть контента на странице (текст, часть страницы, ссылки)? И зачем?

На некоторых сайтах имеет смысл скрыть часть контента от поисковых систем.Как скрыть часть контента на страницах сайта от роботов поисковых систем?

Для каких целей следует скрывать содержание?

Разберемся с вопросами далее.

Зачем скрывать контент сайта от индексации?

Контент на сайте скрывается от поисковых систем для достижения различных целей.

Если скрыть часть контента от поискового краулера, то алгоритмы ранжирования обработают не всю страницу, а лишь ее часть. В результате поисковый оптимизатор может извлечь выгоду.

Если от поисковых систем часть сайта скрывается, то для пользователей весь контент остается полностью видимым.

Итак, какой контент имеет смысл скрывать и зачем? Например:

- Ссылки для улучшения внутренней перелинковки на сайте. Улучшение достигается за счет оптимизации распределения статического ссылочного веса на сайте;

- Часть текста для повышения релевантности страницы;

- Часть страницы для улучшения ранжирования. Например, скрытие рекламных блоков со страницы, которые находятся в верхней части страницы. Если такие рекламные блоки не скрывать, то поисковая система после рендеринга на так называемом первом экране распознает нерелевантный контент, что не позволит сайту ранжироваться лучше;

- Часть страницы для защиты от санкций поисковых систем.

Есть еще множество различных ситуаций при которых требуется скрывать от поисковых систем часть страницы.

Например, поисковые системы пессимизируют сайты с реферальными ссылками. Такие сайты зарабатывают на партнерских отчислениях. С точки поисковых систем таких как Google подобные сайты не несут никакой дополнительной ценности для пользователя, а значит и не должны находиться среди лидеров поиска.

Если реферальные ссылки скрыть, проблем не будет.

Как скрыть от поисковых систем часть страницы?

На практике скрыть контент сайта от индексации можно используя разные способы.

Наиболее распространенным способом по скрытию текста от поисковых систем является использование подгрузки текста по параметру в хеш-ссылке. Исходя из заявлений Google, протокол HTTP/HTTPS не был разработан для такого использования, поэтому при использовании данного метода индексация не происходит.

Наиболее распространенным способом по скрытию ссылки от поисковых систем является использование контейнера div при создании ссылки.

Но что делать, если речь идет о создании системы для скрытия контента?

Какую технологию использовать? Основные требования следующие:

- У пользователя на экране должен отображаться весь контент страницы сайта;

- Для поисковой системы должен отдаваться не весь контент страницы сайта;

- Способ должен быть условно белым, чтобы сложнее было найти повод для санкций.

В результате оптимальной технологией является та технология, которая официально:

- Не поддерживается движком поисковой системы;

- Поддерживается популярными браузерами.

Ситуация ухудшается тем, что Google обновил поисковый краулер. Теперь Google выполняет скрипты, написанные на современном JavaScript.

Рекомендованный материал в блоге MegaIndex по теме обновления краулера по ссылке далее — Google обновил поисковый краулер. Что изменилось? Как это повлияет на ранжирование?

Все приведенные способы основаны на принципах работы поискового краулера.

Но лазейка все еще есть. В результате обновления стала известна информация о принципах работы поискового краулера, используя которую можно сделать выводы о том, какие именно технологии поисковый робот не поддерживает, а значит не передает в систему ранжирования.

До начала этапа ранжирования происходит ряд процессов.

Весь процесс обработки информации до этапа ранжирования выглядит так:

После рендеринга происходит передача данных в систему ранжирования.

Если после рендеринга часть документа отсутствует, значит данная часть документа не будет участвовать и в ранжировании.

Теперь требуется разобраться с тем, какую технологию пока еще не поддерживает движок рендеринга. Применяя такую технологию на практике можно скрывать часть содержания страниц сайта от поисковой системы.

Итак, скрыть любую часть страницы от поисковой системы можно используя так называемые service workers.

Что такое сервис-воркеры? Сервис-воркеры — это событийный управляемый веб-воркер, регистрируемый на уровне источника и пути. Сервис-воркер может контролировать сайт, с которым ассоциируется, перехватывать и модифицировать запросы навигации и ресурсов.

Да, я вижу ваши лица. Подождите пугаться.

Если упростить, то сервис-воркером является программируемый сетевой проксификатор.

Иными словами, применяя сервис-воркер можно контролировать контент, который передаются пользователю.

В результате применения сервис-воркеров контент может изменяться. Поисковая система же обрабатывает такие корректировки, так как не поддерживает выполнения таких скриптов.

Почему метод эффективен в применении на практике? Сервис-воркеры поддерживаются всеми популярными браузерами и не поддерживаются движком рендеринга поисковой системы Google, через который данные передаются в систему ранжирования.

Следующие браузеры поддерживают сервис-воркеры:

- Chrome;

- Android Chrome;

- Opera;

- Safari;

- iOS Safari;

- Edge;

- Firefox.

Задача поискового оптимизатора заключается в следующем:

- Найти элементы, которые требуется скрыть от поисковой системы;

- Если такие элементы есть, то передать задачу в отдел разработки и оповестить про способы реализации на практике;

- Протестировать работу на примере одного документа путем использования программного решения Chrome Dev Tools или путем анализа кеша страницы в Google после индексации.

Вопросы и ответы

Есть ли официальные заявления о том, что Google действительно не поддерживает сервис-воркеры

Да, такие заявление являются публичными и есть на видео.

Зачем нужны сервис-воркеры?

На сайтах серивс-воркеры используют для разных целей. Например, для адаптации сайта под ситуацию с прерванным доступом к интернету.

Если интернет пропал, то при использовании сервис-воркеров сайты могут вести себя как приложения на мобильных устройствах, то есть отдавать уже скачанный контент и сигнализировать о необходимости подключения.

На практике сервис-воркеры используются еще и для кеширования изображений.

Еще используя сервис-воркеры можно сохранять данные заполненных форм и отправлять их в интернет при появлении подключения. Для реализации используется Background Sync API. Цепь следующая:

Сайт - Index DB - Service Worker - Интернет

Еще сервис-воркеры вместе с Content-Length и Range можно использовать для загрузки больших файлов частями. Например, так можно защищать видео от копирования.

Еще сервис-воркеры используются для отправки push уведомлений.

Кстати, сервис-воркеры продолжают работать даже когда окно браузера закрыто.

Кто использует сервис-воркеры?

Например сервис-воркеры используются на таких сайтах как:

- Google;

- YouTube;

- Twitter;

- Booking;

- Facebook;

- Washington Post;

Как скрыть весь сайт от поисковых систем?

В редких случаях сайты полностью могут быть закрыты от поисковых роботов. Например так защищают площадки от Роскомнадзора при продвижении сайтов различных спортивных тематик. Если стоит задача скрыть всю страницу или весь сайт от конкретных роботов, то наиболее эффективный способ заключается в запрете индексации на уровне сервера. Рекомендованный материал в блоге MegaIndex по теме защиты сайта от парсинга различными роботами по ссылке далее — Эффективные способы защиты от парсинга сайта.

Кстати, краулер MegaIndex индексирует больше ссылок за счет того, что для робота MegaIndex доступ к сайтам не закрыт.

Почему так происходит? Поисковые оптимизаторы используют различные плагины для того, чтобы закрыть ссылки от таких сервисов как SEMrush, Majestic, Ahrefs. В таких плагинах используются черные списки. Если вести речь про глобальный рынок, то MegaIndex является менее расхожим сервисом, и поэтому часто краулер MegaIndex не входит в черный список. Как результат, применяя сервис MegaIndex у поисковых оптимизаторов есть возможность найти те ссылки, которые не находят другие сервисы.

Ссылка на сервис — Внешние ссылки.

Еще выгрузку ссылок можно провести посредством API. Полный список методов доступен по ссылке — MegaIndex API. Метод для выгрузки внешних ссылок называется backlinks. Ссылка на описание метода — метод backlinks.

Пример запроса для сайта indexoid.com:

http://api.megaindex.com/backlinks?key={ключ}&domain=indexoid.com&link_per_domain=1&offset=0Пример запроса для сайта smmnews.com:

http://api.megaindex.com/backlinks?key={ключ}&domain=smmnews.com&link_per_domain=1&offset=0Выводы

С обновлением Googlebot скрыть ссылки, текст и другие части страниц сайта от поисковой системы стало сложнее, но лазейки есть. Поисковый движок рендеринга по прежнему не поддерживает сервис-воркеры.

Используя service workers с запросами можно проводить следующие манипуляции:

- Отправлять;

- Принимать.

- Модифицировать.

Применяя сервис-воркеры можно скрыть от поисковых систем ссылки, текст, и даже блок страницы.

Итак, в результате при необходимости поисковый оптимизатор может:

- Закрыть от индексации внешние ссылки с целью улучшения распределения статического ссылочного веса;

- Закрыть от индексации страницы тегов с низкой частотностью;

- Закрыть от индексации страницы пагинации;

- Скрытый текст или часть текста от индексации;

- Закрыть от индексации файлы;

- Закрыть от индексации блок и часть страницы;

- Скрыть от индексации реферальные ссылки.

Сервис-воркеры можно использовать и в целях улучшения производительности сайта. Например, намедни Google стал использовать сервис-воркеры в поисковой выдаче.

Схема одного из интересных трюков выглядит так:

- Вы искали ресторан, например утром;

- Спустя время, вы снова искали ресторан, например по той причине, что забыли о том, где находится заведение. На данном шаге Google выдаст результаты из кеша, который управляется сервис-воркером. Как результат, данные выдаются без отправки запроса в интернет.

Преимущества следующие:

- Снижается нагрузка на сервер Google, что приводит к снижению затрат;

- Увеличивается скорость загрузки страницы с ответом. Повышается лояльность пользователя;

- Страницы откроется даже без интернета. Повышается лояльность пользователя.

Остались ли у вас вопросы, замечания или комментарии по теме скрытия части содержания страниц от поисковых систем?

Скрытие ссылок от поисковых систем

Поисковые системы рекомендуют открывать ссылки к индексации, однако странно если бы совет был от обратного.

Способы закрыть ссылки сайта от поисковых системы

Приведенные ниже строчки кода позволяют скрыть ссылки сайта от индексации поисковыми системами.<input type="button" value="текст" >

<a href="#" >anchor</a>

<a href="#" >anchor</a>Данные способы проверены эмпирически. Можно проверить актуальность способов. Необходимо использовать операторы поиска от поисковых систем для проверки inanchor для поисковой системы от Google и anchorint для поисковой системы от Yandex.

Рекомендованное чтиво по теме операторов поиска для выдачи на сайте социальной сети интернет-специалистов MegaIndex.org по ссылкам ниже:

Скрытие ссылок от поисковых систем

Скрытие ссылок на сайте от поисковых систем происходит для достижения ряда целей по оптимизации.Цели скрытия ссылок:

- Увеличение статического веса важных для продвижения;

- Снижение статического веса передаваемого на внешние ресурсы;

- Снижение общего количества исходящих ссылок с сайта;

- Повышение релевантности страниц на основе аналитики.

Увеличение статического веса важных для продвижения документов

Любая страница передает статический вес по любым ссылкам на документа или изображений. Скрытие ссылок от поисковых систем позволяет передать большее количество статического веса важным для продвижения документам сайта.Рекомендованное чтиво по теме статического и анкорного веса на сайте социальной сети интернет-специалистов MegaIndex.org по ссылке далее:

Передача статического веса по ссылке и распределение анкорных весов в тексте ссылки.

Снижение статического веса передаваемого на внешние ресурсы

Закрывая от индексации исходящие ссылки страница не передает вес на сторонние сайты. Однако закрывать следует только низкоавторитетные сайты:Рекомендованное чтиво по теме:

Снижение общего количества исходящих ссылок с сайта

Снижение общего количества исходящих ссылок с сайта необходимо при наличии на сайте множества ссылок. Например, ссылок на профили пользователей в социальных сетях.Увеличение релевантности страниц на основе аналитики

В поисковой системе есть лидеры поиска по запросу. Текстовый анализ позволяет провести реверс-инжиниринг, определить параметры текста и использовать данные на сайте в целях поисковой оптимизации посредством скрытия ссылок если ссылок значительно больше значения медианы.Аналитика текста вычисляет и количество ссылок в документе сайта. Исходя из аналитики текста, ссылок на сайте может быть больше или меньше за нужное количество.

Рекомендованное чтиво по теме текстового анализа документа на сайте социальной сети интернет-специалистов MegaIndex.org:

Провести текстовый анализ можно используя приложение Текстовый анализ от сервиса MegaIndex.Сервис бесплатный.

Ссылка на сервис — MegaIndex

Закрываются ссылки для достижения ряда целей по поисковой оптимизации, но иногда и с целью анонимизации.

Закрытие ссылок

Кроме скрытия ссылок на сайте от поисковых систем в целях поисковой оптимизации, бывают и иные цели и методы по закрытию ссылок.Скрытие ссылок иногда происходит и исходя с целями:

- Скрытие источника информации от систем аналитики;

- Скрытия ссылок с целью запрета индексации.

Сервис по ссылке anonym.to позволяет скрывать все исходящие ссылки автоматически посредством установки на сайт javascript скрипта и использования сервиса anonym.to.

Иногда страницы надо закрыть от индексации. Закрывать рекомендуется служебные и технические страницы сайта. Рекомендованное чтиво по теме закрытия страниц от индексации на сайте социальной сети интернет-специалстов MegaIndex.org по ссылкам далее:

На большем сайте эффективно повышать релевантность документов сайта посредством правильногоиспользования перелинковки. Перелинковка создается в автоматическем режиме посредством использования специальных сервисов. Например, эффективно использовать приложение Перелинковка от сервиса MegaIndex.Сервис бесплатный.

Ссылка на сервис — MegaIndex.

Как спрятать ссылку от поисковиков

Почему поисковики не любят много ссылок на Ваших сайтах мы рассматривали в этой статье. Так же мы там рассмотрели один из методов как спрятать ссылку от поисковиков, но этот метод не всегда удобен. Например в Joomla этот метод не сработает, так как теги noindex и nofollow Joomla просто автоматически вырезает. Да и ходят слухи, что тег nofollow Гугл стал воспринимать как нарушение, но это не официальная информация.

Итак, рассмотрим ещё один метод «Как спрятать ссылки от поисковиков». Кому-нибудь этот метод может показаться очень «напряжным» (в плане затраченного времени), но со временем Вы привыкнете и будете это делать на автомате (я привык).

Теперь по пунктам:

- Предположим Вы хотите спрятать ссылку http://el-commercial.ru. Создавайте текстовый документ и вставляйте туда код такого вида:

<html>

<head>

<title>Регистрация на сайте el-commercial.ru</title>

<meta http-equiv=»refresh» content=»0;URL=http://el-commercial.ru»>

</head>

<body>

</body>

</html>

- Цифра «0» означает через сколько секунд произойдёт редирект, а URL — это ссылка, которую Вы хотите спрятать от поисковиков.

- Далее сохраняйте этот текстовый документ как «el-commercial.ru.html» (можете давать другие навзвания, лишь бы формат был html).

- В корневой папке Вашего сайта создайте папку (например «ssilka») и закидывайте туда файл «el-commercial.ru.html«.

- Далее в самой ссылке прописывайте не адрес «http://el-commercial.ru», а адрес «ssilka/el-commercial.ru.html».

То есть при нажатии по этой ссылке будет происходить редирект на тот адрес, который Вы указали, а соответственно поисковиками это будет считаться как внутренняя ссылка Вашего сайта, которая совершенно не причинит вреда самому сайту. Если Вы продаёте ссылки с Вашего сайта, который на Джумле, то это будет очень полезный метод, так как биржи купли продажи ссылок тоже не увидят Ваши ссылки, а соответственно Вы сможете больше продать.

Конкретный пример данного метода. Например мы хотим спрятать ссылку «http://www.sape.ru/r.gOvmMcQObC.php». Таким образом она будет выглядеть спрятанной «sape.ru«. При нажатии на ссылку обратите внимание на адресную строку браузера. Сначала она будет вида «http://el-commercial.ru/go/sape.ru.html» (где «go», это название моей папки куда я добавляю ссылки. Конкретно мы рассматривали папку «ssilka»), а уже через секунду появится адрес «http://www.sape.ru/r.gOvmMcQObC.php».

И ещё одна проблема, с которой я столкнулся после этого метода. Поисковики Вашу папку из корневого каталога «ssilka» воспримут как кучу новых страниц с ошибками, то есть каждая спрятанная ссылка по этому методу будет индексироваться поисковиками как страница с ошибкой. Чтобы этого избежать в robots.txt пропишите такую строку «Disallow: /ssilka/» для того, чтобы запретить роботу индексировать информацию с этой папки.

Интересное:

После наступления кризиса, у меня, как и у всех людей в России возникли денежные затруднения и мне нужно было найти работу. На сайте www.slando.kz я быстро нашёл работодателя и меня приняли на высокооплачиваемую работу. Так же на этом сайте можно найти хорошие и дешёвыемобильные телефоны.

Скрывать ли внешние ссылки на сайте?

В последнее время в рунете все чаще попадаются сайты, где внешние ссылки скрыты от поисковых систем при помощи JavaScript, или еще какими-то хитроумными способами разной степени сложности и заморочности. Даже систему кодирования base64 применяют.Base64, Карл!!! Это вообще жесть!

Чаще всего используют замену тега a href на какой-нибудь span с куском кода JavaScript, а чтобы пользователь все же видел, что это таки ссылка, добавляют в правила CSS для него cursor: pointer и в title прописывают адрес ссылки. Кто-то применяет для этого же библиотеку jQuery, хотя разницы абсолютно никакой.

Кстати, зачастую такие псевдо-ссылки не работают вовсе. Если вы используете этот метод, то проверьте, все ли ссылки у вас рабочие.

При этом владельцы сайтов наивно полагают, что поисковики не прочитают код JavaScript и не засчитают это ссылкой. Еще в 2014 году Гугл заявил, что поисковые роботы уже умеют прочитывать скрытое содержимое в JavaScript (Для просмотра ссылки необходимо: Войти илиРегистрация):

Traditionally, we were only looking at the raw textual content that we’d get in the HTTP response body and didn’t really interpret what a typical browser running JavaScript would see. When pages that have valuable content rendered by JavaScript started showing up, we weren’t able to let searchers know about it, which is a sad outcome for both searchers and webmasters.

In order to solve this problem, we decided to try to understand pages by executing JavaScript. It’s hard to do that at the scale of the current web, but we decided that it’s worth it. We have been gradually improving how we do this for some time. In the past few months, our indexing system has been rendering a substantial number of web pages more like an average user’s browser with JavaScript turned on. Sometimes things don’t go perfectly during rendering, which may negatively impact search results for your site.

Для тех, кто не в ладах с английским, суть приведенной цитаты вот в чем: раньше поисковые боты считывали только «сырой» текст страницы, не заглядывая в содержимое JavaScript. Но порой в этом содержимом заключалась ценная информация. Поэтому со временем роботы научились распознавать и ее тоже.

Обратите внимание на последнюю строку. В ней четко говорится, что пока боты делают это не идеально, и возможны траблы, что весьма негативно скажется на результатах поисковой выдачи. Оно вам таки надо?

Зачем вообще скрывать внешние ссылки?

Многие боятся, что попадут под очередные санкции от любимого поисковика за кучу внешних не релевантных ссылок со страниц сайта. Пример — комментарии на блоге. Если их достаточно много, то страница действительно будет ссылаться на кучу не релевантных сайтов, и это не есть гуд.

Вот тут и придумывают владельцы сайтов всякие извращения, чтобы ссылок как бы не было, но они как бы все равно были. То есть, чтобы посетитель их видел и мог воспользоваться, а боты поисковых систем — нет.

Так в чем проблема то?

Если вы хотите скрыть от поисковиков ссылку, но показать ее пользователю, то оформите ее простым текстом — http://www.site.com/ Поисковики не будут считать ее ссылкой. Не верите? Вот вам Для просмотра ссылки необходимо: Войти илиРегистрация (англ). Вкратце суть эксперимента там такова:

Было проверено, распознает ли Гугл текстовую ссылку без <a href именно как ссылку или нет? Оказалось, что таки он может узнать в этом тексте ссылку, но бот по ней не переходит, и никакого веса по ней не передается. Это вам не nofollow, который теперь отдает вес в никуда.

Еще в 2009 Мэтт Каттс говорил об этом же:

Включите титры с переводом на русский, если что-то непонятно. В целом, он говорит, что просто текст url не учитывается как ссылка, иначе вебмастера давно бы этим делом стали злоупотреблять. Думаю, с тех пор мало что изменилось.

Как скрыть внешнюю ссылку?

Зачем в очередной раз выдумывать велосипед? Во все времена вебмастера, если хотели показать ссылку, но только так, чтобы она не работала именно как ссылка, то просто писали ее обычным текстом:

http://www.site.com/

По-моему, лучшего пока ничего не придумали.

Лично у меня на блоге Вебсовет так и сделано в комментариях. Ссылка на сайт комментатора просто написана обычным текстом. Делает это встроенная функция comment_author_url(). И не нужно ничего выдумывать.

Подобный подход, имхо, позволяет поймать сразу двух зайцев:

Во-первых, отсеивает халявщиков. Никому будет не интересно сорить направо и налево своими ссылками, если они не работают как ссылки.

Во-вторых, это заставляет комментаторов оставлять более адекватные и ценные комментарии, а не короткие и ничего не значащие фразы. Если комментатор хочет, чтобы по его текстовой ссылке кто-то перешел, не поленившись скопировать ее и вставить в адресную строку браузера, то он напишет действительно толковый коммент.

Вывод

Прятать ссылки хитрыми способами — глупо! Поисковики рано или поздно накажут и за это. Будьте проще. Используйте обычный текст вместо ссылки, если хотите, чтобы поисковики по ним не переходили.

Автор: Игорь Квентор

Как закрыть ссылку от индексации с помощью jQuery и AJAX

Здравствуйте! Всем известно, что много открытых для индексации внешних ссылок на блоге – это не есть хорошо. В одной из статей я писал, как их можно закрыть с помощью тегов noindex и rel=”nofollow”. Но при этом вес страницы все равно снимается.

Здравствуйте! Всем известно, что много открытых для индексации внешних ссылок на блоге – это не есть хорошо. В одной из статей я писал, как их можно закрыть с помощью тегов noindex и rel=”nofollow”. Но при этом вес страницы все равно снимается.

Сайт-донор, с каждой открытой ссылкой, отдает определенную часть веса страницы сайту-акцептору (на который ссылаются). При использовании rel=”nofollow” вес не отдается сайту-акцептору, а уходит в никуда, потому что поисковики прекрасно видят эту ссылку.

Сегодня мы разберем один действенный способ скрытия внешних и, при необходимости, внутренних ссылок от индексации с помощью jQuery AJAX. Данный способ хорош тем, что поисковик не видит ссылку и распознает ее как простой текст.

jQuery — библиотека JavaScript, фокусирующаяся на взаимодействии JavaScript и HTML.

AJAX (Asynchronous JavaScript and XML) – это подход к построению пользовательских интерфейсов web-приложений, при котором страница, не перезагружаясь, выдает запрашиваемые пользователем данные.

Наглядным примером применения AJAX является карты Google Maps. Используя курсор, мы перемещаемся по карте и при этом картинка, почти мгновенно меняется, но сама web-страница не перезагружается. Тоже самое при увеличении масштаба карты.

Итак, чтобы скрыть ссылку, сначала надо подключить jQuery.

Как подключить библиотеку jQuery к сайту

Очень просто! В этом нам поможет поисковая система Google. Подключив, она, возможно, послужит Вам не раз. Функциональность библиотеки позволяет использовать ее для широкого круга задач. jQuery включается в web-страницу как внешний JavaScript –файл. Вставлять его будем в файл header.php. Для этого переходим в редактор через админпанель сайта или через FTP-клиент и перед закрывающим тегом </head> вставляем следующий код:

<script type="text/javascript" src="http://ajax.googleapis.com/ajax/libs/jquery/1/jquery.min.js"></script>

На этом, действие по подключению jQuery закончено. Идем дальше.

Закрываем ссылку от индексации с помощью AJAX

Но для начала установим скрипт, который будет заниматься обработкой запроса. Открываем файл footer.php и в самом конце, перед закрывающим тегом </body> вставляем следующее:

<script>$('.external-reference').replaceWith (function (){return'<a href="'+$(this).data ('link')+'" title="'+$(this).text ()+'">'+$(this).html ()+'</a>';})</script>Нужно отметить то, что данный код открывает ссылку в новом окне. Если же Вам это не надо, уберите из скрипта следующий участок:

6d6314b56239c43f9646094ccf9315a5000

Переходим, непосредственно, к скрытию самой ссылки. Стандартный вид ее имеет вид

<a href=»https://barbadosmaney.ru/ «> </a>. Новый вид ссылки будет выглядеть немного по другому.

Вот тот код в который нужно обернуть ссылку с использованием тега <span>:

<span data-link="http://site.ru/">анкор ссылки</span>

где,

site.ru – адрес ссылки с http://

class=»external-reference» – класс оформления ссылки.

Без данного класса ссылка будет выглядеть как обычный текст не только для поисковиков, но и для посетителей. Чтобы задать ей вид, переходим в файл style.css и вставляем следующий код:

onclick="return !window.open(this.href)" |

onclick=»return !window.open(this.href)»

Цвет можете задать свой.

Теперь ссылку поисковик примет за обычный текст. Но есть один нюанс: если вместо анкора использовать сам URL адрес сайта, то от робота Яндекса можно спрятать тегом noindex:

<!--noindex--><span data-link="Ссылка с http">URL адрес</span><!--/noindex-->

Скрываем от индексации изображение в виде ссылки

Часто требуется скрыть ссылку в картинке. Например, в роли таковых выступают изображения RSS-каналов или социальных сетей.

Процедура здесь практически таже самая, что и описывалась выше, только вместо анкора прописываются атрибуты изображения:

<span data-link="Ссылка с http"><img title="title для картинки" alt="alt для картинки" src="http://site.ru/kartinka.jpg" /></span>

Ну, вот и все, что хотелось написать по данной теме. Метод скрытия ссылок с помощью jQuery и AJAX мне понравился и пока он актуален. Посмотрим, что будет дальше.

Примечание. Данный метод больше не актуален, т.к ведет к санкциям со стороны Google за маскировку.

Поделиться «Как спрятать ссылку от индексации»

Как скрыть партнёрские ссылки от поисковых систем на wordpress – INFO-EFFECT

На чтение 4 мин. Опубликовано

Привет ! Сегодня я хочу рассказать о супер полезном плагине, который позволит вам управлять партнёрскими ссылками на вашем сайте. Плагин идеально подойдёт сайтам на которых много исходящих и партнёрских ссылок. Вы должны знать, что большое количество исходящих ссылок на сайте, плохо сказывается на продвижении сайта. Поэтому вам нужно скрыть от поисковых систем все исходящие и партнёрские ссылки, чтобы они их не видели и не индексировали. Как раз таки плагин – Easy Affiliate Links может вам в этом помочь. Вы сможете создавать целые сети партнёрских ссылок, распределять их по категориям и т.д.

Установить плагин вы сможете прямо из админ-панели wordpress. Перейдите на страницу: Плагины – Добавить новый, введите название плагина в форму поиска, нажмите Enter, установите и активируйте плагин.

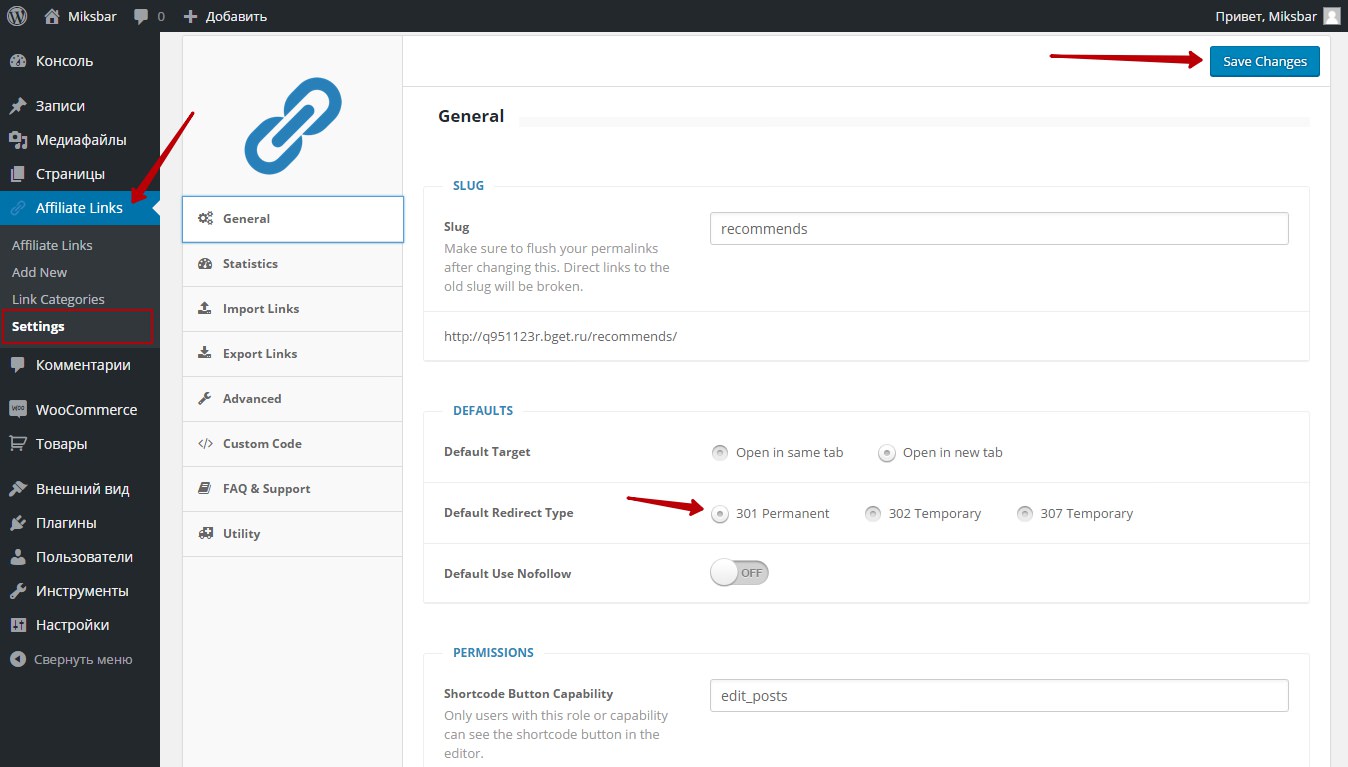

После установки и активации плагина, перейдите на страницу: Affiliate Links, чтобы настроить плагин. Настройки у плагина очень простые их можно и не настраивать, по умолчанию всё задано так как надо.

– Slug, здесь указан ярлык для партнёрских ссылок, который будет добавлен к ссылке вашего сайта. Вы можете указать любое свой слово латинскими буквами.

– Default Target, выберите в каком окне будет открываться ссылка. По умолчанию в новом окне, так и нужно.

– Default Redirect Type, здесь вы можете выбрать тип редиректа для партнёрских ссылок. По умолчанию стоит 301 редирект, рекомендуется использовать именно его. Такие поисковые системы как Яндекс и Google рекомендуют использовать именно 301 редирект для скрытия ссылок, об этом написано в кабинете вебмастера.

– Default Use Nofollow, можно включить тег nofollow для ссылок, но при 301 редиректе это можно и не делать, нет смысла.

– Shortcode Button Capability, оставьте без изменений.

– Сохраните изменения, нажав на кнопку – Save Changes.

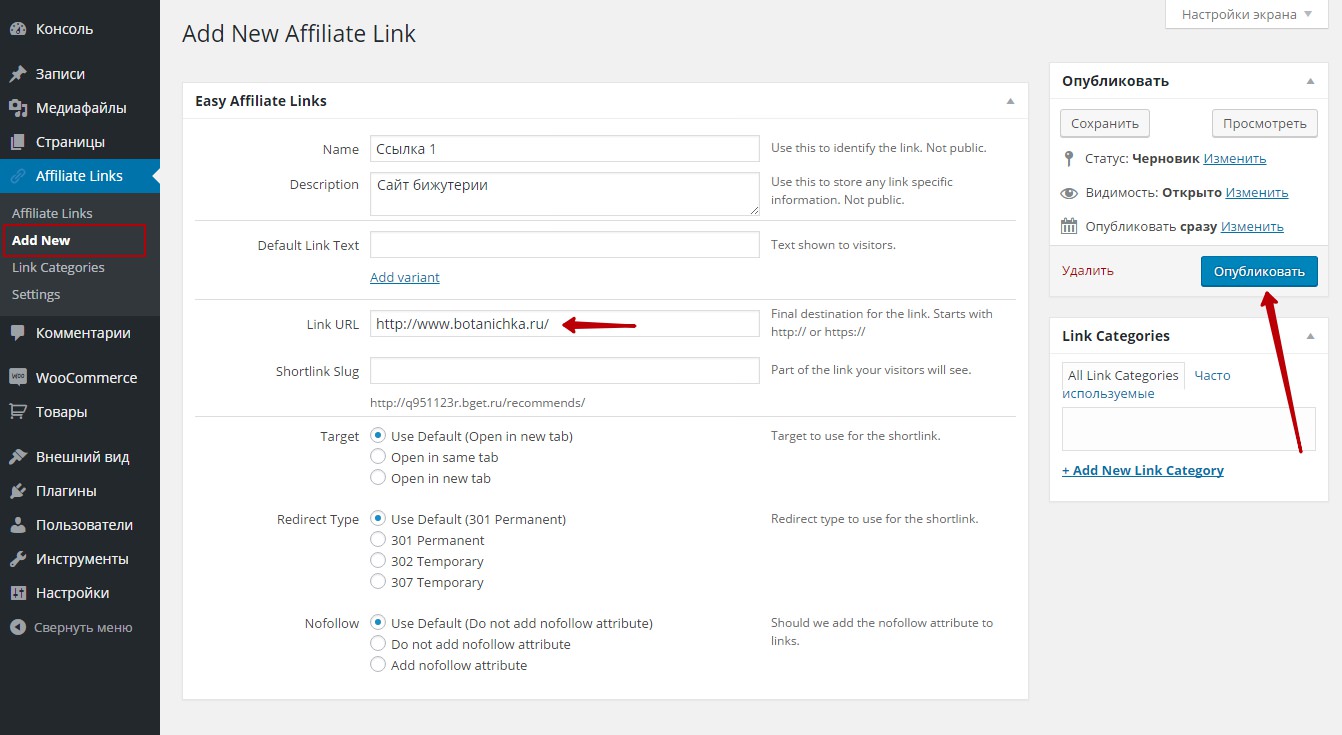

Далее, перейдите на страницу: Add New, здесь вы можете создать партнёрскую ссылку. Здесь всё очень просто, для меня ![]()

– Name, укажите здесь название ссылки, оно будет отображаться только для вас в админ-панели, чтобы было легче находить ссылки из всего списка.

– Description, укажите небольшое описание для ссылки, типа – Сайт бижутерии. Также отображается только для вас.

– Default Link Tex, укажите текст для ссылок по умолчанию, который отображается на сайте для всех. Например можно задать один текст для группы ссылок. На этот текст будет нажимать пользователь чтобы перейти по ссылке.

– Link URL, здесь нужно указать партнёрскую ссылку, которую вы хотите скрыть от поисковых систем.

– Shortlink Slug, оставьте поле пустым, здесь можно указать укороченную ссылку.

– Target, в каком окне открывать ссылку, по умолчанию – в новом окне.

– Redirect Type, здесь указан тип редиректа для ссылки, по умолчанию 301 редирект, оставьте его.

– Nofollow, оставьте без изменений.

– Нажмите на кнопку – Опубликовать.

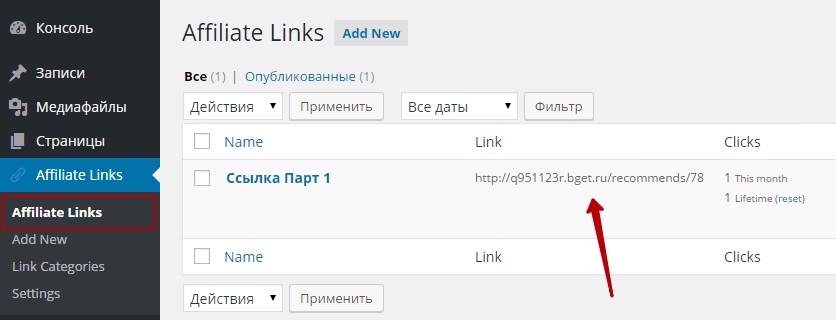

Ваша партнёрская ссылка готова ! Теперь перейдите на страницу: Affiliate Links. Здесь будет отображаться ваша партнёрская ссылка, только уже замаскированная под ваш сайт. Так ссылка будет выглядеть на вашем сайте, но если нажать по ссылки то вы попадёте на сайт который вы указали в настройках создании ссылки. То есть, поисковые системы вместо партнёрских ссылок будут видеть ваши ссылки, это очень хорошо !

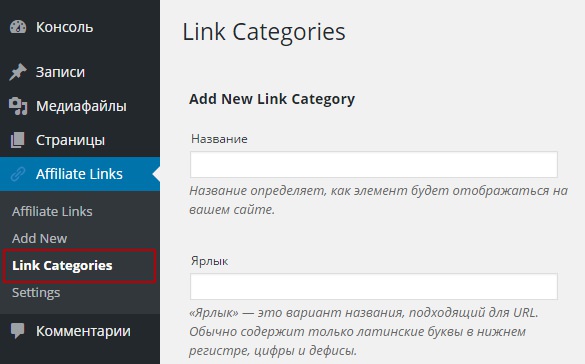

На странице Link Categories вы можете создавать категории для ссылок, чтобы распределять партнёрские ссылки по группам. Просто так легче управлять ссылками.

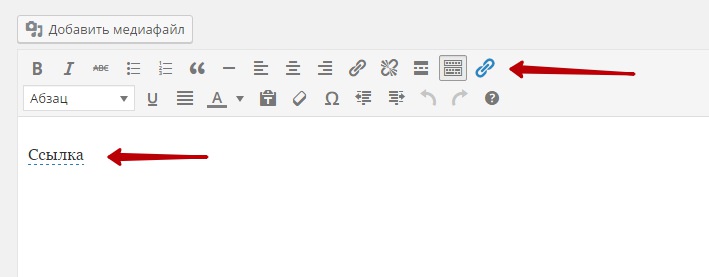

На странице редактирования записи или страницы, в визуальном редакторе появится новая кнопка в виде ссылки. С помощью данной кнопки вы сможете вставлять на сайт уже готовые партнёрские ссылки.

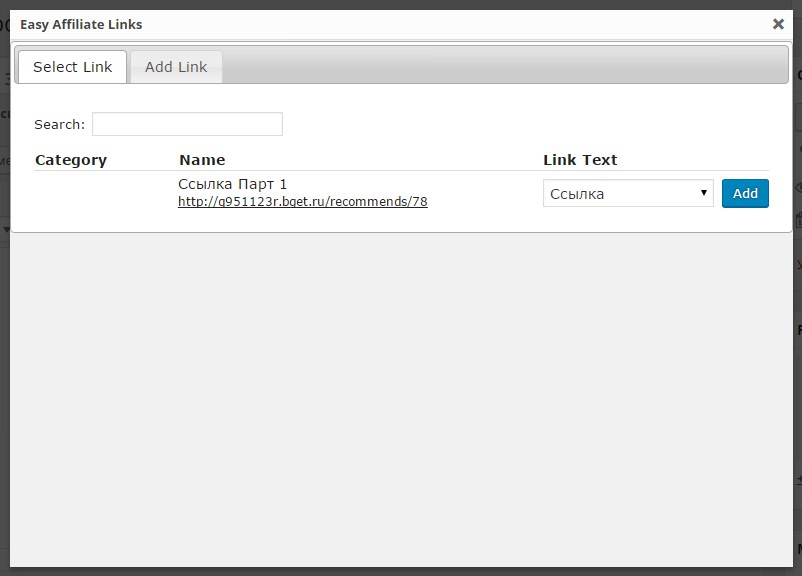

Нажмите на кнопку в виде синей ссылки, у вас откроется окно, здесь вы можете выбрать уже готовую ссылку или создать новую партнёрскую ссылку, нажав на вкладку – Add Link.

Вот и всё ! Всё очень просто и удобно, отличный плагин ! Оставьте свой комментарий, если у вас остались вопросы. До новых встреч !