HTML тег noindex | назначение, синтаксис, атрибуты, примеры

Последнее обновление: 22.01.2011

Тег <no index> (англ. no index — нет индекса) — тег-контейнер, запрещает индексацию текста в поисковых системах Яндекс и Рамблер.

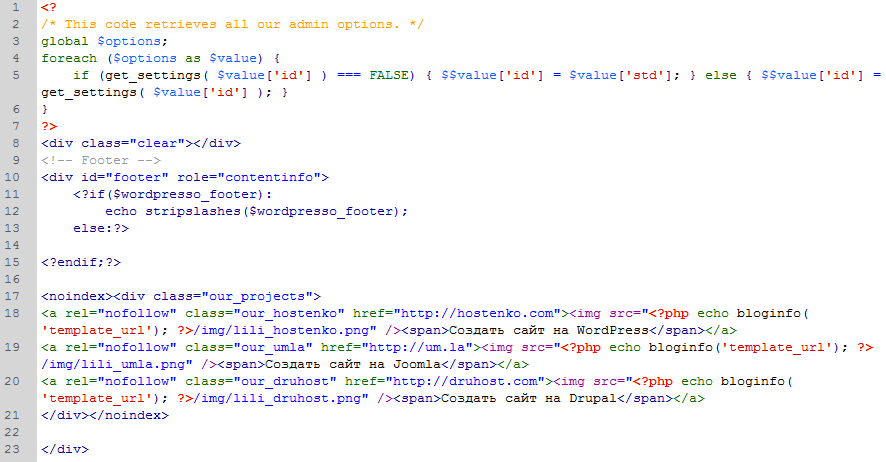

Как правило, в тег заключаются коды счетчиков, ссылки на внешние сайты (с целью исключить передачу рейтинга сайту на который ведет ссылка), информация, которая обновляется настолько часто, что индексировать ее нет смысла.

HTML: 3.2 | 4 / XHTML: 1.0 | 1.1

Синтаксис

<noindex>...</noindex>

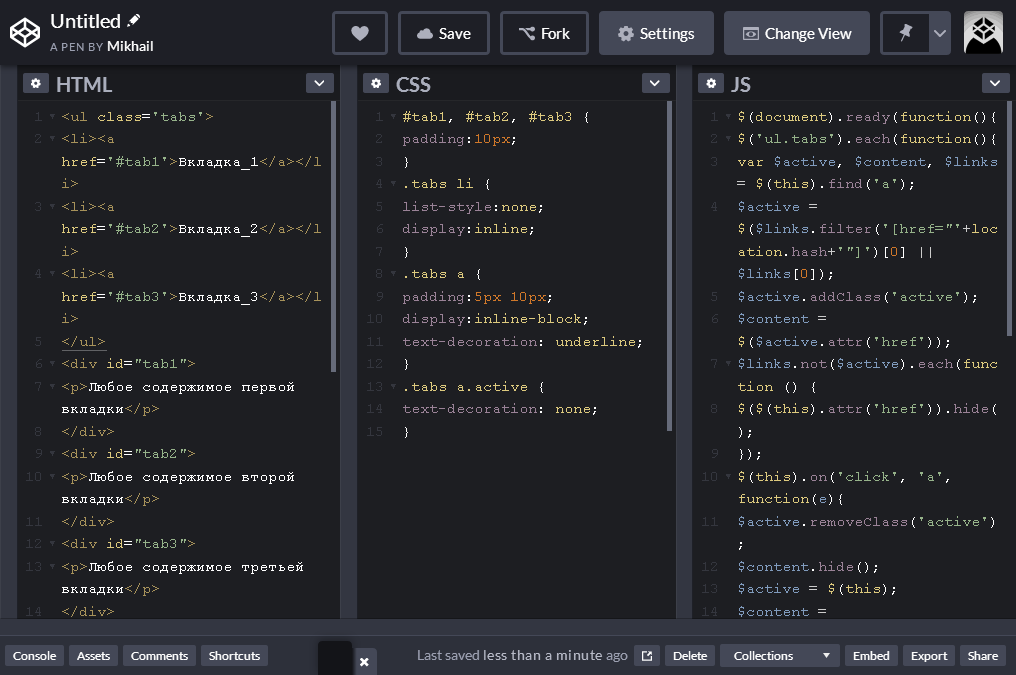

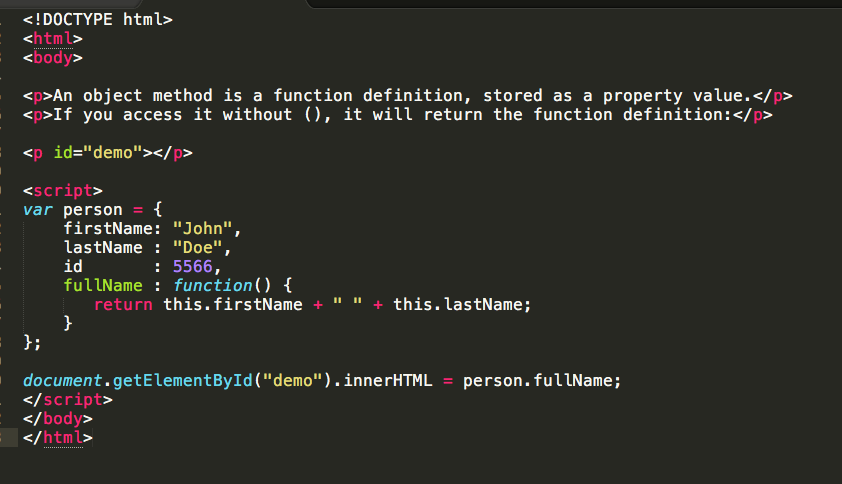

Пример

Запрещаем индексацию текста:

<noindex>Данный текст не будет индексироваться только в поисковых системах Яндекс и Рамблер</noindex>

Закрываем от индексации ссылку:

Самый продвинутый поисковик — <noindex><a href="http://google.com/">Google</a></noindex>

Твой код:

<html> <head> <title></title> </head> <body> <div> Самый продвинуты поисковик — <noindex><a ref=»nofollow» href=»http://google.

Результат:

большой полигонСледует заметить, что ссылки будут индексироваться внутри данного тега. Чтобы и ссылки не индексировались, добавлем им атрибут rel=»nofollow» (из ответов Палатона).

Google и Yahoo тег <noindex> игнорируют. В этих поисковиках запретить индексацию ссылок можно используя значение nofollow атрибута rel (rel=»nofollow») тега <a>.

Тег <noindex> отсутствует в спецификациях W3C (не пройдет валидацию).

Дополнительно некоторые ответы можно найти на официальном форуме Яндекс.

update 7.06.10 Можно попробовать сделать noindex валидным:

<span><![CDATA[<noindex>]]></span>

То, что запрещено к индексации

<span><![CDATA[</noindex>]]></span>

inv {display:none}

Источник.

update: 29. 06.10 Яндекс ввел поддержку валидного noindex:

06.10 Яндекс ввел поддержку валидного noindex:

<!--noindex-->текст, индексирование которого нужно запретить<!--/noindex-->

Источник — Яндекс.Помощь.Вебмастер.

По теме

Техническая оптимизация сайта — часть вторая — SEO на vc.ru

Пошаговый план от руководителя оптимизаторов в «Ашманов и партнёры» Никиты Тарасова.

{«id»:83683,»url»:»https:\/\/vc.ru\/seo\/83683-tehnicheskaya-optimizaciya-sayta-chast-vtoraya»,»title»:»\u0422\u0435\u0445\u043d\u0438\u0447\u0435\u0441\u043a\u0430\u044f \u043e\u043f\u0442\u0438\u043c\u0438\u0437\u0430\u0446\u0438\u044f \u0441\u0430\u0439\u0442\u0430 \u2014 \u0447\u0430\u0441\u0442\u044c \u0432\u0442\u043e\u0440\u0430\u044f»,»services»:{«facebook»:{«url»:»https:\/\/www.

ru\/seo\/83683-tehnicheskaya-optimizaciya-sayta-chast-vtoraya&text=\u0422\u0435\u0445\u043d\u0438\u0447\u0435\u0441\u043a\u0430\u044f \u043e\u043f\u0442\u0438\u043c\u0438\u0437\u0430\u0446\u0438\u044f \u0441\u0430\u0439\u0442\u0430 \u2014 \u0447\u0430\u0441\u0442\u044c \u0432\u0442\u043e\u0440\u0430\u044f»,»short_name»:»TG»,»title»:»Telegram»,»width»:600,»height»:450},»odnoklassniki»:{«url»:»http:\/\/connect.ok.ru\/dk?st.cmd=WidgetSharePreview&service=odnoklassniki&st.shareUrl=https:\/\/vc.ru\/seo\/83683-tehnicheskaya-optimizaciya-sayta-chast-vtoraya»,»short_name»:»OK»,»title»:»\u041e\u0434\u043d\u043e\u043a\u043b\u0430\u0441\u0441\u043d\u0438\u043a\u0438″,»width»:600,»height»:450},»email»:{«url»:»mailto:?subject=\u0422\u0435\u0445\u043d\u0438\u0447\u0435\u0441\u043a\u0430\u044f \u043e\u043f\u0442\u0438\u043c\u0438\u0437\u0430\u0446\u0438\u044f \u0441\u0430\u0439\u0442\u0430 \u2014 \u0447\u0430\u0441\u0442\u044c \u0432\u0442\u043e\u0440\u0430\u044f&body=https:\/\/vc.ru\/seo\/83683-tehnicheskaya-optimizaciya-sayta-chast-vtoraya»,»short_name»:»Email»,»title»:»\u041e\u0442\u043f\u0440\u0430\u0432\u0438\u0442\u044c \u043d\u0430 \u043f\u043e\u0447\u0442\u0443″,»width»:600,»height»:450}},»isFavorited»:false}

ru\/seo\/83683-tehnicheskaya-optimizaciya-sayta-chast-vtoraya&text=\u0422\u0435\u0445\u043d\u0438\u0447\u0435\u0441\u043a\u0430\u044f \u043e\u043f\u0442\u0438\u043c\u0438\u0437\u0430\u0446\u0438\u044f \u0441\u0430\u0439\u0442\u0430 \u2014 \u0447\u0430\u0441\u0442\u044c \u0432\u0442\u043e\u0440\u0430\u044f»,»short_name»:»TG»,»title»:»Telegram»,»width»:600,»height»:450},»odnoklassniki»:{«url»:»http:\/\/connect.ok.ru\/dk?st.cmd=WidgetSharePreview&service=odnoklassniki&st.shareUrl=https:\/\/vc.ru\/seo\/83683-tehnicheskaya-optimizaciya-sayta-chast-vtoraya»,»short_name»:»OK»,»title»:»\u041e\u0434\u043d\u043e\u043a\u043b\u0430\u0441\u0441\u043d\u0438\u043a\u0438″,»width»:600,»height»:450},»email»:{«url»:»mailto:?subject=\u0422\u0435\u0445\u043d\u0438\u0447\u0435\u0441\u043a\u0430\u044f \u043e\u043f\u0442\u0438\u043c\u0438\u0437\u0430\u0446\u0438\u044f \u0441\u0430\u0439\u0442\u0430 \u2014 \u0447\u0430\u0441\u0442\u044c \u0432\u0442\u043e\u0440\u0430\u044f&body=https:\/\/vc.ru\/seo\/83683-tehnicheskaya-optimizaciya-sayta-chast-vtoraya»,»short_name»:»Email»,»title»:»\u041e\u0442\u043f\u0440\u0430\u0432\u0438\u0442\u044c \u043d\u0430 \u043f\u043e\u0447\u0442\u0443″,»width»:600,»height»:450}},»isFavorited»:false}11 986 просмотров

В первой части мы разобрали, как оптимизировать URL-адреса, корректировать robots. txt, находить и удалять дубли страниц и так далее. Теперь переходим от базовых шагов к действиям, касающимся в основном качества работы сайта.

txt, находить и удалять дубли страниц и так далее. Теперь переходим от базовых шагов к действиям, касающимся в основном качества работы сайта.

Во второй части я расскажу про:

- Улучшение скорости загрузки сайта.

- Проверку оптимизации под мобильные устройства.

- Оптимизацию страниц пагинации.

- Поиск и устранение битых ссылок и редиректов.

- Внедрение микроразметки.

- Использование тега meta name=»robots» content=»…».

- Распределения ссылочного веса по страницам сайта.

- Использование тега noindex.

- Внутреннюю перелинковку.

- HTML- и XML-карты сайта.

- Оптимизацию HTML-кода.

- Внедрение турбо-страниц и AMP.

- Создание progressive web apps (PWA).

- Оптимизацию изображений.

- Требования к хостингу с точки зрения SEO.

Улучшение скорости загрузки сайта

Низкая скорость загрузки отрицательно влияет на удобство сайта, снижает конверсию и поведенческие показатели. Поэтому для пользователей и для поисковых систем одинаково важно, чтобы сайт работал быстро.

Сервис PageSpeed Insights помогает оценить скорость загрузки любой страницы сайта и подсказывает, как улучшить показатели.

Другие способы ускорить сайт:

Оптимизация под мобильные устройства

С внедрением mobile-first indexing Google отдаёт приоритет сайтам, оптимизированным под мобильные устройства.

Это относится к аудитории Google во всем мире, поэтому наличие адаптивной верстки необходимо для ранжирования в поисковой системе.

Представители «Яндекса» также заявляли, что учитывают в ранжировании мобильную версию сайта (алгоритм «Владивосток»).

Проверить, насколько хорошо сайт адаптирован к мобильным устройствам, можно в «Яндекс.Вебмастере» или в Google Search Console.

Массово проверить страницы на оптимальную скорость работы и на оптимизацию под мобильные устройства помогут инструменты от A-Parser и Screaming Frog.

Оптимизация страниц пагинации

Вопрос в том, нужно ли их оптимизировать и как это делать правильно. Мой коллега Дмитрий Мрачковский очень подробно рассуждал на эту тему в одной из колонок.

Вопрос в том, нужно ли их оптимизировать и как это делать правильно. Мой коллега Дмитрий Мрачковский очень подробно рассуждал на эту тему в одной из колонок.Я же приведу несколько практических рекомендаций, которые регулярно использую в работе.

Использование атрибута rel=”canonical”

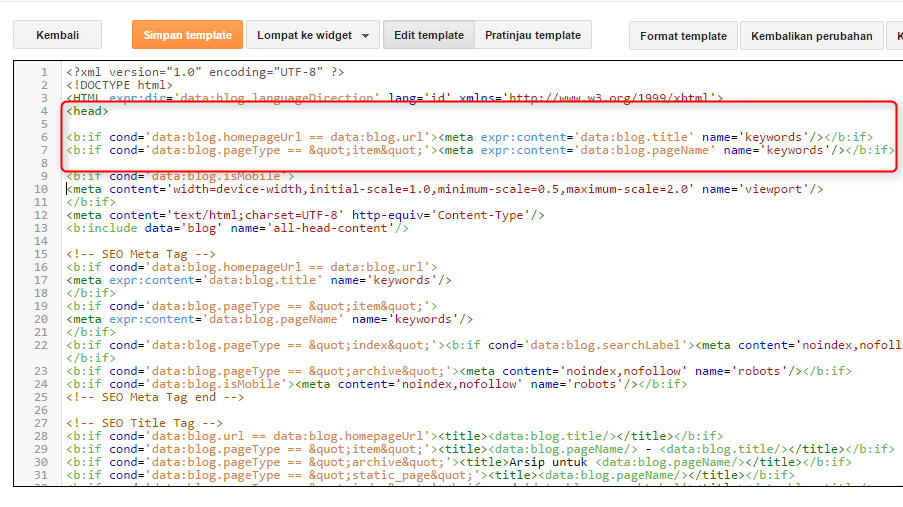

«Яндекс» рекомендует проставлять тег rel=”canonical”. Со второй и последующих страниц пагинации, например, http://domain.ru/category/?PAGEN_1=2 необходимо проставить тег rel=”canonical” на первую страницу.

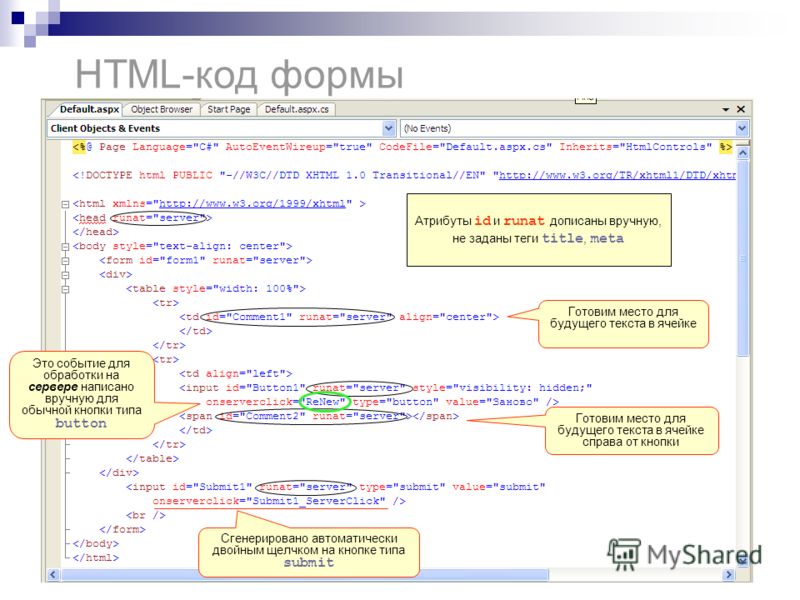

На странице http://domain. ru/category/?PAGEN_1=2 с учетом рекомендаций в разделе <head>…</head> будет размещена следующая конструкция:

ru/category/?PAGEN_1=2 с учетом рекомендаций в разделе <head>…</head> будет размещена следующая конструкция:

<link rel=»canonical» href=»http://domain.ru/category/»/>

Формирование мета-тегов

Мета-теги title и description для страниц пагинации следует формировать по следующему шаблону:

<title>h2 — страница N из page_last</title>

<meta name=»description» content=»»/>

При этом h2 должен совпадать с тегом <h2>.

Page_last — указывает на суммарное число страниц в разделе.

Пример для страницы https://www.domain.ru/catalog/category/?PAGEN_1=2:

<title> Категория — страница 2 из 201</title>

На второй и последующих страницах пагинации мета-тег description выводиться не должен.

Вывод описаний

На второй и последующих страницах пагинации не стоит выводить текст с описанием, который есть на первых страницах.

Пример некорректного вывода текста на странице https://domain.ru/kuhonnye-divany/?page=2.

Не скрывайте текст на второй и последующих страницах пагинации с помощью стилей (display:none). Исключайте его из кода этих страниц.

Поиск и устранение битых ссылок и редиректов

«Битые» ссылки, ведущие на несуществующий сайт, страницу или файл, снижают уровень удобства сайт. Когда посетитель вместо нужной информации видит 404 ошибку, он теряет доверие к сайту. Поисковые системы также не любят битые ссылки.

Поисковые системы также не любят битые ссылки.

- В режиме «Spider» запускаем сканирование сайта и дожидаемся его завершения.

- Далее выгружаем отчет Bulk Export — Response Codes — Client Error (4xx) Inlinks, где Source — ссылающаяся страница, Destination — адрес некорректной ссылки, а Anchor — анкор.

Что касается редиректов, то у «Яндекса» на этот счёт есть подробное руководство. Если коротко, редирект может быть полезен только в том случае, если адреса страниц меняются по техническим причинам и необходимо перенаправить пользователя на новый адрес страницы. В остальных случаях редиректы лучше избегать.

Для поиска редиректов на сайте рекомендуется использовать Screamin Frog Seo Spider

- В режиме «Spider» запускаем сканирование сайта и дожидаемся его завершения.

- Далее выгружаем отчет Bulk Export — Response Codes — Client Error (3xx) Inlinks, где Source — ссылающаяся страница, Destination — URL страницы с редиректом, Anchor — анкор.

- Выгружаем отчет Response Codes — Redirection (3xx).

- Для указания URL конечной страницы используем функцию ВПР =ВПР(B2;'[response_codes_redirection_(3xx).xls]1 — Redirection (3xx)’!$A:$J;9;ЛОЖЬ). В столбце I как раз конечный URL.

- Далее сохраняем данные в таблице как обычные значения.

Внедрение микроразметки

Микроразметка делает сайт понятнее и помогает поисковым системам извлекать и обрабатывать информацию для представления в результатах поиска.

«Яндекс» подтверждает косвенное влияние микроразметки на ранжирование сайта. Добавление микроразметки также положительно влияет на отображение сниппетов в Google.

Ниже приведу наиболее распространенные типы микроразметки.

Видео

Этот тип микроразметки служит для улучшения представления видеоматериалов в результатах поиска. О нем подробно написано в руководстве «Яндекса».

Отзывы

Этот тип разметки позволяет выводить в результатах поиска количество отзывов и рейтинг товара, что положительно влияет на кликабельность результатов в выдаче.

Элементы навигации

Строка навигации представляет собой цепочку ссылок, которая иллюстрирует структуру сайта и помогает пользователям ориентироваться в ней.

Данные навигации, размеченные в «хлебных крошках» сайта, помогут Google лучше их идентифицировать и правильнее отобразить информацию страницы сайта в результатах поиска. Подробнее читайте в руководстве Google.

Изображения

Разметка информации об изображениях помогает улучшить представление изображений в сервисе «Яндекс.Картинки». Подробнее о данной разметке.

Разметка Open Graph для видео

Рекомендую дополнительно разместить видео с помощью разметки Open Graph. Это поможет видео корректно отображаться в соцсетях. Подробнее о разметке.

Это поможет видео корректно отображаться в соцсетях. Подробнее о разметке.

Социальные сети

Если добавить на сайт специальную разметку, ссылки на профили компании в соцсетях будут появляться в блоке знаний Google и пользователи смогут открывать их прямо из «Поиска».

Пример кода для внедрения:

<script type=»application/ld+json»>

{

«@context»: «https://schema.org»,

«@type»: «Person»,

«name»: «Рога и копыта»,

«url»: «https://www. domain.ru/»,

domain.ru/»,

«sameAs»: [

«https://twitter.com/domain»,

«https://www.facebook.com/domain»,

«https://vk.com/domain»,

«http://instagram.com/domain»,

]

}

</script>

Сведения об организации

Внедрение микроразметки элемента «Организация» позволит улучшить отображение сниппета сайта в поисковой выдаче (работает совместно с информацией из «Яндекс.Справочника»).

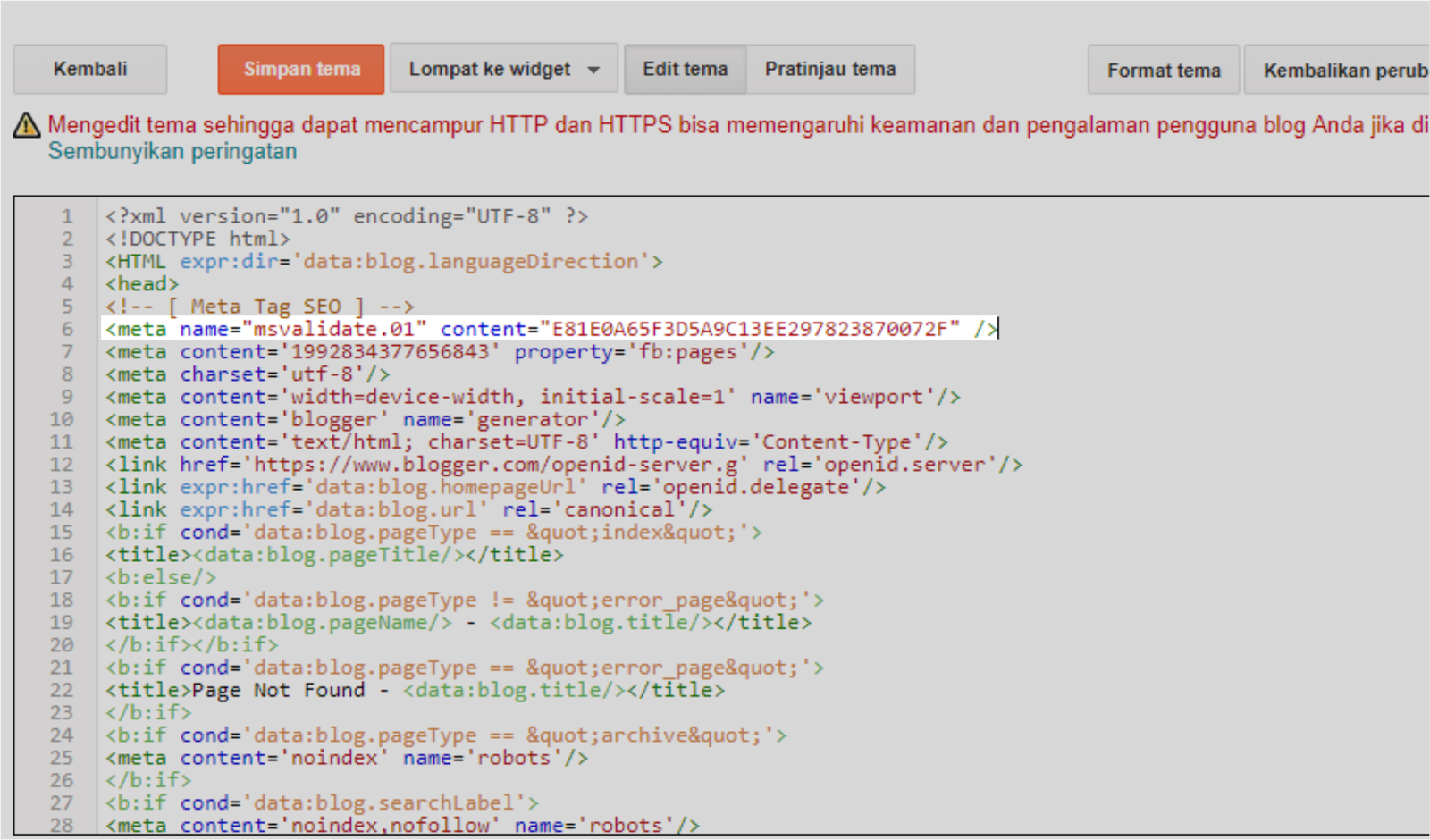

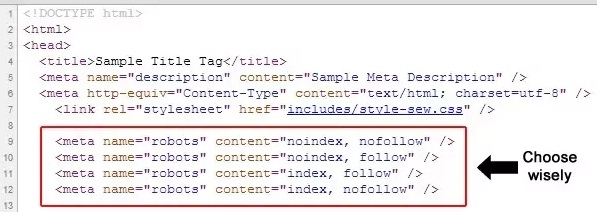

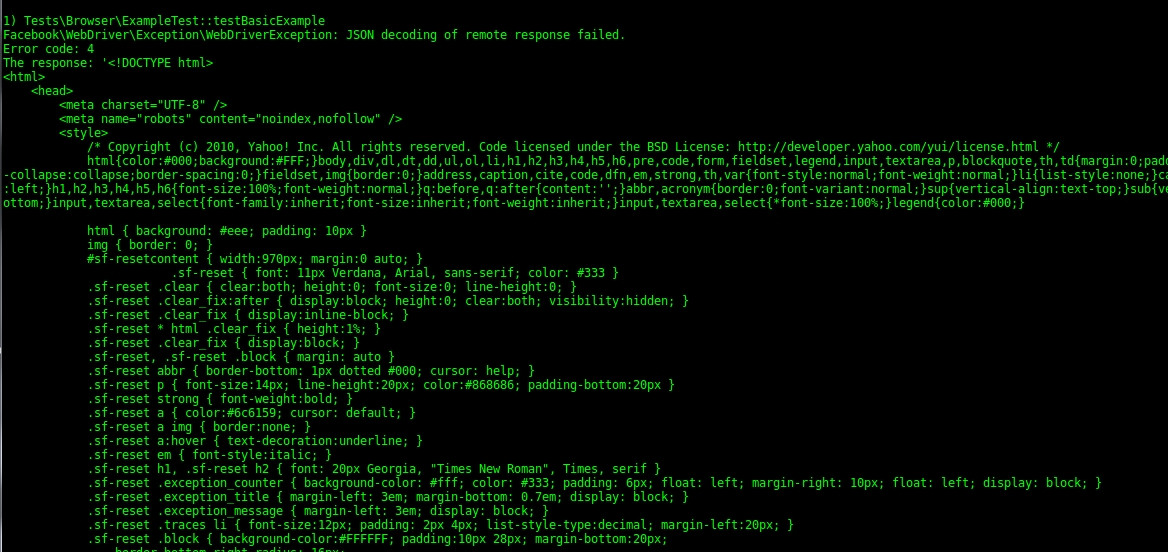

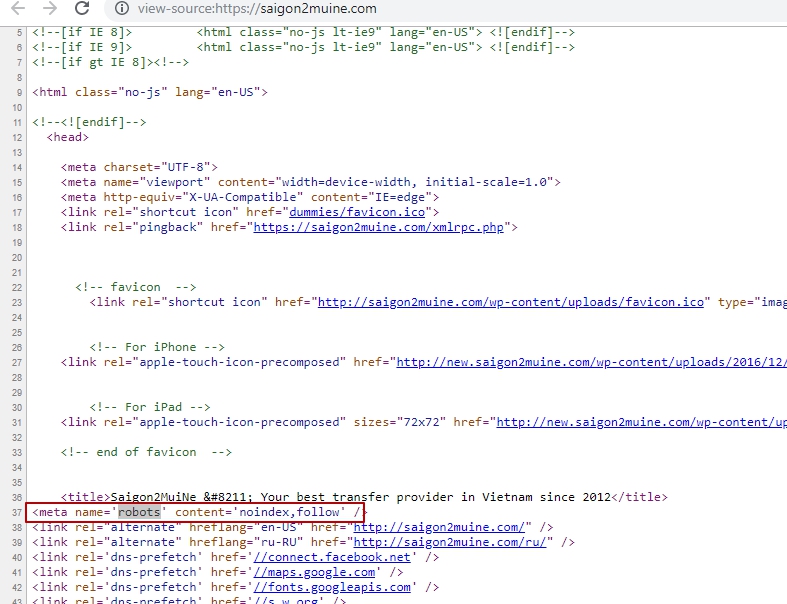

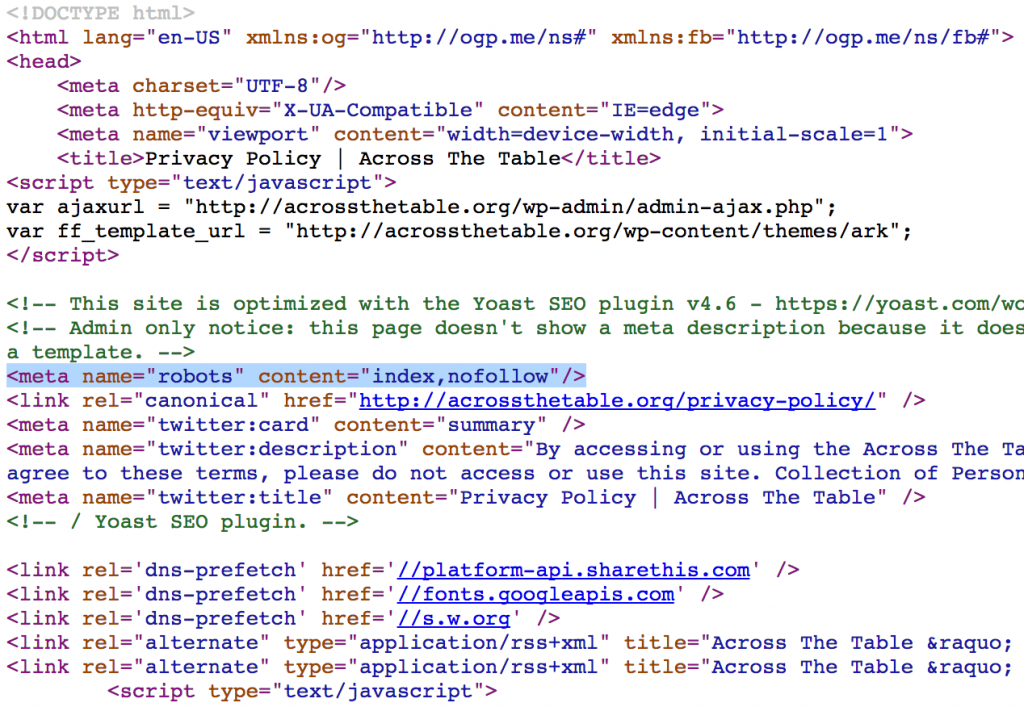

Использование тега meta name=»robots» content=»…»

Этот тег аналогичен по своему назначению файлу robots. txt и позволяет указывать поисковым роботам, какие страницы индексировать, а какие — нет. Ниже приведу выдержку из руководства «Яндекса», описывающую функциональные возможности тега:

txt и позволяет указывать поисковым роботам, какие страницы индексировать, а какие — нет. Ниже приведу выдержку из руководства «Яндекса», описывающую функциональные возможности тега:

- <meta name=»robots» content=»all»/> — разрешено индексировать текст и ссылки на странице, аналогично <meta name=»robots» content=»index, follow»/>.

- <meta name=»robots» content=»noindex»/> — не индексировать текст страницы.

- <meta name=»robots» content=»nofollow»/> — не переходить по ссылкам на странице.

- <meta name=»robots» content=»none»/> — запрещено индексировать текст и переходить по ссылкам на странице, аналогично <meta name=»robots» content=»noindex, nofollow»/>.

Весь перечень доступных атрибутов для данного тега можно найти в официальных справках поисковых систем.

Стоит провести проверку сайта (например, при помощи Screaming Frog Seo Spider) на предмет запрета индексации страниц через данный тег. В случае если часть продвигаемых страниц запрещена для индексации — следует скорректировать данный тег.

Оптимизация распределения ссылочного веса по страницам сайта

Ссылочный вес — показатель, который формируется из количества страниц, ссылающихся на оцениваемый URL сайта (входящих ссылок), и количества ссылок, ведущих со ссылающихся страниц (исходящих ссылок).

Правильное распределение ссылочного веса помогает подчеркнуть важность определённых страниц сайта в его структуре и улучшить ее оценку со стороны поисковых систем. Это помогает ускорить индексацию и улучшить ранжирование выбранных страниц.

Для оптимизации распределения ссылочного веса на сайте необходимо снабдить часть ссылок атрибутами rel=”nofollow”. Это необходимо сделать для ссылок, которые ведут на страницы, закрытые от индексации в robots.txt.

Например, ссылки с вариантами сортировки товаров по цене, популярности и так далее.

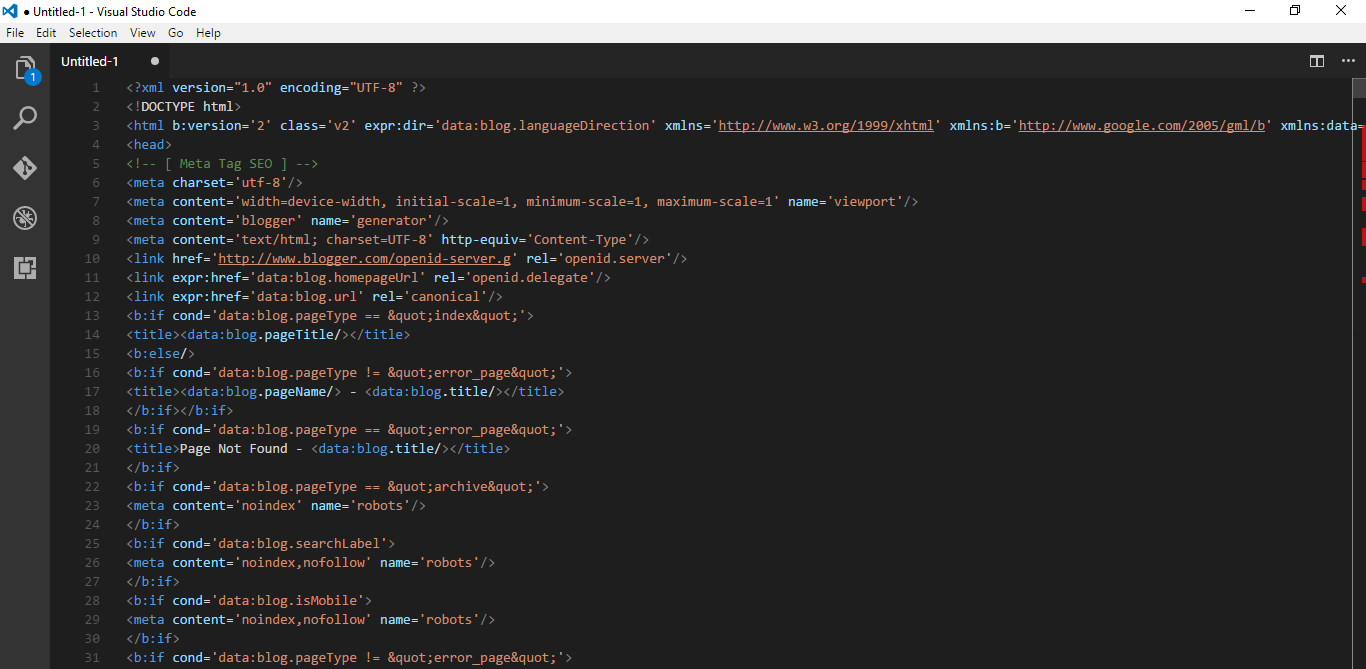

Использование тега noindex

Сразу замечу, что тег воспринимается только поисковой системой «Яндекс», Google его не поддерживает.

Конструкция noindex используется для закрытия от индексации дублирующихся и служебных участков текста.

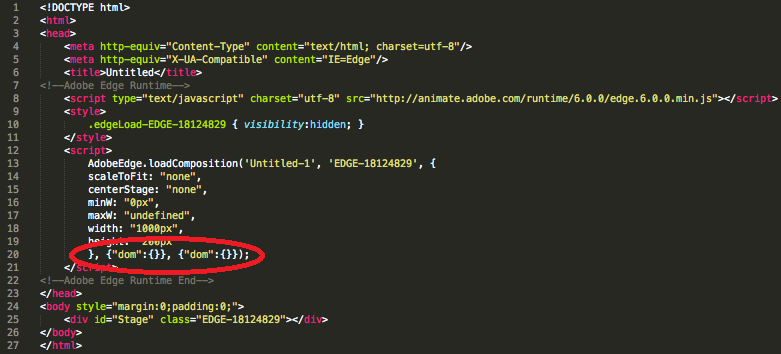

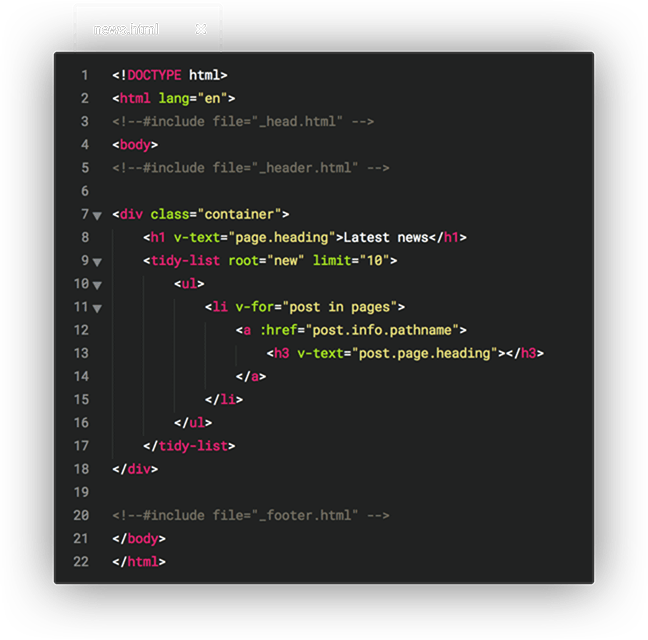

Для валидности кода необходимо использовать конструкцию вида:

<!—noindex—>код<!—/noindex—>

Например, стоит закрыть от индексации блоки с инфографикой, дублирующиеся на всех страницах.

Внутренняя перелинковка

Перелинковка внутренних страниц сайта способна повышает эффективность продвижения. Когда мы устанавливаем активные гиперссылки на продвигаемые страницы, то увеличиваем их ссылочный «вес».

Когда мы устанавливаем активные гиперссылки на продвигаемые страницы, то увеличиваем их ссылочный «вес».

Добавление «хлебных крошек»

Чтобы упростить навигацию на сложных сайтах, есть старый прием, получивший название «хлебных крошек»: в верхней части страницы располагается навигационная строка, содержащая ссылки вверх по структуре сайта.

Пример реализации: Главная / Каталог / Категория / Подкатегория.

Навигационная цепочка должна соответствовать следующим пунктам:

- Цепочка расположена на всех страницах сайта кроме главной (корневой каталог).

- Данный элемент навигации следует разместить вверху страницы, непосредственно над или под заголовком h2.

- Хлебные крошки не должны дублироваться на странице.

- Ссылками должны являться все пункты, за исключением текущего (последнего).

Элемент «Хлебные крошки» имеет следующие преимущества:

- Страницы сайта, находящиеся выше в иерархической структуре, обеспечиваются ссылочным весом с помощью внутренних ссылок с других страниц сайта.

- Это позволяет обеспечить более эффективное продвижение страниц, релевантных ключевым запросам.

- Пользователю сайта более понятна его структура, проще ориентироваться на сайте.

Это ценно в том случае, если пользователь попадает на внутреннюю страницу сайта напрямую из поиска.

Это ценно в том случае, если пользователь попадает на внутреннюю страницу сайта напрямую из поиска.

Блок перелинковки для страниц карточек товаров

Внутреннюю переликновку, особенно для интернет-магазинов и сайтов услуг, можно осуществлять не только за счет гиперссылок в текстах, но и за счет блоков с товарными рекомендациями.

Подобная реализация не только позволит более равномерно распределить ссылочный вес, но и поможет улучшить поведенческие характеристики.

Некоторые СMS (например, Bitrix) позволяют выстраивать целые рекомендательные системы, использование которых может увеличить средний чек.

HTML- и XML-карты сайта

HTML-карта

HTML-карта сайта используется для помощи посетителям, чтобы было проще ориентироваться на сайте. Также карту используют, чтобы ускорить индексацию сайта поисковыми роботами и создать древовидную структуру, чтобы все страницы сайта были максимум в двух кликах от главной.

Стоит добавлять в HTML-карту только значимые и важные страницы. Например, ссылки на основные разделы, подразделы сайта.

Интернет-магазинам не стоит добавлять в HTML-карту ссылки на все товары. Особенно если товарный ассортимент измеряется сотнями или тысячами товаров.

Особенно если товарный ассортимент измеряется сотнями или тысячами товаров.

Еще одним аргументом за использование ссылок только на основные разделы в HTML-карте является удобство ориентации пользователя на странице. Иначе крайне сложно найти какую-либо информацию на странице, содержащей сотни или тысячи ссылок.

Пример html-карты сайта

XML-карта

XML-карта сайта является обязательным атрибутом активно продвигаемых веб-ресурсов. Для достижения наиболее полной индексации сайта www. domain.ru, настоятельно рекомендуется подготовить файл Sitemap и выложить его на сайт по адресу: http://www.domain.ru/sitemap.xml.

domain.ru, настоятельно рекомендуется подготовить файл Sitemap и выложить его на сайт по адресу: http://www.domain.ru/sitemap.xml.

С помощью файла Sitemap можно сообщать поисковым системам о страницах сайта, которые доступны для индексации. Файл Sitemap представляет собой XML-файл, в котором перечислены URL-адреса сайта в сочетании с метаданными, связанными с каждым URL-адресом (дата его последнего изменения; частота изменений; его приоритетность в рамках сайта). Эти данные помогают поисковым системам оптимизировать процесс индексации сайта.

Отмечу, что карта сайта должна содержать ссылки только на значимые страницы, содержащие уникальный контент. Карта сайта не должна содержать:

- URL-адреса, отдающие заголовки: 4хх, 3хх, 5хх (например, 500, 404, 301 или 302 и так далее).

- Страницы, закрытые от индексации файлом robots.txt или мета-тегом <meta name=»robots» content=»NOINDEX, NOFOLLOW»/>.

- Страницы-дубли, неинформативные или пустые страницы.

- Sitemap может описывать только страницы того домена, на котором он расположен.

После того, как карта сайта будет создана, следует добавить в файл robots.txt, находящийся в корневой директории сайта, директиву Sitemap: http://www.domain.ru/sitemap.xml.

Директива сообщит поисковым роботам, где находится карта сайта.

Желательно, чтобы XML-карта сайта автоматически обновлялась хотя бы раз в сутки.

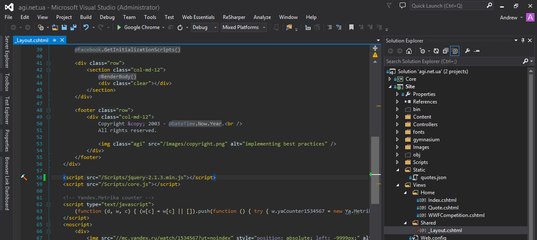

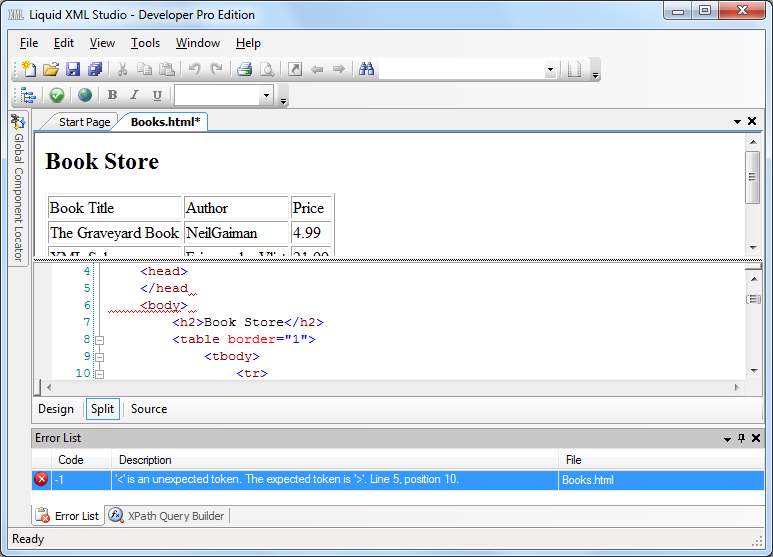

Оптимизация HTML-кода

Простой код без ошибок помогает поисковым роботам быстрее и без лишних препятствий индексировать сайт. Это положительно сказывается на ранжировании.

Рекомендую проверять на ошибки основные типы страниц сайта:

- Главная — https://domain.ru/.

- Категория/Подкатегория — https://domain.ru/catalog/category/.

- Страницы карточки — https://domain.ru/product/name-product/.

- Страница пагинации — https://domain.

ru/catalog/category/.

ru/catalog/category/. - Служебные страницы — https://domain.ru/page/.

Список шаблонов страниц может варьрироваться в зависимости от типа сайта.

Проверить сайт на отсутствующие и лишние теги можно при помощи сервиса FXN.

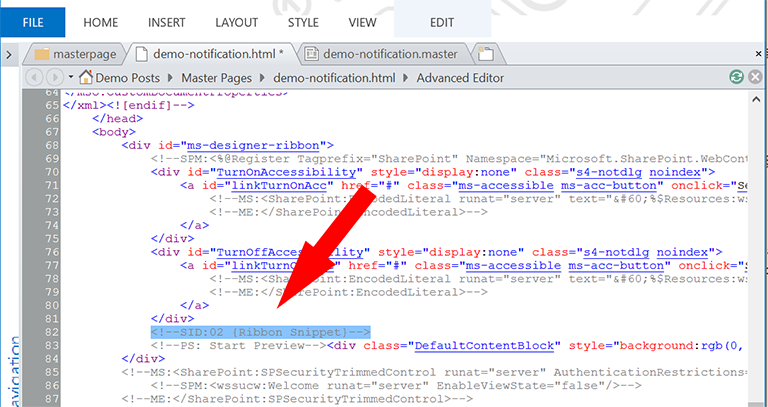

Также в идеале код не должен содержать большие закомментированные фрагменты, например:

Пример кода с закомментированным фрагментом

Внедрение турбо-страниц и AMP

На текущий момент у «Яндекса» и Google существуют две похожие технологии:

Они помогают ускорить загрузку контента, что положительно сказывается на удобстве сайта и поведенческих метриках.

Турбо-страницы и AMP обычно не содержат большинство вспомогательных элементов, включая виджеты, формы комментирования, блоки рекомендованного контента, рекламные объявления.

Несмотря на то, что есть решения, позволяющие создавать турбо-страницы и AMP для коммерческих ресурсов, я бы не рекомендовал использовать эту технологию для коммерческих страниц сайта, потому что есть риск ухудшить конверсию.

AMP и турбо-страницы хорошо работают на информационных ресурсах. Если у вас контентный проект или у вашего интернет-магазина есть блог или раздел со статьями, то ускоренные страницы внедрять однозначно стоит. Тем более, что с недавних пор «Яндекс» анонсировал отдельный колдунщик (блок) турбо-страниц для десктопной выдачи.

Внедрение турбо-страниц позволит сформировать привлекательный сниппет и привлечь дополнительный трафик из колдунщика.![]()

Пример сниппета при ипользовании турбо-страниц

Создание progressive web apps (PWA)

PWA — сайт, который можно добавить на главный экран телефона, и он будет работать в автономном режиме.

PWA обладает следующими преимуществами:

- Google поднимает PWA значительно выше в поисковой выдаче. Также все прогрессивные веб-приложения работают по протоколу HTTPS, соответственно, Google также позитивно реагирует на это, поскольку наличие защищенного протокола является одним из факторов ранжирования в поисковой системе.

- Кроссплатформенность Progressive Web Apps дает нам возможность делать одно веб-приложение, которое будет работать абсолютно на всех устройствах, где присутствует браузер.

- Возможность продолжать работу с приложением при сбоях интернет-подключения и увеличенная скорость загрузки с помощью PWA обезопасит от утери потенциальных конверсий и от увеличения количества отказов.

Ниже приведены рекомендации по созданию PWA

Создать иконку приложения

Сайт будет располагаться на экране, а значит, нужна иконка. Сгенерировать иконку можно при помощи сервиса Firebase. Затем необходимо разместить иконки на сайте.

Затем необходимо разместить иконки на сайте.

Разместить манифест

Manifest — это файл JSON, который описывает все метаданные вашего Progressive Web App. Такие атрибуты, как название, язык и значок вашего приложения. Эта информация укажет браузерам, как отображать ваше приложение, когда оно будет сохранено в виде ярлыка.

Полное описание всех свойств доступно по ссылке.

Далее следует загрузить полученный файл на сайт, внутри тега <body> разместить ссылку на JSON-файл. Проверить корректность созданного манифеста можно при помощи сервиса manifest-validator.appspot.com

Проверить корректность созданного манифеста можно при помощи сервиса manifest-validator.appspot.com

Добавить service worker

Service Worker — это скрипт, работающий в фоновом режиме, который браузер может запускать даже тогда, когда пользователь не находится на вашей странице. Он предоставляет офлайновую поддержку и просыпается при получении уведомления.

Сгенерировать Service Worker можно при помощи этого сервиса.

Необходимо подключить service worker в шаблонах основных страниц, разместив следующий скрипт внутри тега <body>.

Также необходимо разместить файл pwabuilder-sw.js в корне сайта.

Тестирование

Проверить корректность работы PWA можно при помощи инструмента Lighthouse.

Оптимизация изображений

Чтобы получить дополнительный трафик из поиска по картинкам, рекомендуется настроить «псевдостатическую» адресацию для файлов изображений.

При настройке «псевдостатических» URL изображений следует придерживаться нескольких простых правил:

- Не допускать в URL-адресах использования специальных символов, таких как «?», «=», «&» и других.

- Использование цифр в «псевдостатических» адресах допускается без ограничений.

- В качестве разделителя слов в адресе рекомендуется использовать символ «-» (дефис).

- Для формирования URL необходимо использовать транслитерированные ключевые слова, в точности соответствующие содержимому страницы. Файлы изображений, размещённых на страницах новостей и статей, рекомендуется называть по аналогии с URL страниц с добавлением слова «foto», а если изображений несколько, добавлять числовой идентификатор «foto-1», «foto-2», «foto-3» и так далее.

- В адресах изображений следует использовать только строчные латинские символы, не кириллицу.

Пример, как может выглядеть имя для изображения http://www.domain.ru/upload/iblock/2a6/006.jpg, размещенного на странице http://www. domain.ru: photo-name.jpg

domain.ru: photo-name.jpg

Важно: после внедрения «псевдостатической» адресации со всех старых URL на новые необходимо настроить 301 редиректы.

Отмечу, что у изображений должен быть заполнен атрибут ALT. Он служит для отображения заданного фрагмента текста («alternative text») вместо картинки. Он должен содержать её краткое словесное описание. Этот текст будет доступен для индексации роботам поисковых систем, повысит релевантность каждой конкретной страницы.

Тег ALT необходимо добавить ко всем изображениям.

Основной принцип формирования: в атрибуты ALT основных изображений на сайте (изображения за исключением элементов дизайна) рекомендуется включить предложение, отвечающее следующим требованиям:

- Текст до десяти слов, описывающий содержимое картинки.

- Текст может совпадать с <h2>, если это логически допустимо.

- Текст должен описывать изображение теми словами, по которым сайт могут искать пользователи.

- Допускается дублирование данных атрибутов.

Шаблон облегчит задачу по их добавлению, но при желании можно прописывать атрибуты отдельно, помня, что ALT необходим для поисковых систем. То есть в него желательно включать слова, по которым эту картинку должен найти пользователь.

Требования к хостингу с точки зрения SEO

Проблемы с индексацией страниц сайта могут возникнуть в результате некорректной работы хостинга. Отследить ошибки сайта можно в соответствующем отчете Яндекс.Метрики.

Отследить ошибки сайта можно в соответствующем отчете Яндекс.Метрики.

Переход на протокол HTTPS

Защищенный протокол воспринимается в качестве фактора ранжирования, поэтому следует рассмотреть переход сайта на него.

Использование протокола HTTP/2

Протокол HTTP/2 существенно ускоряет открытие сайтов за счет следующих особенностей:

- Соединения.

Несколько запросов могут быть отправлены через одно TCP-соединение, и ответы могут быть получены в любом порядке. Таким образом отпадает необходимость в том, чтобы держать несколько TCP-соединений.

Несколько запросов могут быть отправлены через одно TCP-соединение, и ответы могут быть получены в любом порядке. Таким образом отпадает необходимость в том, чтобы держать несколько TCP-соединений. - Приоритеты протоколов. Клиент может задавать серверу приоритеты — какого типа ресурсы для него важнее, чем другие.

- Сжатие заголовка. Размер заголовка HTTP может быть сокращен.

- Push-отправка данных со стороны сервера. Сервер может отправлять клиенту данные, которые тот еще не запрашивал. Например, на основании данных о том, какую страницу скорее всего откроет пользователь следующей.

Проверку можно провести при помощи сервиса.

Настройка кода ответа 304

Правильно настроенный сервер должен возвращать код 304 Not Modified, если клиент запросил документ методом GET, использовал заголовок If-Modified-Since или If-None-Match, и документ не изменился с указанного момента. При этом сообщение сервера не должно содержать тело страницы.

При этом сообщение сервера не должно содержать тело страницы.

Настройка заголовка нужна в первую очередь для снижения нагрузки на сервер и ускорения индексации страниц. Именно поэтому необходимо произвести настройку заголовка Last-Modified, особенно для крупных ресурсов с большим количеством страниц.

Подробней об этом можно прочитать в справках поисковых систем:

Цель этого заголовка — сообщить клиенту (браузеру или поисковику) информацию о последних изменениях конкретной страницы. Клиент передает серверу заголовок If-Modified-Since. Если изменений на странице не обнаружено, то от сервера возвращается заголовок «304 Not Modified». При этом страница не загружается.

При этом страница не загружается.

Проверить код ответа можно при помощи сервиса.

Выводы

К процессу технической оптимизации, как и к процессу продвижения в целом, не стоит подходить шаблонно. Любой проект индивидуален и даже самый обширный чек-лист не всегда способен охватить все рекомендации.

В данной статье я дал список наиболее распространенных технических проблем и привел пути их решения. Но стоит учитывать, что поисковые системы не стоят не месте, поэтому не исключаю, что спустя полгода или год этот список можно будет дополнить или сократить.

Рекомендация по теме

Чтобы быть в курсе последних наработок в области технической оптимизации, рекомендую послушать секцию «Техническое SEO» Сергея Кокшарова, автора самого популярного SEO-канала @DevakaTalk. Она пройдет в Сколково в конце октября в рамках Optimization.

Вопросы, которые Сергей планирует разобрать:

- Опыт внедрения AMP/Turbo страниц на коммерческом (не новостном) сайте.

- Опыт оптимизации SPA/PWA сайта.

- Опыт использования GeoIP редиректов.

- Максимизация видимости сайта продвинутыми техническими методами.

- Использование машинного обучения для SEO задач и другие эксперименты в области технической оптимизации.

Тег noindex. Как правильно пользоваться?

Многие из нас слышали о тегах noindex и nofollow, что ими пользуются, что-то там закрывают в коде страницы и вроде как это даже положительно сказывается на продвижении сайта в поисковой выдаче. Если Вы желаете избавиться от этих самых «что-то там» и «вроде как» в своем понимании использования этих тегов, то этот обзор для Вас.

В этой статье будут рассмотрены все тонкости использования noindex и к чему это в конечном итоге приводит оптимизаторов и «переоптимизаторов». В следующем обзоре мы также тщательно пройдемся по атрибуту nofollow, чтобы окончательно расставить все точки над «и» в использовании этих инструментов.

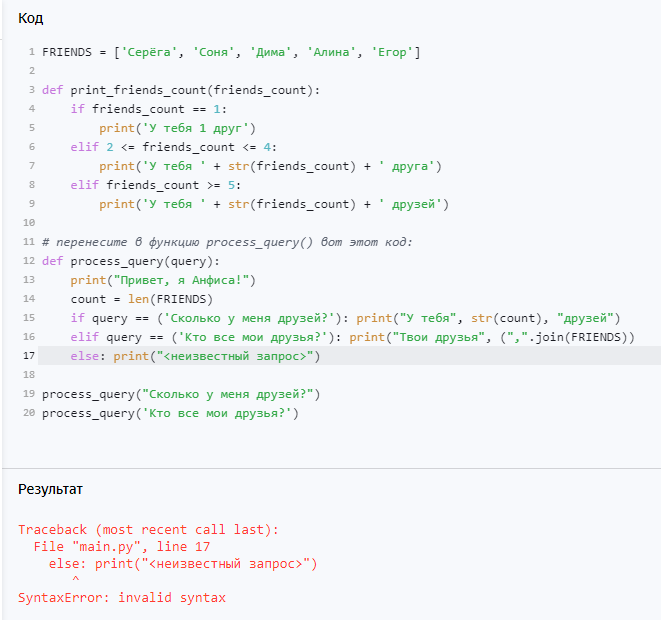

Как пользоваться?

В рекомендациях для вебмастеров от Яндекса предлагается для использования две версии данного тега.

Первый вариант:

<noindex>Закрытое к индексации содержимое</noindex>

Второй вариант:

<!--noindex-->Закрытое к индексации содержимое<!--/noindex-->

Отличие между ними только в том, что второй вариант валиден (не содержит в себе ошибки с точки зрения документации html). В остальном же оба варианта используются для скрытия от индексации поисковым роботом Яндекса (для гугла используются другие фишки) определенной части html кода страницы.

Пользоваться тегом noindex элементарно – достаточно просто заключить внутрь тега все содержание страницы, которое мы не хотим открывать поисковику.

Любопытным моментом также является то, что при его использовании не обязательно соблюдать принцип вложенности тегов html. Мы просто закрываем содержимое откуда хоти докуда хотим. Главное не забыть поставить закрывающий тег, иначе робот не увидит весь код страницы идущий после открывающего тега.

Особенности применения

- Тег noindex закрывает от индексации весь код содержащийся внутри него КРОМЕ картинок и ссылок. Это вызвано в первую очередь тем, что для них предусмотрено использование атрибута nofollow.

- Им СТОИТ пользоваться для скрытия кодов счетчиков сайта, форм подписок на рассылки, баннеров, часто повторяющегося контента (по типу цитат), слишком часто меняющихся фрагментов страницы, нецензурных выражений (рекомендация от авторов- вообще соблюдайте культуру речи и будет вам Добро).

- Бесполезно его использовать для скрытия только ссылок, рекламы от яндекс директ и гугл адсенс.

Осторожно, переоптимизация! Или вредные советы для вебмастеров.

Многие «умелые» оптимизаторы давно приспособили этот тег для удовлетворения своих изощренных желаний в продвижении страниц. Рассмотрим до чего можно дойти и почему этого делать не стоит:

- Исключая лишние фразы и куски текста из содержания страницы можно изменять сниппеты (описания сайта в поисковой выдаче) по своему желания.

Помимо глобальной потери времени этот подход еще грозит санкциями от поисковой системы, которая при «осознании» факта мошенничества вполне может ответить санкциями к и злишне ретивому мастеру.

Помимо глобальной потери времени этот подход еще грозит санкциями от поисковой системы, которая при «осознании» факта мошенничества вполне может ответить санкциями к и злишне ретивому мастеру. - Если сниппеты для Вас это лишь детский сад, то можно пойти и дальше. А давайте покажем каждому поисковику свое содержание страницы? С учетом того, что noindex работает только в Яше, то достичь этой цели достаточно просто. Даже не знаю стоит ли писать что делают Гугле и Яндекс с теми, кого поймали на манипулировании алгоритмами поиска?

- Если в тексте использовано слишком много ключевых слов, то можно лишние ключи поскрывать этим тегом. Только почему не потратить это время на простое приведение текста в порядок? Вопрос для размышления. Таким подходом мы добиваемся: А- того, что текст остается заспамленным для пользователей ресурса; Б- яндекс не дурак и отлично понимает когда его пытаются обмануть, потому страницы с слишком часто используемым тегом noindex достаточно быстро «проваливаются» в поисковой выдаче.

Подводя итоги

Как noindex не крути, а он по-прежнему остается инструментом не белой, а серой оптимизации сайта. Не взирая на оправданность его использования во многих ситуациях, помните, что алгоритмы поисковых систем продолжают активно развиваться и поисковик и так понимает что и где у сайта расположено, хоть пока и не придает этому особого значения.

Из минусов также можно отметить то, что после появления поддержки в Яше атрибута nofollow весь рунет ожидает прекращения поддержки noindex. На сегодняшний день о этом ничего не слышно, но прельщаться этим не стоит.

Оценок: 3 (средняя 5 из 5)

Понравилась статья? Расскажите о ней друзьям:

Еще интересное

Как определить закрыта или нет ссылка тегами «nofollow»и «noindex»

Кто занимается оптимизацией и продвижением сайтов, кому важны показатели тИЦ и PR, используют в своей работе со ссылками теги и атрибуты «nofollow» и «noindex».

В основном они применяются для уменьшения передачи веса на другие сайты. Закрывая индексацию ссылок в поисковых системах, в конечном счёте для повышения показателей ТиЦ и PR своего сайта. Для чего они нужны и как применяются читайте как правильно использовать noindex и nofollow

В связи с этим часто возникает необходимость быстро определить заключена ли ссылка в теги, закрыта или нет. Это можно сделать несколькими способами, но я для этих целей использую плагин RDS Bar.

С помощью этого плагина можно быстро просмотреть многие характеристики сайта, и в том числе сразу увидеть статус ссылок — какие ссылки в какие теги заключены, закрыты ссылки или нет от индексации в поисковиках.

Установка и настройка плагина

Скачайте на компьютер и установите плагин, перейдя по ссылке: https://addons.mozilla.org/ru/firefox/addon/rds-bar/

В правом верхнем углу панелей управления браузером появиться значок

(цифра 10 — означает показатель тиц сайта, как получить жирные ссылки на сайт бесплатно)

Нажмите на значок левой кнопкой мыши, откроется окно где вы увидите многие параметры сайта и страницы на которой находитесь. Таким образом вы сможете просматривать многие данные сайтов.

Таким образом вы сможете просматривать многие данные сайтов.

Далее нажмите правой кнопкой мыши по значку, откроется вкладка настроек и управления плагином.

Теперь откройте пункт настройки.

В этом окне можно настроить различные функции плагина RDS Bar.

Нужно ли выводить данные сразу в поисковых системах при поиске сайтов, а также настроить какие показатели будут запрошены.

Но нас интересуют параметры ссылок, поэтому идём вниз в настройки «Подсветка на страницах».

Здесь выбираем, как будут выделяться на сайте ссылки, а так же картинки которые имеют ссылки с различными тегами и статусами.

Выберите и установите цвет, рамку, зачёркивать или другое на ваш выбор: для ссылок с тегом «noindex»и атрибутом «nofollow».

Поэкспериментируйте, найдите удобный для себя вариант.

Теперь, открывая любую страницу любого сайта, вы быстро и сразу увидите статус находящихся здесь ссылок, индексируются ли они в поисковых системах и в какие теги заключены.

Удачи в делах!

- < Назад

- Вперёд >

Noindex, nofollow — чек лист для работы

Noindex и nofollow зачастую называют некорректно: тегами, метатегами, атрибутами. На самом деле noindex — это тег, а nofollow — атрибут внутри тега.

Метатеги — это теги, которые относятся ко всей странице: <meta name=»robots» content=»noindex, nofollow» />

Тег <noindex> создает конструкцию: <noindex> … </noindex>;

атрибут rel=”nofollow” может появляться в конструкции тега.

С помощью этих параметров можно и нужно указывать поисковым роботам Google, Яндекс или других систем, как именно нужно взаимодействовать с контентом, находящимся внутри этих параметров.

Где и как использовать noindex и nofollow

Эти атрибуты могут располагаться в заголовке страницы, и тогда они будут правилом для всего контента. А могут ограждать конкретный текстовый фрагмент, ссылку или изображение.

Для страниц метатеги noindex и nofollow закрывают от индексации:

- страницы регистрации;

- служебные страницы;

- страницы авторов комментариев;

- другие «вредные» для индексации страницы;

Для контента теги noindex и атрибут nofollow закрывают от индексации:

- «вредные» ссылки;

- цитаты из различных источников;

- повторяющийся контент

Чтобы закрыть от индексации страницы — метатеги noindex и nofollow

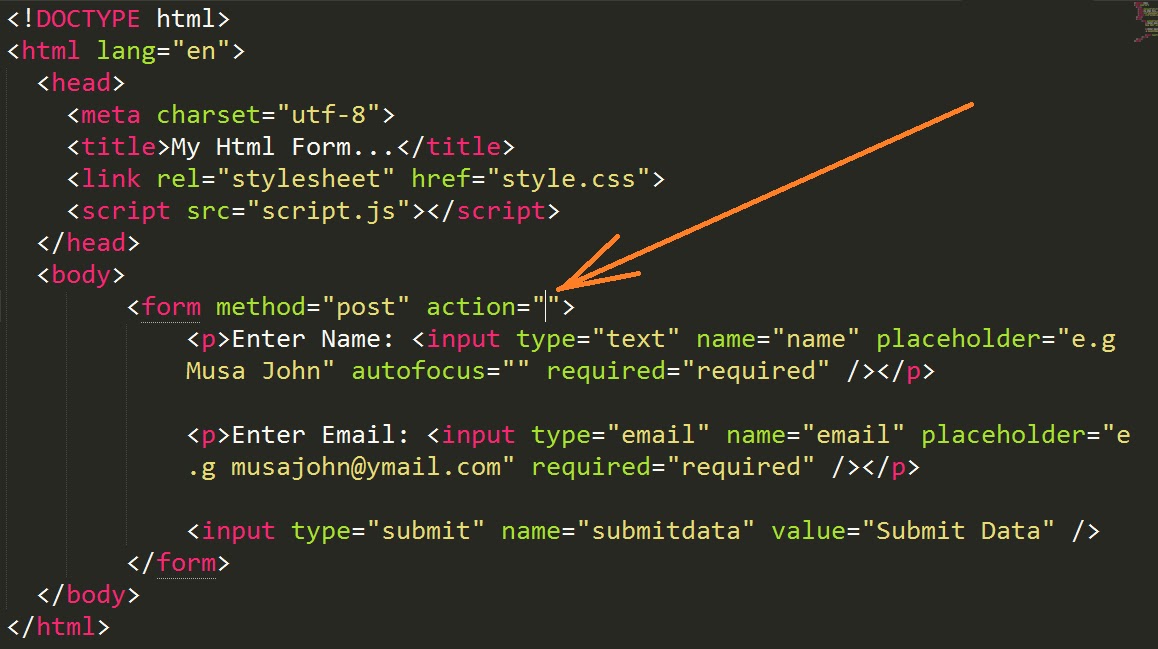

Когда нужно чтобы страница и контент на ней индексировались, а поисковый робот не переходил по ссылкам. В таком случае используем конструкцию:

<meta name="robots" content="index, nofollow"/>

Когда надо закрыть страницу от индексации, а переходы по ссылкам разрешить, вставляем

<meta name="robots" content="noindex, follow"/>

Чтобы индексировались и ссылки, и сама страница, в заголовке применяем метатег

<meta name="robots" content="index, follow"/>

Для полного закрытия страницы и ссылок на ней от индексации:

<meta name="robots" content="noindex, nofollow"/>

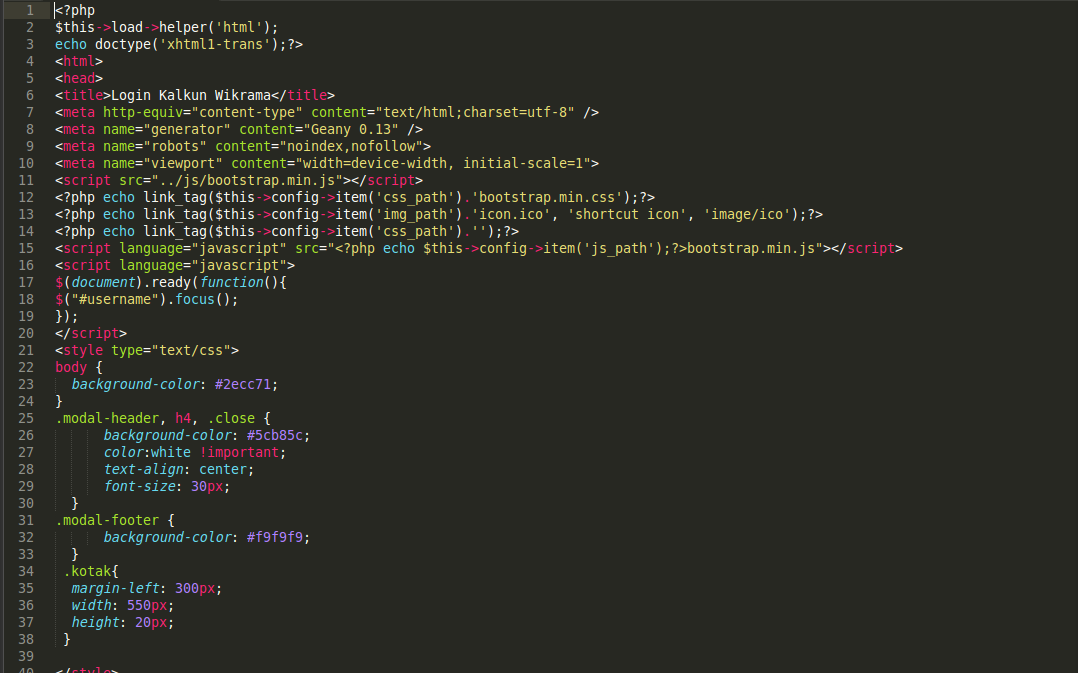

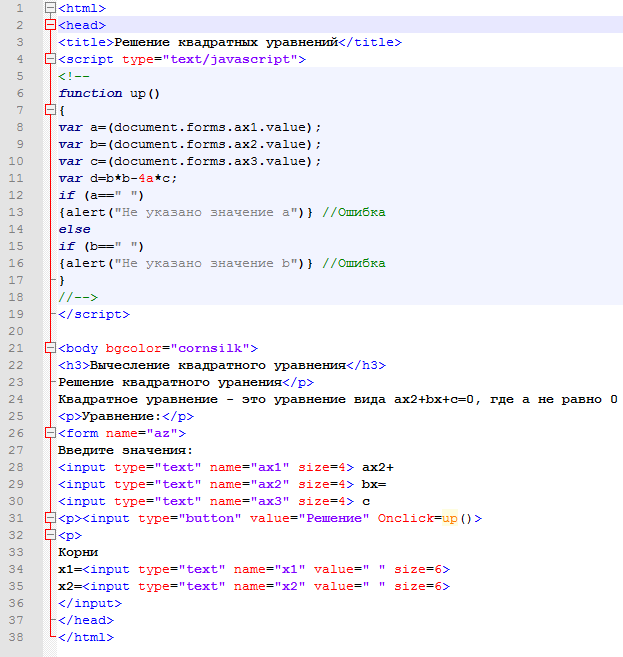

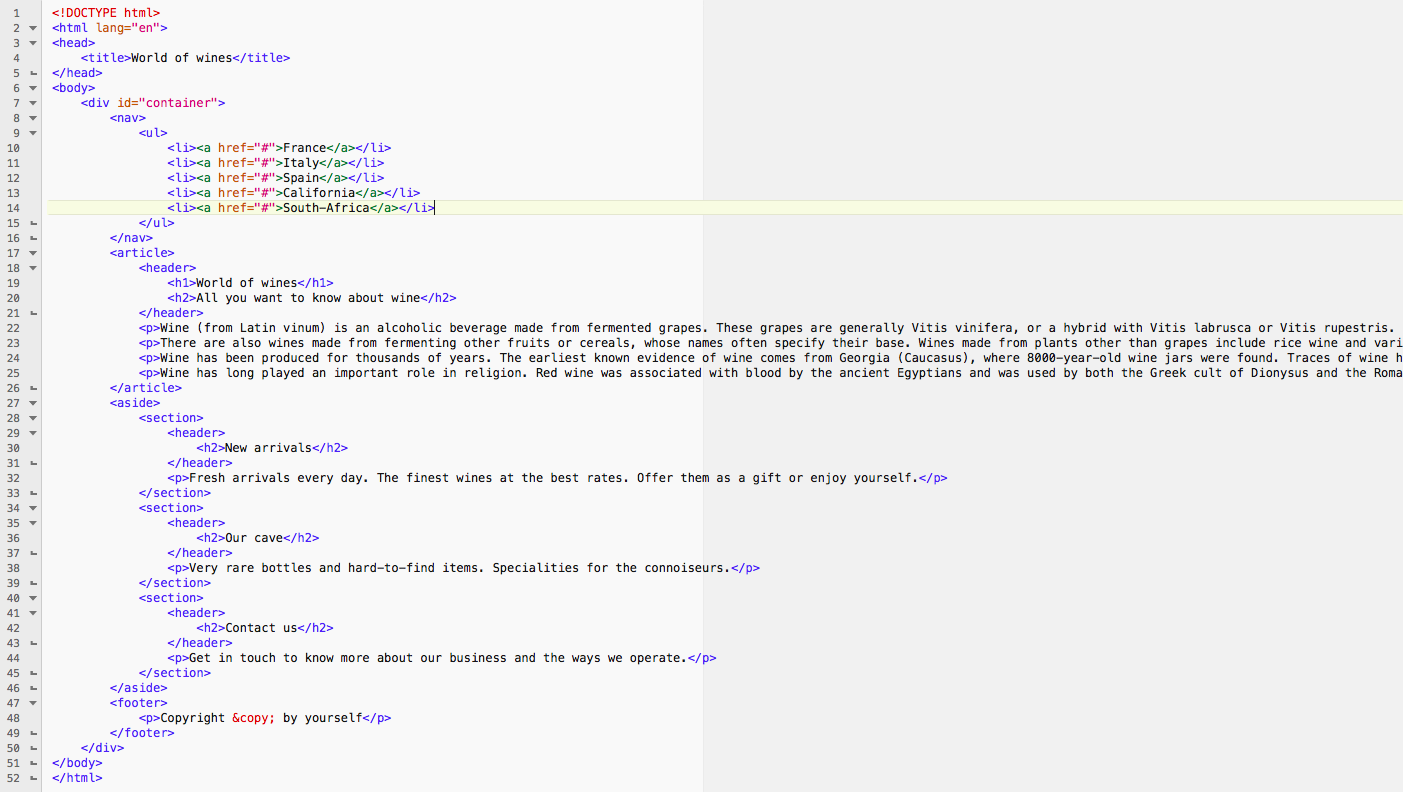

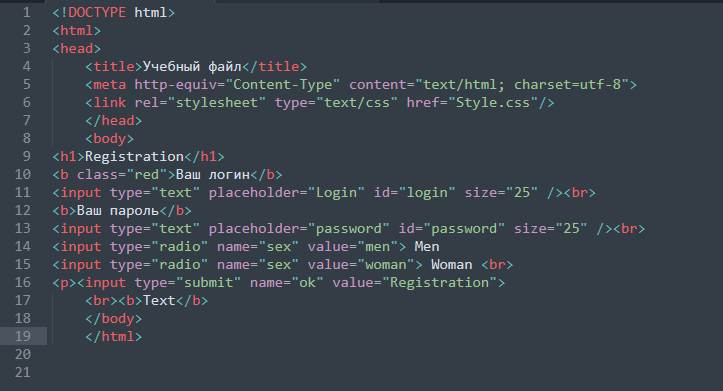

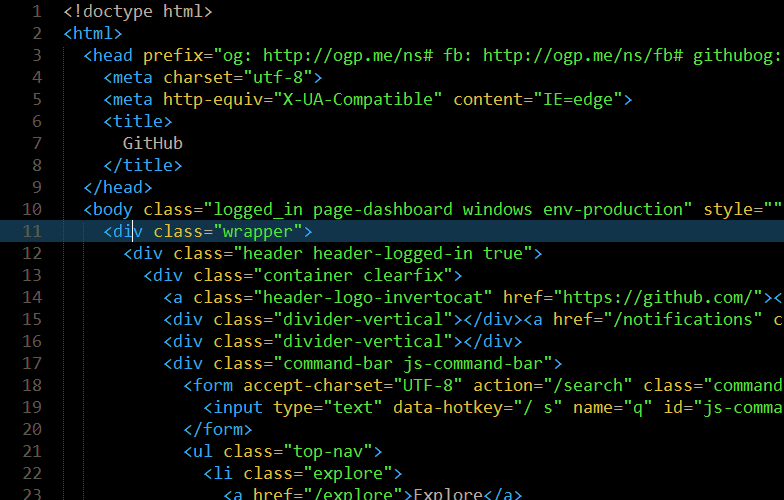

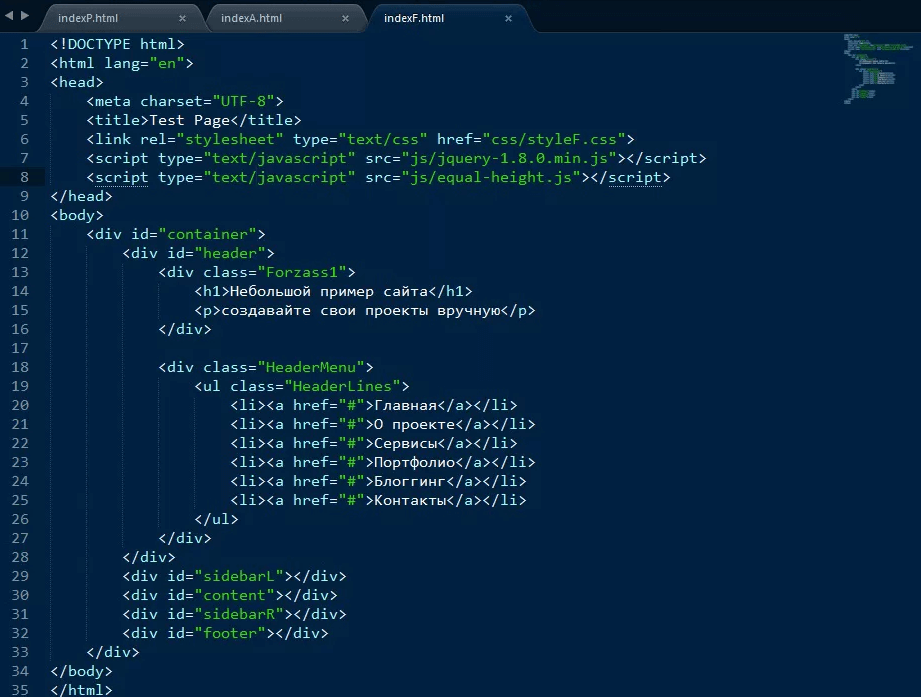

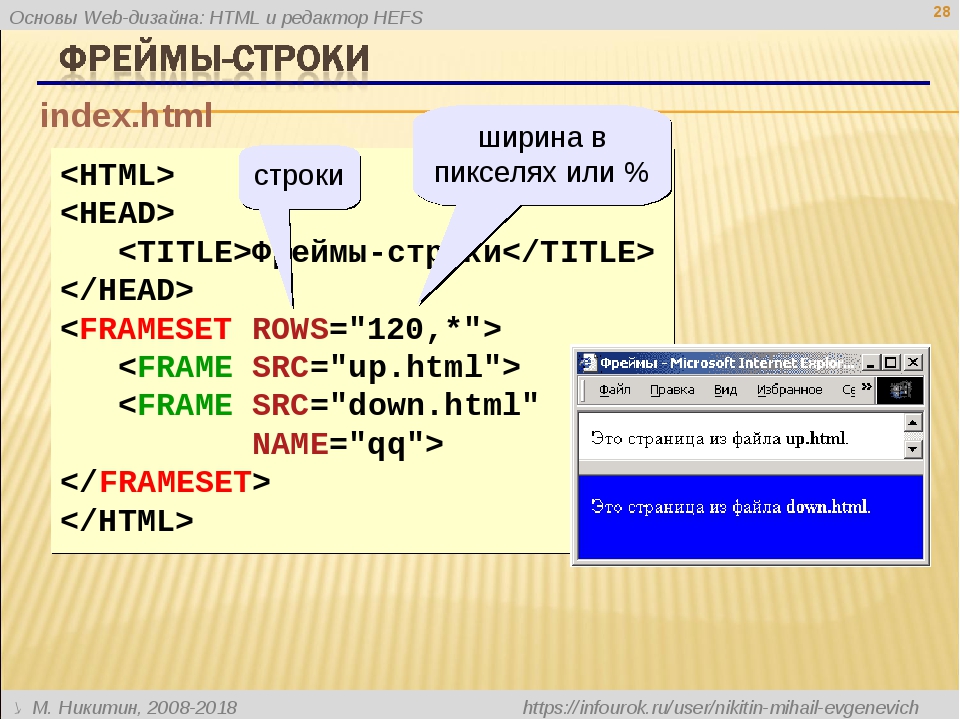

Для примера приведем заголовок страницы, в которой используются метатеги с полным закрытием страницы и ссылок для индексации ее роботом поисковой системы (noindex, nofollow):

<html> <head> <meta name="robots" content="noindex,nofollow"> <meta name="description" content="Description для данной странички"> <title>…</title> </head> <body>

Для контента и ссылок тег noindex и атрибут nofollow

Чтобы скрыть от индексации фрагмент текста (работает только для Яндекс и Рамблер), используем следующее решение:

<!--noindex--> (текст, который нужно скрыть) <!--/noindex-->

Чтобы скрыть от индексации ссылку, используем:

<a href="https://mysite.com/" rel="nofollow">Текст ссылки </a>

Чтобы скрыть ссылку от индексации и Яндекс, и Google, применяем

<noindex><a href="http://mysite.com/" rel="nofollow">текст ссылки</a></noindex>

Google в данной конструкции принимает только rel=»nofollow», а для Яндекса действуют и noindex, и rel=»nofollow».

<noindex> — неофициальный тег

<noindex>…</noindex> используется поисковыми системами Яндекс и Rambler. Цель — скрыть от индексации указанный контент.

Google на данный тег не обращает внимание, ибо он не является принятым тегом разметки html.

rel=”nofollow” — атрибут внутри тега ссылки

rel=”nofollow” запрещает поисковым системам переходить по указанной ссылке. Конструкция:

<a href="signin.php" rel="nofollow">Войти</a>

Как сообщается в ответе поддержки Google для веб-мастеров, поисковая система не переходит по ссылке и не использует для перехода по ней краулинговый бюджет. Но это не значит, что робот туда не заглянет и не проверит. То есть дальнейшая судьба данной ссылки такая: мы про тебя знаем, но молчим, пока это безопасно.

Но это не значит, что робот туда не заглянет и не проверит. То есть дальнейшая судьба данной ссылки такая: мы про тебя знаем, но молчим, пока это безопасно.

Если нужно скрыть от индексации страницы только для Google, можно использовать <meta name=»googlebot» content=»noindex» />.

Если нужно закрыть от индексации только для Яндекс – <meta name=»yandex» content=»noindex»/>.

Закрытие индексации через файл robots.txt

Метатеги, описанные ранее <meta name=»robots» content=»noindex, nofollow»> появляются только после открытия роботом страницы и прочтения заголовка.

Закрытие же страницы через файл robots.txt запрещает даже заходить на страницу.

Если поисковая система раньше проиндексировала эту страницу, то она будет находится в индексе поисковых систем (даже после закрытия в файле robots.txt). А в description нам сообщат, что описание для данной страницы отобразить невозможно, ведь она закрыта от индексации в файле robots. txt.

txt.

# robots.txt for http://www.w3.org/ User-agent: W3C-gsa Disallow: /Out-Of-Date User-agent: W3T_SE Disallow: /Out-Of-Date User-agent: Mozilla/4.0 (compatible; MSIE 6.0; Windows NT; MS Search 4.0 Robot) Disallow: / # W3C Link checker User-agent: W3C-checklink Disallow: User-agent: Applebot Disallow: /People/domain/ # the following settings apply to all bots User-agent: * # Blogs - WordPress # https://codex.wordpress.org/Search_Engine_Optimization_for_WordPress#Robots.txt_Optimization Disallow: /*/wp-admin/ Disallow: /*/wp-includes/ Disallow: /*/wp-content/plugins/ Disallow: /*/wp-content/cache/ Disallow: /*/wp-content/themes/ Disallow: /blog/*/trackback/ Disallow: /blog/*/feed/ Disallow: /blog/*/comments/ Disallow: /blog/*/category/*/* Disallow: /blog/*/*/trackback/ Disallow: /blog/*/*/feed/ Disallow: /blog/*/*/comments/ Disallow: /blog/*/*?

Поэтому для непроиндексированных страниц можно использовать как вариант закрытия через метатеги в заголовке, так и через файл роботс. тхт.

тхт.

Если страница уже была проиндексирована, рекомендуем вставить в заголовок, в секцию <head> метатег <meta name=»robots» content=»noindex, nofollow» />. Это исключит ее из индексации и предотвратит последующее попадание в нее.

В данном файле есть несколько блоков. Первый — User-agent — команда для определения робота, к которому относится последующие директивы. В коде файла роботс.тхт, что представлен выше — для робота W3C-gsa, W3T_SE, Mozilla/4.0, W3C-checklink, Applebot. А звездочка ( * ) после команды User-agent — говорит что последующие директивы относятся ко всем поисковым роботам.В большинстве случаев нам понадобиться заголовок в файле robots.txt следующего стандартного вида:

User-agent: * # applies to all robots

Последующие директивы позволяют исключить как отдельные страницы, так и целые папки со страницами. Код будет выглядеть так:

Disallow: / # disallow indexing of all pages

В случае, если в данной папке есть одна или несколько страниц, которые должны быть проиндексированы поступаем следующим образом:

User-agent: * Disallow: /help #запрещает страницы к индексированию, которые находятся в каталоге, например: /help.html и /help/index.html Disallow: /help/ #запрещает только те страницы, которые находятся на уровень ниже каталога help, а те, что в этом каталоге - остаются открытыми, например: /help/index.html закрыт, но /help.html - открыт

В файле robots.txt обязательно должно быть хотя бы одно поле Disallow. Как же поступить если нам не нужно закрывать ни одной страницы? Оставляем поле пустым:

Disallow: #если после директивы оставить поле пустым - считается что все страницы сайта остаются открытыми для индексирования

Распространенные ошибки:

- Попытка закрыть от индексации ссылку следующей комбинацией: <nofollow><a href=»index.php»>Перейти</a></nofollow>

- Попытка закрыть ссылку от индексации с помощью тега <noindex>. Таким образом можно закрыть только анкор (текст ссылки, а не саму ссылку), и только для Яндекс.

Тег <noindex> для разметки html является неофициальным; в официальной разметке есть только атрибут rel или метатег со значением nofollow.

Выводы

Для экономии краулингового бюджета важно закрывать от индексации лишние ссылки, вес которых не существенен для продвижения.

Для поисковых систем ссылки nofolow выглядят естественно, а их наличие является нормальным. Однако большое количество исходящих ссылок на сайте может оказаться и минусом, несмотря на то, что они были закрыты от индексации.

Заказать сайт

Руководство по метатегам Robots и X-robots-tag

Перед вами дополненный (конечно же, выполненный с любовью) перевод статьи Robots Meta Tag & X-Robots-Tag: Everything You Need to Know c блога Ahrefs. Дополненный, потому что в оригинальном материале «Яндекс» упоминается лишь вскользь, а в главе про HTTP-заголовки затрагивается только сервер Apache. Мы дополнили текст информацией по метатегам «Яндекса», а в части про X-Robots-Tag привели примеры для сервера Nginx. Так что этот перевод актуален для наиболее популярных для России поисковых систем и веб-серверов. Круто, правда?

Круто, правда?

Приятного чтения!

Направить поисковые системы таким образом, чтобы они сканировали и индексировали ваш сайт именно так, как вы того хотите, порой может быть непросто. Хоть robots.txt и управляет доступностью вашего контента для ботов поисковых систем, он не указывает краулерам на то, стоит индексировать страницы или нет.

Для этой цели существуют метатеги robots и HTTP-заголовок X-Robots-Tag.

Давайте проясним одну вещь с самого начала: вы не можете управлять индексацией через robots.txt. Распространенное заблуждение — считать иначе.

Правило noindex в robots.txt официально никогда не поддерживалось Google. 2 июля 2019 года Google опубликовал новость, в которой описал нерелевантные и неподдерживаемые директивы файла robots.txt. С 1 сентября 2019 года такие правила, как noindex в robots.txt, официально не поддерживаются.

Из этого руководства вы узнаете:

- что такое метатег robots;

- почему robots важен для поисковой оптимизации;

- каковы значения и атрибуты метатега robots;

- как внедрить robots;

- что такое X-Robots-Tag;

- как внедрить X-Robots-Tag;

- когда нужно использовать метатег robots, а когда — X-Robots-Tag;

- как избежать ошибок индексации и деиндексации.

Что такое метатег robots

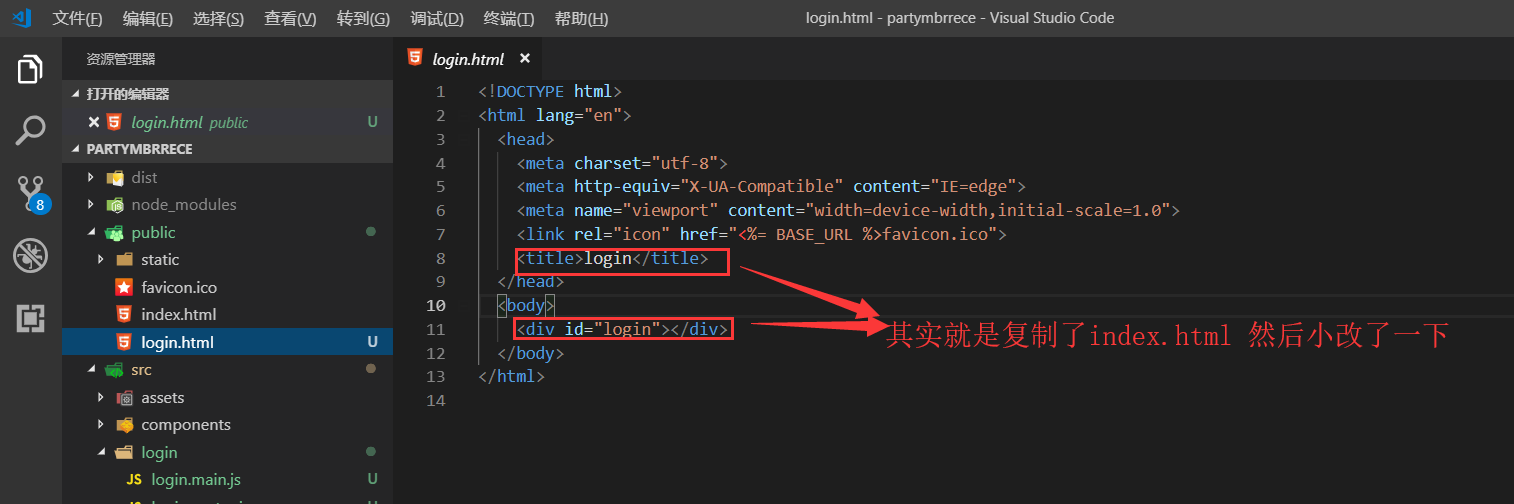

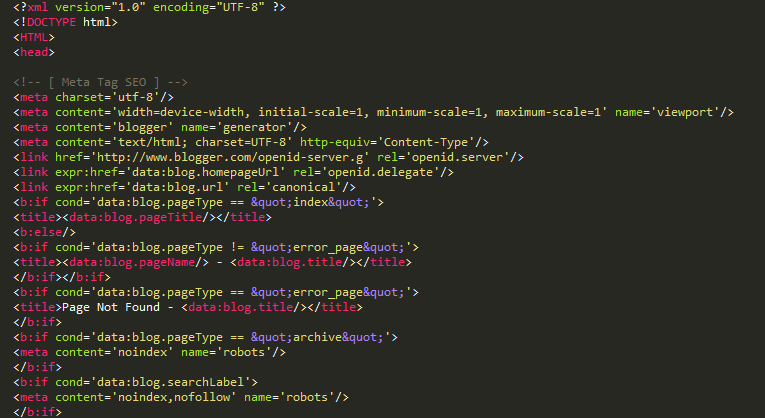

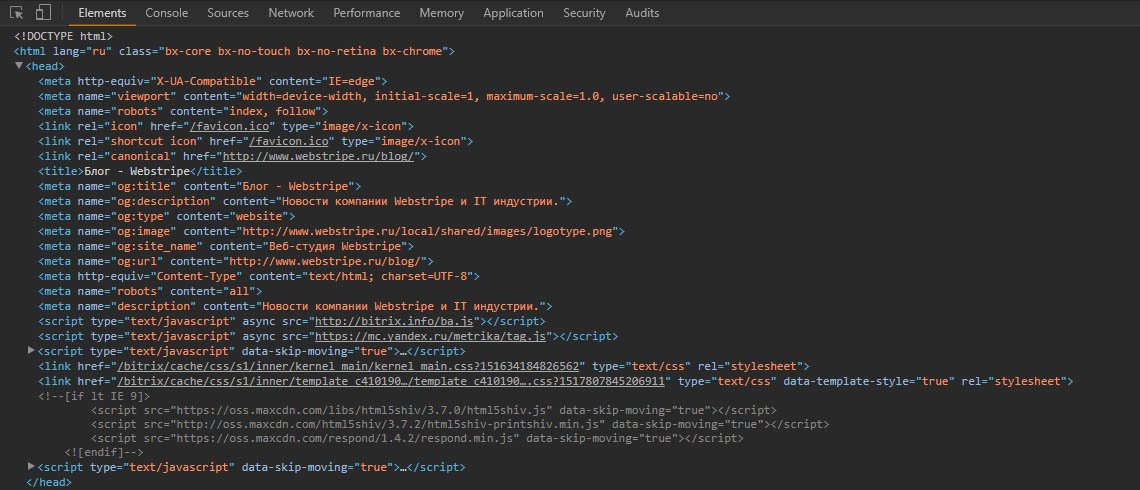

Это фрагмент HTML-кода, который указывает поисковым системам, как сканировать и индексировать определенную страницу. Robots помещают в контейнер <head> кода веб-страницы, и выглядит это следующим образом:

<meta name="robots" content="noindex" />

Почему метатег robots важен для SEO

Метатег robots обычно используется для того, чтобы предотвратить появление страниц в выдаче поисковых систем. Хотя у него есть и другие возможности применения, но об этом позже.

Есть несколько типов контента, который вы, вероятно, хотели бы закрыть от индексации поисковыми системами. В первую очередь это:

- страницы, ценность которых крайне мала для пользователей или отсутствует вовсе;

- страницы на стадии разработки;

- страницы администратора или из серии «спасибо за покупку!»;

- внутренние поисковые результаты;

- лендинги для PPC;

- страницы с информацией о грядущих распродажах, конкурсах или запуске нового продукта;

- дублированный контент.

Не забывайте настраивать тег canonical для того, чтобы предоставить поисковым системам наилучшую версию для индексации.

Не забывайте настраивать тег canonical для того, чтобы предоставить поисковым системам наилучшую версию для индексации.

В общем, чем больше ваш веб-сайт, тем больше вам придется поработать над управлением краулинговой доступностью и индексацией. Еще вы наверняка хотели бы, чтобы Google и другие поисковые системы сканировали и индексировали ваш сайт с максимально возможной эффективностью. Да? Для этого нужно правильно комбинировать директивы со страницы, robots.txt и sitemap.

Какие значения и атрибуты есть у метатега robots

Метатег robots содержит два атрибута: name и content.

Следует указывать значения для каждого из этих атрибутов. Их нельзя оставлять пустыми. Давайте разберемся, что к чему.

Атрибут name и значения user-agent

Атрибут name уточняет, для какого именно бота-краулера предназначены следующие после него инструкции. Это значение также известно как user-agent (UA), или «агент пользователя». Ваш UA отражает то, какой браузер вы используете для просмотра страницы, но вот у Google UA будет, например, Googlebot или Googlebot-image.

Ваш UA отражает то, какой браузер вы используете для просмотра страницы, но вот у Google UA будет, например, Googlebot или Googlebot-image.

Значения user-agent, robots, относится только к ботам поисковых систем. Цитата из официального руководства Google:

Тег

<meta name="robots" content="noindex" />и соответствующая директива применяются только к роботам поисковых систем. Чтобы заблокировать доступ другим поисковым роботам, включая AdsBot-Google, возможно, потребуется добавить отдельные директивы для каждого из них, например<meta name="AdsBot-Google" content="noindex" />.

Вы можете добавить столько метатегов для различных роботов, сколько вам нужно. Например, если вы не хотите, чтобы картинки с вашего сайта появлялись в поисковой выдаче Google и Bing, то добавьте в шапку следующие метатеги:

<meta name="googlebot-image" content="noindex" /><meta name="MSNBot-Media" content="noindex" />

Примечание: оба атрибута — name и content — нечувствительны к регистру. То есть абсолютно не важно, напишите ли вы их с большой буквы или вообще ЗаБоРчИкОм.

То есть абсолютно не важно, напишите ли вы их с большой буквы или вообще ЗаБоРчИкОм.

Атрибут content и директивы сканирования и индексирования

Атрибут content содержит инструкции по поводу того, как следует сканировать и индексировать контент вашей страницы. Если никакие метатеги не указаны или указаны с ошибками, и бот их не распознал, то краулеры расценят гнетущую тишину их отсутствия как «да», т. е. index и follow. В таком случае страница будет проиндексирована и попадет в поисковую выдачу, а все исходящие ссылки будут учтены. Если только ссылки непосредственно не завернуты в тег rel=»nofollow» .

Ниже приведены поддерживаемые значения атрибута content.

all

Значение по умолчанию для index, follow. Вы спросите: зачем оно вообще нужно, если без этой директивы будет равным образом то же самое? И будете чертовски правы. Нет абсолютно никакого смысла ее использовать. Вообще.

<meta name="robots" content="all" />

noindex

Указывает ПС на то, что данную страницу индексировать не нужно. Соответственно, в SERP она не попадет.

Соответственно, в SERP она не попадет.

<meta name="robots" content="noindex" />

nofollow

Краулеры не будут переходить по ссылкам на странице, но следует заметить, что URL страниц все равно могут быть просканированы и проиндексированы, в особенности если на них ведут внешние ссылки.

<meta name="robots" content="nofollow" />

none

Комбинация noindex и nofollow как кофе «два в одном». Google и Yandex поддерживают данную директиву, а вот, например, Bing — нет.

<meta name="robots" content="none" />

noarchive

Предотвращает показ кешированной версии страницы в поисковой выдаче.

<meta name="robots" content="noarchive" />

notranslate

Говорит Google о том, что ему не следует предлагать перевод страницы в SERP. «Яндексом» не поддерживается.

<meta name="robots" content="notranslate" />

noimageindex

Запрещает Google индексировать картинки на странице. «Яндексом» не поддерживается.

<meta name="robots" content="noimageindex" />

Указывает Google на то, что страницу нужно исключить из поисковой выдачи после указанной даты или времени. В целом это отложенная директива noindex с таймером. Бомба деиндексации с часовым механизмом, если изволите. Дата и время должны быть указаны в формате RFC 850. Если время и дата указаны не будут, то директива будет проигнорирована. «Яндекс» ее тоже не знает.

<meta name="robots" content="unavailable_after: Sunday, 01-Sep-19 12:34:56 GMT" />

nosnippet

Отключает все текстовые и видеосниппеты в SERP. Кроме того, работает и как директива noarchive. «Яндексом» не поддерживается.

<meta name="robots" content="nosnippet" />

Важное примечание

С октября 2019 года Google предлагает более гибкие варианты управления отображением сниппетов в поисковой выдаче. Сделано это в рамках модернизации авторского права в Евросоюзе. Франция стала первой страной, которая приняла новые законы вместе со своим обновленным законом об авторском праве.

Новое законодательство хоть и введено только в Евросоюзе, но затрагивает владельцев сайтов повсеместно. Почему? Потому что Google больше не показывает сниппеты вашего сайта во Франции (пока только там), если вы не внедрили на страницы новые robots-метатеги.

Мы описали каждый из нововведенных тегов ниже. Но вкратце: если вы ищете быстрое решение для исправления сложившейся ситуации, то просто добавьте следующий фрагмент HTML-кода на каждую страницу сайта. Код укажет Google на то, что вы не хотите никаких ограничений по отображению сниппетов. Поговорим об этом более подробно далее, а пока вот:

Поговорим об этом более подробно далее, а пока вот:

<meta name="robots" content=”max-snippet:-1, max-image-preview:large, max-video-preview:-1" />

Заметьте, что если вы используете Yoast SEO, этот фрагмент кода уже добавлен на все ваши страницы, при условии, что они не отмечены директивами noindex или nosnippet.

Нижеуказанные директивы не поддерживаются ПС «Яндекс».

max-snippet

Уточняет, какое максимальное количество символов Google следует показывать в своих текстовых сниппетах. Значение «0» отключит отображение текстовых сниппетов, а значение «-1» укажет на то, что верхней границы нет.

Вот пример тега, указывающего предел в 160 символов (стандартная длина meta description):

<meta name="robots" content="max-snippet:160" />

max-image-preview

Сообщает Google, какого размера картинку он может использовать при отображении сниппета и может ли вообще. Есть три опции:

Есть три опции:

- none — картинки в сниппете не будет вовсе;

- standart — в сниппете появится (если появится) картинка обыкновенного размера;

- large — может быть показана картинка максимального разрешения из тех, что могут влезть в сниппет.

<meta name="robots" content="max-image-preview:large" />

max-video-preview

Устанавливает максимальную продолжительность видеосниппета в секундах. Аналогично текстовому сниппету значение «0» выключит опцию показа видео, значение «-1» укажет, что верхней границы по продолжительности видео не существует.

Например, вот этот тег скажет Google, что максимально возможная продолжительность видео в сниппете — 15 секунд:

<meta name="robots" content="max-video-preview:15" />

noyaca

Запрещает «Яндексу» формировать автоматическое описание с использованием данных, взятых из «Яндекс. Каталога». Для Google не поддерживается.

Каталога». Для Google не поддерживается.

Примечание относительно использования HTML-атрибута data-nosnippet

Вместе с новыми директивами по метатегу robots, представленными в октябре 2019 года, Google также ввел новый HTML-атрибут data-nosnippet. Атрибут можно использовать для того, чтобы «заворачивать» в него фрагменты текста, который вы не хотели бы видеть в качестве сниппета.

Новый атрибут может быть применен для элементов <div>, <span> и <section>. Data-nosnippet — логический атрибут, то есть он корректно функционирует со значениями или без них.

Вот два примера:

<p>Фрагмент этого текста может быть показан в сниппете <span data-nosnippet>за исключением этой части.</span></p><div data-nosnippet>Этот текст не появится в сниппете.</div><div data-nosnippet="true">И этот тоже.

</div>

</div>

Использование вышеуказанных директив

В большинстве случаев при поисковой оптимизации редко возникает необходимость выходить за рамки использования директив noindex и nofollow, но нелишним будет знать, что есть и другие опции.

Вот таблица для сравнения поддержки различными ПС упомянутых ранее директив.

| Директива | «Яндекс» | Bing | |

|---|---|---|---|

| all | ✅ | ✅ | ❌ |

| noindex | ✅ | ✅ | ✅ |

| nofollow | ✅ | ✅ | ✅ |

| none | ✅ | ✅ | ❌ |

| noarchive | ✅ | ✅ | ✅ |

| nosnippet | ✅ | ❌ | ✅ |

| max-snippet | ✅ | ❌ | ❌ |

| max-snippet-preview | ✅ | ❌ | ❌ |

| max-video-preview | ✅ | ❌ | ❌ |

| notranslate | ✅ | ❌ | ❌ |

| noimageindex | ✅ | ❌ | ❌ |

| unavailable_after: | ✅ | ❌ | ❌ |

| noyaca | ❌ | ✅ | ❌ |

| index|follow|archive | ✅ | ✅ | ✅ |

Вы можете сочетать различные директивы.

И вот здесь очень внимательно

Если директивы конфликтуют друг с другом (например, noindex и index), то Google отдаст приоритет запрещающей, а «Яндекс» — разрешающей директиве. То есть боты Google истолкуют такой конфликт директив в пользу noindex, а боты «Яндекса» — в пользу index.

Примечание: директивы, касающиеся сниппетов, могут быть переопределены в пользу структурированных данных, позволяющих Google использовать любую информацию в аннотации микроразметки. Если вы хотите, чтобы Google не показывал сниппеты, то измените аннотацию соответствующим образом и убедитесь, что у вас нет никаких лицензионных соглашений с ПС, таких как Google News Publisher Agreement, по которому поисковая система может вытягивать контент с ваших страниц.

Как настроить метатеги robots

Теперь, когда мы разобрались, как выглядят и что делают все директивы этого метатега, настало время приступить к их внедрению на ваш сайт.

Как уже упоминалось выше, метатегам robots самое место в head-секции кода страницы. Все, в принципе, понятно, если вы редактируете код вашего сайта через разные HTML-редакторы или даже блокнот. Но что делать, если вы используете CMS (Content Management System, в пер. — «система управления контентом») со всякими SEO-плагинами? Давайте остановимся на самом популярном из них.

Внедрение метатегов в WordPress с использованием плагина Yoast SEO

Тут все просто: переходите в раздел Advanced и настраивайте метатеги robots в соответствии с вашими потребностями. Вот такие настройки, к примеру, внедрят на вашу страницу директивы noindex, nofollow:

Строка meta robots advanced дает вам возможность внедрять отличные от noindex и nofollow директивы, такие как max-snippet, noimageindex и так далее.

Еще один вариант — применить нужные директивы сразу по всему сайту: открывайте Yoast, переходите в раздел Search Appearance. Там вы можете указать нужные вам метатеги robots на все страницы или на выборочные, на архивы и структуры сайта.

Там вы можете указать нужные вам метатеги robots на все страницы или на выборочные, на архивы и структуры сайта.

Примечание: Yoast — вовсе не единственный способ управления вашим метатегами в CMS WordPress. Есть альтернативные SEO-плагины со сходным функционалом.

Что такое X-Robots-Tag

Метатеги robots замечательно подходят для того, чтобы закрывать ваши HTML-страницы от индексирования, но что делать, если, например, вы хотите закрыть от индексирования файлы типа изображений или PDF-документов? Здесь в игру вступает X-Robots-Tag.

X-Robots-Tag — HTTP-заголовок, но, в отличие от метатега robots, он находится не на странице, а непосредственно в файле конфигурации сервера. Это позволяет ему сообщать ботам поисковых систем инструкции по индексации страницы даже без загрузки содержимого самой страницы. Потенциальная польза состоит в экономии краулингового бюджета, так как боты ПС будут тратить меньше времени на интерпретацию ответа страницы, если она, например, будет закрыта от индексации на уровне ответа веб-сервера.

Вот как выглядит X-Robots-Tag:

Чтобы проверить HTTP-заголовок страницы, нужно приложить чуть больше усилий, чем требуется на проверку метатега robots. Например, можно воспользоваться «дедовским» методом и проверить через Developer Tools или же установить расширение на браузер по типу Live HTTP Headers.

Последнее расширение мониторит весь HTTP-трафик, который ваш браузер отправляет (запрашивает) и получает (принимает ответы веб-серверов). Live HTTP Headers работает, так сказать, в прямом эфире, так что его нужно включать до захода на интересующий сайт, а уже потом смотреть составленные логи. Выглядит все это следующим образом:

Как правильно внедрить X-Robots-Tag

Конфигурация установки в целом зависит от типа используемого вами сервера и того, какие страницы вы хотите закрыть от индексирования.

Строчка искомого кода для веб-сервера Apache будет выглядеть так:

Header set X-Robots-Tag «noindex»Для nginx — так:

add_header X-Robots-Tag «noindex, noarchive, nosnippet»;

Наиболее практичным способом управления HTTP-заголовками будет их добавление в главный конфигурационный файл сервера. Для Apache обычно это httpd.conf или файлы .htaccess (именно там, кстати, лежат все ваши редиректы). Для nginx это будет или nginx.conf, где лежат общие конфигурации всего сервера, или файлы конфигурации отдельных сайтов, которые, как правило, находятся по адресу etc/nginx/sites-available.

Для Apache обычно это httpd.conf или файлы .htaccess (именно там, кстати, лежат все ваши редиректы). Для nginx это будет или nginx.conf, где лежат общие конфигурации всего сервера, или файлы конфигурации отдельных сайтов, которые, как правило, находятся по адресу etc/nginx/sites-available.

X-Robots-Tag оперирует теми же директивами и значениями атрибутов, что и метатег robots. Это из хороших новостей. Из тех, что не очень: даже малюсенькая ошибочка в синтаксисе может положить ваш сайт, причем целиком. Так что два совета:

- при каких-либо сомнениях в собственных силах, лучше доверьте внедрение X-Robots-Tag тем, кто уже имеет подобный опыт;

- не забывайте про бекапы — они ваши лучшие друзья.

Подсказка: если вы используете CDN (Content Delivery Network), поддерживающий бессерверную архитектуру приложений для Edge SEO, вы можете изменить как метатеги роботов, так и X-Robots-теги на пограничном сервере, не внося изменений в кодовую базу.

Когда использовать метатеги robots, а когда — X-Robots-tag

Да, внедрение метатегов robots хоть и выглядит более простым и понятным, но зачастую их применение ограничено. Рассмотрим три примера.

Файлы, отличные от HTML

Ситуация: нужно впихнуть невпихуемое.

Фишка в том, что у вас не получится внедрить фрагмент HTML-кода в изображения или, например, в PDF-документы. В таком случае X-Robots-Tag — безальтернативное решение.

Вот такой фрагмент кода задаст HTTP-заголовок со значением noindex для всех PDF-документов на сайте для сервера Apache:

Header set X-Robots-Tag «noindex»А такой — для nginx:

location ~* \.pdf$ { add_header X-Robots-Tag «noindex»; }Масштабирование директив

Если есть необходимость закрыть от индексации целый домен (поддомен), директорию (поддиректорию), страницы с определенными параметрами или что-то другое, что требует массового редактирования, ответ будет один: используйте X-Robots-Tag. Можно, конечно, и через метатеги, но так будет проще. Правда.

Можно, конечно, и через метатеги, но так будет проще. Правда.

Изменения заголовка HTTP можно сопоставить с URL-адресами и именами файлов с помощью различных регулярных выражений. Массовое редактирование в HTML с использованием функции поиска и замены, как правило, требует больше времени и вычислительных мощностей.

Трафик с поисковых систем, отличных от Google

Google поддерживает оба способа — и robots, и X-Robots-Tag. «Яндекс» хоть и с отставанием, но в конце концов научился понимать X-Robots-Tag и успешно его поддерживает. Но, например, чешский поисковик Seznam поддерживает только метатеги robots, так что пытаться закрыть сканирование и индексирование через HTTP-заголовок не стоит. Поисковик просто не поймет вас. Придется работать с HTML-версткой.

Как избежать ошибок доступности краулинга и деиндексирования страниц

Вам, естественно, нужно показать пользователям все ваши страницы с полезным контентом, избежать дублированного контента, всевозможных проблем и не допустить попадания определенных страниц в индекс. А если у вас немаленький сайт с тысячами страниц, то приходится переживать еще и за краулинговый бюджет. Это вообще отдельный разговор.

А если у вас немаленький сайт с тысячами страниц, то приходится переживать еще и за краулинговый бюджет. Это вообще отдельный разговор.

Давайте пробежимся по распространенным ошибкам, которые допускают люди в отношении директив для роботов.

Ошибка 1. Внедрение noindex-директив для страниц, закрытых через robots.txt

Официальные инструкции основных поисковых систем гласят:

«Яндекс»GoogleНикогда не закрывайте через disallow в robots.txt те страницы, которые вы пытаетесь удалить из индекса. Краулеры поисковых систем просто не будут переобходить такие страницы и, следовательно, не увидят изменения в noindex-директивах.

Если вас не покидает чувство, что вы уже совершили подобную ошибку в прошлом, то не помешает выяснить истину через Ahrefs Site Audit. Смотрите на страницы, отмеченные ошибкой noindex page receives organic traffic («закрытые от индексации страницы, на которые идет органический трафик»).

Если на ваши страницы с директивой noindex идет органический трафик, то очевидно, что они все еще в индексе, и вполне вероятно, что робот их не просканировал из-за запрета в robots.txt. Проверьте и исправьте, если это так.

Ошибка 2. Плохие навыки работы с sitemap.xml

Если вы пытаетесь удалить контент из индекса, используя метатеги robots или X-Robots-Tag, то не стоит удалять их из вашей карты сайта до момента их деиндексации. В противном случае переобход этих страниц может занять у Google больше времени.

— …ускоряет ли процесс деиндексации отправка Sitemap.xml с URL, отмеченным как noindex?

— В принципе все, что вы внесете в sitemap.xml, будет рассмотрено быстрее.

Для того чтобы потенциально ускорить деиндексацию ваших страниц, установите дату последнего изменения вашей карты сайта на дату добавления тега noindex. Это спровоцирует переобход и переиндексацию.

Это спровоцирует переобход и переиндексацию.

Еще один трюк, который вы можете проделать, — загрузить sitemap.xml с датой последней модификации, совпадающей с датой, когда вы отметили страницу 404, чтобы вызвать переобход.

Джон Мюллер говорит здесь про страницы с ошибкой 404, но можно полагать, что это высказывание справедливо и для директив noindex.

Важное замечание

Не оставляйте страницы, отмеченные директивой noindex, в карте сайта на долгое время. Как только они выпадут из индекса, удаляйте их.

Если вы переживаете, что старый, успешно деиндексированный контент по каким-то причинам все еще может быть в индексе, проверьте наличие ошибок noindex page sitemap в Ahrefs Site Audit.

Ошибка 3. Оставлять директивы noindex на страницах, которые уже не находятся на стадии разработки

Закрывать от сканирования и индексации все, что находится на стадии разработки, — это нормальная, хорошая практика. Тем не менее, иногда продукт выходит на следующую стадию с директивами noindex или закрытым через robots.txt доступом к нему. Органического трафика в таком случае вы не дождетесь.

Тем не менее, иногда продукт выходит на следующую стадию с директивами noindex или закрытым через robots.txt доступом к нему. Органического трафика в таком случае вы не дождетесь.

Более того, иногда падение органического трафика может протекать незамеченным на фоне миграции сайта через 301-редиректы. Если новые адреса страниц содержат директивы noindex, или в robots.txt прописано правило disallow, то вы будете получать органический трафик через старые URL, пока они будут в индексе. Их деиндексация поисковой системой может затянуться на несколько недель.

Чтобы предотвратить подобные ошибки в будущем, стоит добавить в чек-лист разработчиков пункт о необходимости удалять правила disallow в robots.txt и директивы noindex перед отправкой в продакшен.

Ошибка 4. Добавление «секретных» URL в robots.txt вместо запрета их индексации

Разработчики часто стараются спрятать страницы о грядущих промоакциях, скидках или запуске нового продукта через правило disallow в файле robots. txt. Работает это так себе, потому что кто угодно может открыть такой файл, и, как следствие, информация зачастую сливается в интернет.

txt. Работает это так себе, потому что кто угодно может открыть такой файл, и, как следствие, информация зачастую сливается в интернет.

Не запрещайте их в robots.txt, а закрывайте индексацию через метатеги или HTTP-заголовки.

Заключение

Правильное понимание и правильное управление сканированием и индексацией вашего сайта крайне важны для поисковой оптимизации. Техническое SEO может быть довольно запутанным и на первый взгляд сложным, но метатегов robots уж точно бояться не стоит. Надеемся, что теперь вы готовы применять их на практике!

Зачем в SEO использовать noindex и nofollow

Первое на что стоит обратить внимание, это на то, что существует несколько разных понятий: атрибут – rel=”nofollow”, тег – <noindex> и метатег – <meta name=”robots” content=”noindex, nofollow” />.

Ниже в статье мы подробнее разберёмся с определениями и предназначениями данных понятий.

Тег noindex

С помощью тега noindex можно выделить отдельный фрагмент текста и закрыть его от индексации робота поисковой системы. Также с его помощью, можно блокировать индексацию отдельных страниц сайта, которые предназначены для публикации пользовательского контента например, страницы с отзывами или комментариями и пр.

Также с его помощью, можно блокировать индексацию отдельных страниц сайта, которые предназначены для публикации пользовательского контента например, страницы с отзывами или комментариями и пр.

Данный тег в HTML-коде может прописываться где угодно вне зависимости от уровня вложенности. Пример написания тега выглядит следующим образом:

- < !—noindex— >текст, который мы хотим скрыть от индексации<!—/noindex— >

- <noindex>ссылка, которою необходимо скрыть от индексации</noindex>

Важно знать, что тег noindex не учитывается ПС Google. Система попросту игнорирует его присутствие и проводит полную индексацию текстового содержания на страницах сайта.

Атрибут nofollow

В HTML-коде nofollow, является одним из множества значений, которое способно принимать атрибут rel. Использование данного атрибута rel=”nofollow” полагается в том, что бы запрещать роботам ПС индексировать и переходить по активной ссылке, на которой стоит данный атрибут.

В коде, rel=”nofollow” выглядит следующим образом:

<a href=»https://site.com/» rel=»nofollow»>текст ссылки</a>

Причины, по которым стоит пользоваться атрибутом nofollow

На самом деле есть множество причин, по которым стоит запрещать индексацию ссылок, перечислим самые актуальные и важные из них.

- Ссылка на некачественный или нетематический сайт.

- Огромное количество ссылок ведущие на сторонние ресурсы.

- Защита от тех ссылок, что оставили пользователи в комментариях или отзывах.

- Перераспределение и сохранение веса страниц.

- Потребность в создании естественного ссылочного профиля.

Также, можно использовать одновременно тех noindex и атрибут nofollow, выглядеть данное сочетание будет так:

<noindex><a href=»http://site.com/» rel=»nofollow»>текст ссылки</a></noindex>

Что правда, такой метод работать полноценно не будет для роботов ПС Google, так как они понимают только атрибут – rel=»nofollow».

Мета-тег <meta name=”robots” content=”noindex, nofollow” />

Для начала рассмотрим, что такое метатег robots и зачем он нужен. Мета-тег robots – это код гипертекстовой разметки, который позволяет контролировать индексирование и показ страниц веб-сайта в результатах поиска. Метатег, можно писать на любой странице ресурса в специально отведённом для него месте в HTML-коде в теге <head>. Во время индексирования, Поисковые роботы будут читать значение мета-тега robots и учитывать его в дальнейшей работе над ресурсом.

Выглядит метатег robots следующим образом:

<meta name=»robots» content=» » />

Между кавычек content указываются следующие команды для поисковых роботов:

- Index;

- Noindex;

- Follow;

- Nofollow и пр.

Суть значений в мета-теге robots команд noindex и nofollow

- запрещать индексацию на уровне страницы, при этом не запрещать роботам посещать её и переходить по ссылкам.

- запрещать роботам ПС переходить по внешним и внутреннем ссылкам.

На практике комбинация <meta name=”robots” content=”noindex, nofollow” />, используются в случае, когда нужно запретить поисковым роботом индексировать контент на странице сайта и переходить по ссылкам.

Индексирование поиска блоковс помощью noindex

Вы можете запретить отображение страницы в поиске Google, указав noindex метатег в HTML-коде страницы или путем возврата заголовка noindex в HTTP

запрос. Когда робот Googlebot в следующий раз просканирует эту страницу и увидит тег или заголовок, он сбросит

эта страница полностью из результатов поиска Google, независимо от того, ссылаются ли на нее другие сайты.

noindex вступила в силу, страница не должен блокировать роботами. txt, иначе должно быть

доступный для краулера. Если страница заблокирована

robots.txt или он не может получить доступ к странице, поисковый робот никогда не увидит

txt, иначе должно быть

доступный для краулера. Если страница заблокирована

robots.txt или он не может получить доступ к странице, поисковый робот никогда не увидит noindex , и страница по-прежнему может отображаться в результатах поиска, например

если на него ссылаются другие страницы. Использование noindex полезно, если у вас нет root-доступа к вашему серверу, так как он

позволяет вам контролировать доступ к вашему сайту на постраничной основе.

Реализация

noindex Есть два способа реализовать noindex : как метатег и как HTTP-ответ.

заголовок.У них такой же эффект; выберите способ, который удобнее для вашего сайта.

Чтобы большинство поисковых роботов поисковых систем не проиндексировали страницу вашего сайта, поместите

следующий метатег в раздел вашей страницы:

Чтобы запретить только веб-сканерам Google индексировать страницу:

Вы должны знать, что некоторые поисковые роботы могут интерпретировать noindex иначе. В результате возможно, что ваша страница может

по-прежнему появляются в результатах других поисковых систем.

В результате возможно, что ваша страница может

по-прежнему появляются в результатах других поисковых систем.

Узнайте больше о метатеге noindex .

Вместо метатега вы также можете вернуть заголовок X-Robots-Tag со значением

либо noindex , либо none в вашем ответе. Вот пример

HTTP-ответ с X-Robots-Tag , инструктирующий сканеры не индексировать страницу:

HTTP / 1.1 200 ОК (…) X-Robots-Tag: noindex (…)

Узнайте больше о заголовке ответа noindex .

Помогите нам определить ваши метатеги

Нам необходимо просканировать вашу страницу, чтобы увидеть метатеги и заголовки HTTP. Если страница все еще

появляется в результатах, вероятно, потому, что мы не сканировали страницу с тех пор, как вы добавили

тег. Вы можете запросить у Google повторное сканирование страницы с помощью

Инструмент проверки URL.Другая причина также может заключаться в том, что файл robots.txt блокирует URL-адрес из сети Google.

сканеры, поэтому они не видят тег. Чтобы разблокировать свою страницу от Google, вы должны отредактировать свой

файл robots.txt. Вы можете редактировать и тестировать свой robots.txt, используя Тестер robots.txt инструмент.

Если страница все еще

появляется в результатах, вероятно, потому, что мы не сканировали страницу с тех пор, как вы добавили

тег. Вы можете запросить у Google повторное сканирование страницы с помощью

Инструмент проверки URL.Другая причина также может заключаться в том, что файл robots.txt блокирует URL-адрес из сети Google.

сканеры, поэтому они не видят тег. Чтобы разблокировать свою страницу от Google, вы должны отредактировать свой

файл robots.txt. Вы можете редактировать и тестировать свой robots.txt, используя Тестер robots.txt инструмент.

Как сказать Google не индексировать страницу в поиске

Индексирование как можно большего количества страниц вашего веб-сайта может быть очень заманчивым для маркетологов, которые пытаются повысить авторитет своей поисковой системы.

Но, хотя это правда, что публикация большего количества страниц, релевантных для определенного ключевого слова (при условии, что они также высокого качества) улучшит ваш рейтинг по этому ключевому слову, иногда на самом деле больше пользы от сохранения определенных страниц на вашем веб-сайте из из индекс поисковой системы.

… Сказать что ?!

Оставайтесь с нами, ребята. В этом посте вы узнаете, почему вы можете захотеть удалить определенные веб-страницы из SERPS (страниц результатов поисковой системы), и как именно это сделать.