Правильный robots.txt для MODX Revo

Главная » MODX Revo

MODX Revo

Автор Алексей На чтение 3 мин Просмотров 5.6к. Опубликовано Обновлено

Содержание

- Как создать robots.txt для MODX Revo

- Краткий разбор нестандартного «роботс» для CMS MODX

- Использование кириллицы

- Проверка корректности robots.txt

Сегодня мы составим правильный robots.txt для MODX Revo. Данный файл в первую очередь создается для того что бы закрыть дубли страниц и системный файлы от индексации в поисковых системах.

Как создать robots.

txt для MODX Revo

txt для MODX RevoПеред тем как начать вы должны включить ЧПУ MODX в настройках сайта.

robots.txt можно создать 2-мя способами:

Первый — прямо на компьютере при помощи блокнота создать текстовый документ с именем robots и расширением txt.

Второй — непосредственно в самом modx (создать документ — и в настройках выбрать тип содержимого txt)

Выбирайте любой способ, который больше нравится. Ну а теперь самое главное.

Правильный стандартный robots.txt для MODX Revo и Evo

User-agent: * # правила для всех роботов Disallow: /manager/ # авторизация Disallow: /assets/components/ # папка с файлами modx пакетов Disallow: /core/ # папка с системными файлами modx Disallow: /connectors/ # папка с системными файлами modx Disallow: /index.php # дубль главной страницы index.php Disallow: *?* # удаляем дубли для всех страниц (с параметрами) Disallow: *openstat= # ссылки с метками openstat Disallow: *from= # ссылки с метками from Disallow: *utm*= # ссылки с utm-метками Allow: /*.jpg # здесь и далее открываем для индексации изображения, скрипты и прочие файлы Allow: /*.jpeg Allow: /*.gif Allow: /*.png Allow: /*.pdf Allow: /*.doc Allow: /*.docx Allow: /*.xls Allow: /*.xlsx Allow: /*.ppt Allow: /*.pptx Allow: /*.css Allow: /*.js Allow: *?page= # открываем для индексации страницы пагинации (и проверьте, чтобы для них был настроен canonical) # Укажите один или несколько файлов Sitemap Sitemap: http://site.ru/sitemap.xml

Также часто на хостингах в директориях сайта, есть папка cgi-bin, ее тоже закрываем от индексации: Disallow: /cgi-bin

Если вы используете модуль pThumb (phpThumbOf или phpThumbOn), то желательно открыть для индексации обрезанные изображения:

Allow: /core/cache/phpthumb/*.jpeg

Allow: /core/cache/phpthumb/*.png

Allow: /core/cache/phpthumb/*.svg

Раньше еще указывали директиву host (Host: сайт.ru) но ее сейчас поисковые боты не учитывают — она устарела)

Краткий разбор нестандартного «роботс» для CMS MODX

Использование кириллицы

Использование кириллицы запрещено в файле robots. txt и HTTP-заголовках сервера.

txt и HTTP-заголовках сервера.

Для указания имен кириллических доменов и папок с русскими именами используйте Punycode. Названия указывайте в кодировке, соответствующей кодировке текущей структуры сайта. Пример для указания сайтмапа для http://сайт.рф:

Sitemap: http://xn--80aswg.xn--p1ai/sitemap.xml

Проверка корректности robots.txt

Анализ robots.txt от Yandex (нужна авторизация).

Анализ robots.txt от Google (нужна авторизация).

Если у вас есть какие либо вопросы или предложения по правильному составлению robots.txt для CMS MODX пишите в комментариях.

modx robots.txt robots txt modx revo

Поделиться с друзьями

Оцените автора

( 1 оценка, среднее 5 из 5 )

Создание и настройка robots.txt для MODX Revolution

Главная » CMS »

После создания файла sitemap.

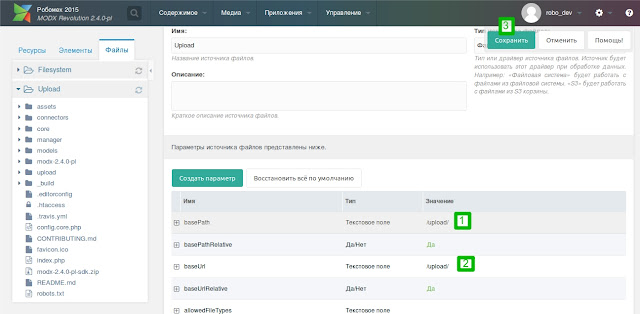

Самый простой и универсальный способ создания файла robots.txt это создать его непосредственно на своём компьютере, а затем загрузить в корень сайта. Просто откройте текстовый редактор, создайте файл с именем robots и задайте ему расширение txt.

Другой способ создать robots.txt для MODX Revolution — создать его непосредственно из «админки». Сразу скажу, что «универсального» или «правильного» файла robots.txt не существует. Вы наполняете его в соответствии с вашими потребностями. Ниже я приведу пример такого файла и прокомментирую его содержимое.

User-agent: * Disallow: /cgi-bin/ Disallow: /manager/ Disallow: /assets/components/ Disallow: /core/ Disallow: /connectors/ Disallow: /index.php Disallow: *? Allow: /core/cache/phpthumb/*.jpeg Allow: /core/cache/phpthumb/*.png Allow: /core/cache/phpthumb/*.svg Host: [URL-сайта] Sitemap: [URL-сайта]/sitemap.xml

Первая строчка (User-agent: *) говорит нам о том, что настройки применяются ко всем поисковым роботам.

Строки, начинающиеся с Disallow, запрещают индексирование указанных каталогов. Какие каталоги мы закрыли?

cgi-bin — папка для CGI-скриптов, может содержать файлы конфигурации;

manager — каталог админ-панели MODX;

assets/components — каталог с дополнениями;

core — каталог ядра CMS;

connectors — каталог точек входа для AJAX-запросов;

index.php — дубль главной страницы сайта;

Ну а *? поможет избавиться от дублей страниц.

Отметим, что даже если вы не собираетесь ничего закрывать, оставьте в файле строку

Disallow:

Дело в том, что инструкция Disallow является обязательной в robots. txt, и без неё робот может «не понять» файл.

txt, и без неё робот может «не понять» файл.

Строки, которые начинаются с Allow, открывают доступ к определенным частям сайта. На самом деле, поисковый робот сканирует всё, что не помечено Disallow, но что делать, если нужно открыть доступ к определенным файлам или подкаталогам в закрытом каталоге? Тогда и используется Allow. Так, хотя мы и закрыли доступ к папке core, но разрешаем сканирование изображений в /core/cache/phpthumb/.

Директива Host нужна для поискового робота Яндекса. Если вы используете протокол HTTPS, то URL сайта в этой строке нужно указать с ним. При использовании HTTP протокол указывать не нужно. Однако, в свете последних событий, использование директивы Host выглядит не обязательным.

Наконец, мы указываем поисковым работам точное расположение файла sitemap.xml.

После окончания редактирования положите файл robots.txt в корень сайта (обычно каталог public_html).

Рубрики CMS, MODX

Опубликовано Автор Евгений

Новый элемент управления robots.txt в MODX Cloud

Сегодня мы объявляем о новой функции в облаке, которая упрощает обработку файлов robots.txt, добавляя новые возможности для уникальных файлов robots.txt для каждого имени хоста для многосайтовых установок.

Авторы: Ryan Thrash, Mike Schell

19 октября 2017 г.

Облачная версия MODX

Сегодня мы объявляем о новой функции в облаке, которая упрощает обработку файлов robots.txt, предлагая новые возможности для уникальных роботов. txt на имя хоста для многосайтовых установок.

Что такое robots.txt?

Файл /robots.txt — это необязательный файл, который позволяет веб-мастеру явно сообщать хорошо работающим веб-роботам, таким как пауки поискового индекса, о том, как им следует сканировать веб-сайт. Если файл robots.txt отсутствует, большинство роботов должны продолжить сканирование и индексацию сайта.

Это полезно, когда владельцы сайтов используют сайт разработки или промежуточный сайт для текущей работы, а также изолированный рабочий сайт, на котором развертываются изменения и обновления. Вы можете указать веб-роботам игнорировать сайт разработки, разрешив при этом индексирование рабочего сайта.

Robots.txt в MODX Cloud

Ранее MODX Cloud предоставлял пользователям контроль над поведением, разрешая обслуживание пользовательского файла robots.txt на основе переключателя на панели инструментов. Хотя это было полезно, можно было случайно разрешить индексирование на промежуточных/разрабатываемых сайтах, переключив параметр на панели инструментов. Точно так же можно было легко запретить индексацию на рабочем сайте.

Сегодня мы полностью удаляем этот интерфейс и полагаемся на наличие файлов robots.txt в файловой системе со следующим исключением: любой домен, оканчивающийся на modxcloud.com будет обслуживаться директивой Disallow: / для всех пользовательских агентов, независимо от наличия или отсутствия файла robots. txt.

txt.

Для рабочих сайтов (тех, которые получают реальный трафик посетителей) вам нужно будет использовать собственный домен, если вы хотите, чтобы ваш сайт был проиндексирован.

Подавать уникальные файлы robots.txt для каждого имени хоста в MODX Cloud

Некоторые организации используют MODX Revolution для запуска нескольких веб-сайтов из одной установки с использованием контекстов . Случаи, когда это может применяться, могут быть общедоступными маркетинговыми сайтами в сочетании с микросайтами целевых страниц и, возможно, закрытым интранетом.

Большинство владельцев сайтов хотят, чтобы их сайты были проиндексированы. В облаке MODX все сайты с пользовательскими именами хостов будут возвращаться к обслуживанию любого загруженного файла robots.txt в корневом каталоге веб-сайта, обычно со следующим содержимым:

User-agent: * Disallow:

Однако для гипотетической интрасети, использующей intranet.example.com в качестве имени хоста, вы бы не хотели, чтобы она индексировалась. Традиционно это было сложно сделать при многосайтовых установках, потому что они использовали один и тот же веб-корневой каталог. Однако в MODX Cloud это просто. Просто загрузите дополнительный файл в свой веб-каталог с именем 9.0025 robots-intranet.example.com.txt со следующим содержимым, и он заблокирует индексирование роботами с хорошим поведением, а все остальные имена хостов вернутся к стандартному файлу robots.txt, если не существует других имен хостов:

Традиционно это было сложно сделать при многосайтовых установках, потому что они использовали один и тот же веб-корневой каталог. Однако в MODX Cloud это просто. Просто загрузите дополнительный файл в свой веб-каталог с именем 9.0025 robots-intranet.example.com.txt со следующим содержимым, и он заблокирует индексирование роботами с хорошим поведением, а все остальные имена хостов вернутся к стандартному файлу robots.txt, если не существует других имен хостов:

Пользовательский агент: * Disallow: /

Нужно ли что-то делать?

Все новые облака будут работать, как описано выше, начиная с этого момента. См. наше примечание о поведении robots.txt для облаков, созданных до 19 октября 2017 г.

Подробнее

Понимание того, как robots.txt влияет на ваши сайты в поисковых системах, является важным аспектом управления сайтом. Узнайте больше о robots.txt на robotstxt.org. Также добавьте в закладки нашу документацию по обработке robots.txt в облаке MODX. И если вы хотите начать использовать эту новую возможность в MODX Cloud, войдите в свою панель инструментов или создайте учетную запись сегодня.

И если вы хотите начать использовать эту новую возможность в MODX Cloud, войдите в свою панель инструментов или создайте учетную запись сегодня.

Подпишитесь на MODX Cloud!

Написаностатей | без ума от Брайтона

Samba, используя протокол SMB, позволяет вам делиться своими файлами и папками с другими клиентами. Эта статья покажет вам, как создать и настроить такой общий ресурс.

линукс нас убунту

Существует множество способов управления пулами ZFS. Эта статья содержит несколько полезных команд и примеров. Они подходят для любой конфигурации виртуальных устройств, включая зеркальные, RAIDZ или без резервирования.

линукс нас убунту ZFS

Наступит момент, когда вам нужно будет заменить один из ваших дисков в вашем пуле ZFS. Возможно, диск стал недоступен или вы получаете ошибки чтения/записи. Метод будет одинаковым, независимо от того, используете ли вы зеркальную конфигурацию или конфигурацию виртуального устройства RAIDZ.

Возможно, диск стал недоступен или вы получаете ошибки чтения/записи. Метод будет одинаковым, независимо от того, используете ли вы зеркальную конфигурацию или конфигурацию виртуального устройства RAIDZ.линукс нас убунту ZFS

Файловая система Z (ZFS) может использоваться для объединения нескольких дисков. Например, к вашему компьютеру можно подключить три диска по 2 ТБ, чтобы создать единый пул с емкостью хранилища 6 ТБ.

линукс нас убунту ZFS

MODX Revolution, как и все CMS, может быть использован недобросовестными людьми. Вот некоторые изменения, которые сделают вашу установку MODX более надежной и трудной для взлома.

линукс модкс

При использовании MODX Revolution весьма вероятно, что в какой-то момент вам придется копировать настройки из одной папки в другую или даже с одного сервера на другой. Вот прямой способ сделать такой ход.

Вот прямой способ сделать такой ход.

линукс модкс

Если к вашему источнику мультимедиа подключено более одного устройства Kodi, будет очень полезно, если они будут использовать одну и ту же медиатеку. Это делается с помощью базы данных mySQL на вашем медиа-сервере.

убунту коди mysql

Файл robots.txt — важный инструмент при оптимизации веб-сайта. Он сообщает веб-роботам и паукам, к каким областям сайта они могут получить доступ.

апач веб сервер

MODX Revolution регулярно обновляется новыми функциями и исправлениями безопасности. Но процесс обновления может быть довольно сложным. Вот простой способ обновления MODX до текущей версии на вашем веб-сервере Linux с использованием SSH.

Вот простой способ обновления MODX до текущей версии на вашем веб-сервере Linux с использованием SSH.

линукс модкс

Со временем в вашем пуле ZFS больше не будет достаточно места для хранения. Когда это произойдет, вам нужно будет добавить несколько дисков или заменить старые диски на новые, большего размера. Поскольку у меня больше нет свободных портов SATA, я собираюсь сделать последнее, заменив все свои 2 ТБ диски на 6 ТБ.

линукс нас убунту ZFS

Я хочу использовать пульт от телевизора для управления медиаплеером. Поскольку понимание инфракрасных команд теперь встроено в ядро Ubuntu, я хотел отказаться от использования lirc и вместо этого использовать ir-keytable. Цель состоит в том, чтобы управлять Коди с минимумом суеты!

линукс убунту коди хбмк

У меня есть видео в формате MKV. Видео на английском, но есть части на иностранном языке. Я хочу, чтобы субтитры появлялись, когда говорят на любом иностранном языке.

Видео на английском, но есть части на иностранном языке. Я хочу, чтобы субтитры появлялись, когда говорят на любом иностранном языке.

линукс mkvmerge

У меня есть клиентский компьютер с Kodi на Ubuntu. У меня также есть отдельный компьютер, выступающий в роли сервера. Когда я включаю клиентский компьютер, я хочу, чтобы сервер тоже включался.

линукс убунту

Wake-on-Lan (WoL) позволяет удаленно включать компьютер. Это идеально, если у вас есть машина в другой комнате, например, сервер в труднодоступном месте. Машина просыпается, когда получает специальное сообщение, называемое волшебным пакетом. Вы можете отправлять волшебные пакеты с других компьютеров или даже со своего мобильного телефона. Сообщение отправляется по вашей сети с использованием Wi-Fi или проводного соединения.

jpg # здесь и далее открываем для индексации изображения, скрипты и прочие файлы

Allow: /*.jpeg

Allow: /*.gif

Allow: /*.png

Allow: /*.pdf

Allow: /*.doc

Allow: /*.docx

Allow: /*.xls

Allow: /*.xlsx

Allow: /*.ppt

Allow: /*.pptx

Allow: /*.css

Allow: /*.js

Allow: *?page= # открываем для индексации страницы пагинации (и проверьте, чтобы для них был настроен canonical)

# Укажите один или несколько файлов Sitemap

Sitemap: http://site.ru/sitemap.xml

jpg # здесь и далее открываем для индексации изображения, скрипты и прочие файлы

Allow: /*.jpeg

Allow: /*.gif

Allow: /*.png

Allow: /*.pdf

Allow: /*.doc

Allow: /*.docx

Allow: /*.xls

Allow: /*.xlsx

Allow: /*.ppt

Allow: /*.pptx

Allow: /*.css

Allow: /*.js

Allow: *?page= # открываем для индексации страницы пагинации (и проверьте, чтобы для них был настроен canonical)

# Укажите один или несколько файлов Sitemap

Sitemap: http://site.ru/sitemap.xml php

Disallow: *?

Allow: /core/cache/phpthumb/*.jpeg

Allow: /core/cache/phpthumb/*.png

Allow: /core/cache/phpthumb/*.svg

Host: [URL-сайта]

Sitemap: [URL-сайта]/sitemap.xml

php

Disallow: *?

Allow: /core/cache/phpthumb/*.jpeg

Allow: /core/cache/phpthumb/*.png

Allow: /core/cache/phpthumb/*.svg

Host: [URL-сайта]

Sitemap: [URL-сайта]/sitemap.xml