Как запретить индексирование сайта или страниц

Иногда нужно, чтобы страницы сайта или размещенные на них ссылки не появлялись в результатах поиска. Скрыть содержимое сайта от индексирования можно с помощью файла robots.txt, HTML-разметки или авторизации на сайте.

- Запретить индексирование сайта, раздела или страницы

- Запретить индексирование части текста страницы

- Скрыть от индексирования ссылку на странице

Если какие-то страницы или разделы сайта не должны индексироваться (например, со служебной или конфиденциальной информацией), ограничьте доступ к ним следующими способами:

В файле robots.txt укажите директиву Disallow.

В HTML-коде страниц сайта укажите метатег robots с директивой noindex или none. Подробнее см. в разделе Метатег robots и HTTP-заголовок X-Robots-Tag.

Используйте авторизацию на сайте. Рекомендуем этот способ, чтобы скрыть от индексирования главную страницу сайта. Если главная страница запрещена в файле robots.

Скрыть от индексирования часть текста можно несколькими способами:

В HTML-код страницы добавьте элемент noindex. Например:

<noindex>текст, индексирование которого нужно запретить</noindex>

Элемент не чувствителен к вложенности — может находиться в любом месте HTML-кода страницы. Если на странице отсутствует закрывающий тег, скрытым считается весь контент страницы. Не создавайте множественную вложенность тегов noindex — разметка будет учитываться только до первого закрывающего тега.

При необходимости сделать код сайта валидным возможно использование тега в следующем формате:

<!--noindex-->текст, индексирование которого нужно запретить<!--/noindex-->

В HTML-код страницы добавьте элемент noscript. Например:

<noscript>текст, индексирование которого нужно запретить</noscript>

Элемент noscript, как и noindex, запрещает индексирование, но при этом скрывает содержимое сайта от пользователя, если его браузер поддерживает технологию JavaScript.

Примечание. JavaScript поддерживают все популярные браузеры, если эта функция не отключена пользователем специально.

Посмотреть отчет о наличии JavaScript можно в Яндекс Метрике .

Рекомендуем использовать атрибут rel. Разные значения атрибута указывают на тип ссылки, что помогает поисковой системе лучше распознавать содержимое сайта.

rel=»ugc». Используйте, если на вашем сайте есть форум или возможность оставить отзыв и вы не уверены в качестве ссылок, которые оставляют посетители.

rel=»sponsored». Используйте, если ссылка носит рекламный характер, указывает на рекламное место или размещение в рамках партнерской программы с другим сайтом.

rel=»nofollow». Указывайте, чтобы робот не проходил по ссылке, не зависимо от ее типа.

Можно комбинировать несколько значений. Пример:

<a href="url" rel="nofollow,sponsored">текст ссылки</a> или <a href="url" rel="nofollow sponsored">текст ссылки</a>

Значения атрибута rel воспринимаются роботом как рекомендация не принимать ссылку во внимание.

Чтобы скрыть от индексирования все ссылки на странице, укажите в HTML-коде страницы метатег robots с директивой nofollow. Робот не перейдет по ссылкам при обходе сайта, но может узнать о них из других источников. Например, на других страницах или сайтах.

При использовании любого из перечисленных указаний ссылка может быть обработана роботом и отобразиться в Вебмастере как внутренняя или внешняя. Само отображение или отсутствие ссылки в Вебмастере не указывает на то, что поисковые алгоритмы учитывают ее.

Как полностью скрыть сайт от индексации?

#Оптимизация сайта #Индексация

#7

Ноябрь’17

17

Ноябрь’17

17

Про то, как закрыть от индексации отдельную страницу и для чего это нужно мы уже писали. Но могут возникнуть случаи, когда от индексации надо закрыть весь сайт или зеркало, что проблематичнее. Существует несколько способов. О них мы сегодня и расскажем.

Существует несколько способов. О них мы сегодня и расскажем.

Существует несколько способов закрыть сайт от индексации.

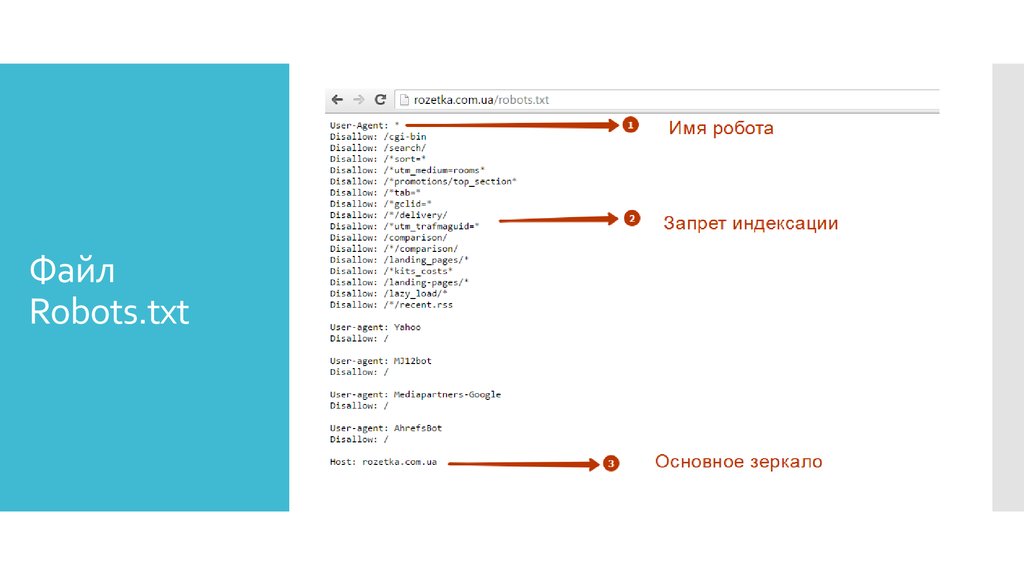

Запрет в файле robots.txt

Файл robots.txt отвечает за индексацию сайта поисковыми роботами. Найти его можно в корневой папке сайта. Если же его не существует, то его необходимо создать в любом текстовом редакторе и перенести в нужную директорию. В файле должны находиться всего лишь две строчки:

User-agent: *

Disallow: /

Остальные правила должны быть удалены.

Этот метод самый простой для скрытия сайта от индексации.

С помощью мета-тега robots

Прописав в шаблоне страниц сайта следующее правило <meta name=»robots» content=»noindex, nofollow»/> или <meta name=»robots» content=»none»/> в теге <head>, вы запретите его индексацию.

Как закрыть зеркало сайта от индексации

Зеркало — точная копия сайта, доступная по другому домену. Т.е. два разных домена настроены на одну и ту же папку с сайтом. Цели создания зеркал могут быть разные, но в любом случае мы получаем полную копию сайта, которую рекомендуется закрыть от индексации.

Цели создания зеркал могут быть разные, но в любом случае мы получаем полную копию сайта, которую рекомендуется закрыть от индексации.

Сделать это стандартными способами невозможно, т.к. по адресам domen1.ru/robots.txt и domen2.ru/robots.txt открывается один и тот же файл robots.txt с одинаковым содержанием. В таком случае необходимо провести специальные настройки на сервере, которые позволят одному из доменов отдавать запрещающий robots.txt.

Похожее

Оптимизация сайта Индексация

Атрибут rel=canonical

Оптимизация сайта Индексация

Индексация ссылок

Оптимизация сайта Индексация

#133

Атрибут rel=canonical

Январь’23

11546

22Оптимизация сайта Индексация

#119

Индексация ссылок

Апрель’19

4551

30Оптимизация сайта Индексация

#111

Описание и настройка директивы Clean-param

Апрель’19

9028

Оптимизация сайта Индексация

#104

Как привлечь быстроробота Яндекс

Февраль’19

2237

21Оптимизация сайта Индексация

#94

Проверка индекса сайта. Как найти мусорные или недостающие страницы

Как найти мусорные или недостающие страницы

Декабрь’18

9163

28Оптимизация сайта Индексация

#86

Как закрыть ссылки и текст от поисковых систем

Ноябрь’18

5767 22Оптимизация сайта Индексация

#82

Почему Яндекс удаляет страницы из поиска

Ноябрь’18

3127

19Оптимизация сайта Индексация

#60

Правильная индексация страниц пагинации

Февраль’18

7901

19Оптимизация сайта Индексация

#47

Как узнать дату индексации страницы

Ноябрь’17

7617

18#46

Какие страницы надо закрывать от индексации

Ноябрь’17

10336

18Оптимизация сайта Индексация

#38

Как удалить страницу из индекса Яндекса и Google

Ноябрь’17

13595

20Оптимизация сайта Индексация

#37

Как добавить страницу в поиск Яндекса и Google

Апрель’17

19235

19Оптимизация сайта Индексация

#2

Как проверить индексацию сайта в поисковых системах

Ноябрь’17

17244

27Оптимизация сайта Индексация

#1

Как ускорить индексацию сайта

Ноябрь’17

5633

29Как использовать robots.

txt для разрешения или запрета всего

txt для разрешения или запрета всегоФайл robots.txt — это файл, расположенный в корневом домене.

Это простой текстовый файл, основной целью которого является указание поисковым роботам и поисковым роботам файлов и папок, от которых следует держаться подальше.

Роботы поисковых систем — это программы, которые посещают ваш сайт и переходят по ссылкам на нем, чтобы узнать о ваших страницах. Примером может служить поисковый робот Google, который называется Googlebot.

Обычно боты проверяют файл robots.txt перед посещением вашего сайта. Они делают это, чтобы узнать, разрешено ли им сканировать сайт и есть ли вещи, которых следует избегать.

Файл robots.txt следует поместить в каталог верхнего уровня вашего домена, например, example.com/robots.txt.

Лучший способ отредактировать его — войти на свой веб-хост через бесплатный FTP-клиент, такой как FileZilla, а затем отредактировать файл с помощью текстового редактора, такого как Блокнот (Windows) или TextEdit (Mac).

Если вы не знаете, как войти на свой сервер через FTP, обратитесь в свою хостинговую компанию за инструкциями.

Некоторые плагины, такие как Yoast SEO, также позволяют редактировать файл robots.txt из панели управления WordPress.

Как запретить всем использовать robots.txt

Если вы хотите, чтобы все роботы держались подальше от вашего сайта, то этот код вы должны поместить в свой robots.txt, чтобы запретить все:

User-agent: * Disallow: /

Часть «User-agent: *» означает, что применяется ко всем роботам. Часть «Запретить: /» означает, что она применяется ко всему вашему сайту.

По сути, это сообщит всем роботам и поисковым роботам, что им не разрешен доступ к вашему сайту или его сканирование.

Важно: Запрет всех роботов на действующем веб-сайте может привести к удалению вашего сайта из поисковых систем и потере трафика и доходов. Используйте это, только если вы знаете, что делаете!

Как разрешить все

Robots. txt работает преимущественно путем исключения. Вы исключаете файлы и папки, к которым не хотите получать доступ, все остальное считается разрешенным.

txt работает преимущественно путем исключения. Вы исключаете файлы и папки, к которым не хотите получать доступ, все остальное считается разрешенным.

Если вы хотите, чтобы боты могли сканировать весь ваш сайт, вы можете просто иметь пустой файл или вообще не иметь файла.

Или вы можете поместить это в свой файл robots.txt, чтобы разрешить все:

Агент пользователя: * Disallow:

Это интерпретируется как запрещение ничего, поэтому фактически разрешено все.

Как запретить определенные файлы и папки

Вы можете использовать команду «Запретить:», чтобы заблокировать отдельные файлы и папки.

Вы просто помещаете отдельную строку для каждого файла или папки, которые хотите запретить.

Вот пример:

User-agent: * Запретить: /topsy/ Запретить: /crets/ Запретить: /hidden/file.html

В этом случае разрешено все, кроме двух подпапок и одного файла.

Как запретить определенным ботам

Если вы просто хотите заблокировать сканирование одного конкретного бота, сделайте это следующим образом:

Агент пользователя: Bingbot Запретить: / Пользовательский агент: * Disallow:

Это заблокирует поисковый робот Bing от сканирования вашего сайта, но другим ботам будет разрешено сканировать все.

Вы можете сделать то же самое с Googlebot, используя «User-agent: Googlebot».

Вы также можете запретить определенным ботам доступ к определенным файлам и папкам.

Хороший файл robots.txt для WordPress

Следующий код — это то, что я использую в своем файле robots.txt. Это хорошая настройка по умолчанию для WordPress.

Агент пользователя: * Запретить: /wp-admin/ Разрешить: /wp-admin/admin-ajax.php Карта сайта: https://searchfacts.com/sitemap.xml

Этот файл robots.txt сообщает ботам, что они могут сканировать все, кроме папки /wp-admin/. Однако им разрешено сканировать один файл в папке /wp-admin/ с именем admin-ajax.php.

Причиной этого параметра является то, что Google Search Console раньше сообщала об ошибке, если не могла просканировать файл admin-ajax.php.

Googlebot — единственный бот, который понимает «Разрешить:» — он используется для разрешения обхода определенного файла внутри запрещенной папки.

Вы также можете использовать строку «Карта сайта:», чтобы сообщить ботам, где найти вашу XML-карту сайта. Эта карта сайта должна содержать список всех страниц вашего сайта, чтобы поисковым роботам было легче найти их все.

Эта карта сайта должна содержать список всех страниц вашего сайта, чтобы поисковым роботам было легче найти их все.

Когда использовать noindex вместо robots

Если вы хотите заблокировать показ всего сайта или отдельных страниц в поисковых системах, таких как Google, то robots.txt — не лучший способ сделать это.

Поисковые системы по-прежнему могут индексировать файлы, заблокированные роботами, просто они не будут показывать некоторые полезные метаданные.

Вместо этого в описании результатов поиска будет указано: «Описание этого результата недоступно из-за файла robots.txt этого сайта».

Источник: Круглый стол поисковой системыЕсли вы скрываете файл или папку с robots.txt, но потом кто-то ссылается на него, Google с большой долей вероятности покажет его в результатах поиска только без описания.

В этих случаях лучше использовать тег noindex, чтобы запретить поисковым системам отображать его в результатах поиска.

В WordPress, если вы перейдете в «Настройки» -> «Чтение» и отметите «Запретить поисковым системам индексировать этот сайт», на все ваши страницы будет добавлен тег noindex.

Выглядит так:

Вы также можете использовать бесплатный SEO-плагин, такой как Yoast или The SEO Framework, чтобы не индексировать определенные сообщения, страницы или категории на вашем сайте.

В большинстве случаев noindex лучше блокирует индексирование, чем robots.txt.

Когда вместо этого заблокировать весь сайт

В некоторых случаях может потребоваться заблокировать доступ ко всему сайту как для ботов, так и для людей.

Лучше всего для этого установить пароль на свой сайт. Это можно сделать с помощью бесплатного плагина WordPress под названием «Защищено паролем».

Важные факты о файле robots.txt

Имейте в виду, что роботы могут игнорировать ваш файл robots.txt, особенно вредоносные боты, такие как те, которыми управляют хакеры, ищущие уязвимости в системе безопасности.

Кроме того, если вы пытаетесь скрыть папку со своего веб-сайта, просто поместить ее в файл robots. txt может быть неразумным подходом.

txt может быть неразумным подходом.

Любой может увидеть файл robots.txt, если введет его в свой браузер, и может понять, что вы пытаетесь скрыть таким образом.

На самом деле, вы можете посмотреть на некоторых популярных сайтах, как настроены их файлы robots.txt. Просто попробуйте добавить /robots.txt к URL-адресу домашней страницы ваших любимых веб-сайтов.

Если вы хотите убедиться, что ваш файл robots.txt работает, вы можете протестировать его с помощью Google Search Console. Вот инструкции.

Сообщение на вынос

Файл robots.txt сообщает роботам и поисковым роботам, какие файлы и папки они могут и не могут сканировать.

Его использование может быть полезно для блокировки определенных областей вашего веб-сайта или для предотвращения сканирования вашего сайта определенными ботами.

Если вы собираетесь редактировать файл robots.txt, то будьте осторожны, ведь небольшая ошибка может иметь катастрофические последствия.

Например, если вы неправильно поместите одну косую черту, она может заблокировать всех роботов и буквально удалить весь ваш поисковый трафик, пока это не будет исправлено.

Я работал с большим сайтом до того, как однажды случайно поставил «Disallow: /» в их живой файл robots.txt. Из-за этой маленькой ошибки они потеряли много трафика и доходов.

Файл robots.txt очень мощный, поэтому обращайтесь с ним с осторожностью.

Как запретить всем использовать robots.txt?

Если вы хотите, чтобы все роботы держались подальше от вашего сайта, то этот код вы должны поместить в свой robots.txt, чтобы запретить все:

User-agent: *

Disallow: /

Как разрешить все с помощью robots.txt?

Если вы хотите, чтобы боты могли сканировать весь ваш сайт, вы можете просто иметь пустой файл или вообще не иметь файла.

Или вы можете поместить это в свой файл robots.txt, чтобы разрешить все:

User-agent: *

Disallow:

Как запретить определенные файлы и папки с robots.txt?

Вы просто помещаете отдельную строку для каждого файла или папки, которые хотите запретить.

Вот пример:

User-agent: *

Disallow: /topsy/

Disallow: /crets/

Disallow: /hidden/file. html

html

Как запретить определенных ботов с помощью robots.txt?

Если вы просто хотите заблокировать сканирование одного конкретного бота, например Bing, то вы делаете это так:

User-agent: Bingbot

Disallow: /

Какой файл robots.txt подходит для WordPress?

Следующий код — это то, что я использую в своем файле robots.txt. Это хорошая настройка по умолчанию для WordPress.

Агент пользователя: *

Запретить: /wp-admin/

Разрешить: /wp-admin/admin-ajax.php

Карта сайта: https://searchfacts.com/sitemap.xml

seo — Должен ли я удалить мета- robots (индексировать, следить), когда у меня есть файл robots.txt?

спросил

Изменено 4 года, 3 месяца назад

Просмотрено 992 раза

Я немного не понимаю, следует ли удалять метатег robots, если я хочу, чтобы поисковые системы следовали моим правилам robots. txt.

txt.

Если на странице существует метатег robots (index, follow), будут ли поисковые системы игнорировать мой файл robots.txt и индексировать указанные запрещенные URL-адреса в моем файле robots.txt?

Причина, по которой я спрашиваю об этом, заключается в том, что поисковые системы (в основном Google) по-прежнему индексируют запрещенные страницы моего сайта.

- поисковая оптимизация

- метатеги

- robots.txt

0

Если бот поисковой системы учитывает ваш robots.txt и вы запрещаете сканирование /foo , то бот никогда не будет сканировать страницы, пути URL которых начинаются с /foo . Следовательно, бот никогда не узнает, что их 9.0202 мета — роботы элемента.

И наоборот, если вы хотите запретить индексировать страницу (указав meta — robots с noindex ), вы не должны запрещать сканирование этой страницы в файле robots. txt. В противном случае доступ к

txt. В противном случае доступ к noindex никогда не осуществляется, и бот считает, что сканирует , а не индексирует .

С помощью файла robots.txt вы можете указать поисковым системам не сканировать определенные страницы, но это не помешает им индексировать страницы. Если страница, запрещенная в robots.txt, будет найдена сканером по внешней ссылке, она может быть проиндексирована. Это можно предотвратить с помощью метатега. Таким образом, robots.txt и метатег работают по-разному.

https://developers.google.com/search/reference/robots_meta_tag?hl=en#combining-crawling-with-indexing—serving-directives

Метатеги Robots и заголовки HTTP X-Robots-Tag обнаруживаются при сканировании URL-адреса. Если страница запрещена для сканирования через файл robots.txt, то любая информация об индексации или обслуживании директив не будет найдена и, следовательно, будет проигнорирована. Если необходимо следовать директивам индексации или обслуживания, URL-адреса, содержащие эти директивы, не могут быть запрещены для сканирования.